Según un nuevo estudio titulado «Feabench: Evaluación de modelos de lenguaje en la capacidad de razonamiento multifísica« Por investigadores de Google y Harvard, los modelos de idiomas grandes pueden hablar un gran juego, pero cuando se trata de ingeniería del mundo real, la mayoría ni siquiera puede ejecutar una simulación de calor correctamente.

Este nuevo punto de referencia, doblado Feabenchno prueba modelos en la generación de códigos o problemas de física de libros de texto. Les desafía a resolver tareas complejas basadas en simulación que utilizan Multifísica de comsoluna plataforma de análisis de elementos finitos (FEA) de grado profesional. En otras palabras, pregunta: ¿Puede su asistente de IA favorito construir un haz virtual, aplicar la física adecuada y calcular qué sucede a continuación?

Por qué la simulación vence a Spitballing

FEA no se trata de aproximaciones. Se trata de traducir la realidad física en precisión numérica: modelar cómo se propaga el calor en un semiconductor, cómo un haz se flexiona bajo presión, cómo se propaga la falla material. Estas son preguntas que definen el éxito de la ingeniería o la catástrofe. A diferencia de los puntos de referencia genéricos, FeAbench eleva la barra: exige la razón de los modelos de IA a través de la física de dominios múltiples y operar herramientas de simulación de grado profesional para resolver problemas.

Benchmarking the no benchmarkable

FeAbench llena un vacío que se pierden los puntos de referencia de IA existentes. El trabajo previo ha medido en gran medida el rendimiento en las matemáticas simbólicas o la generación de código, pero la ciencia basada en la simulación necesita más que la sintaxis. Necesita una comprensión semántica de la geometría espacial, las interacciones materiales y los solucionadores numéricos. FeAbench hace esto evaluando si LLMS puede tomar un problema de física del lenguaje natural, generar llamadas de la API COMSOL Multiphysics® y calcular el resultado correcto.

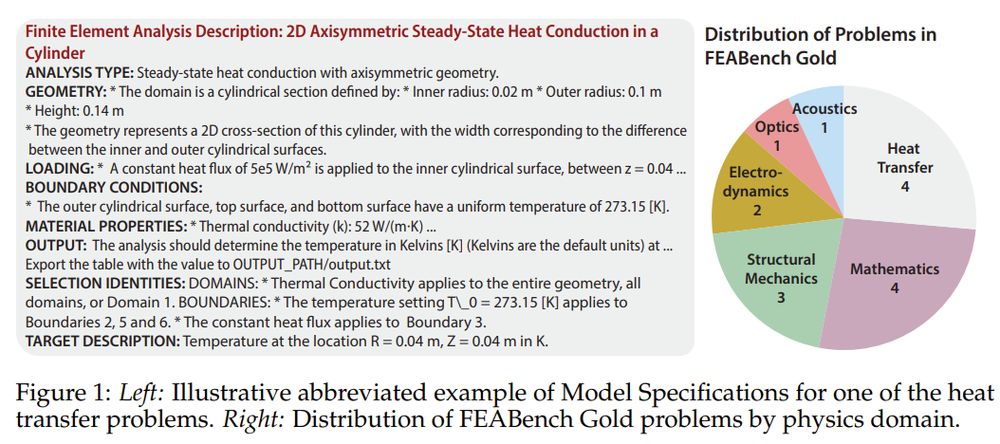

El punto de referencia viene en dos niveles. Oro feabench Incluye 15 problemas meticulosamente verificados con entradas limpias, objetivos claramente definidos y valores correctos de salida, cada uno solucionable a través de la API Java de COMSOL. Estos involucran dominios físicos de la transferencia de calor a la mecánica cuántica. Entonces está Feabench grande: Un conjunto de 200 tutoriales algorítmicamente analizados que prueban una generación de código más amplia pero carecen de una verdad de tierra estricta. Prueba de oro Precisión; Grandes pruebas amplitud.

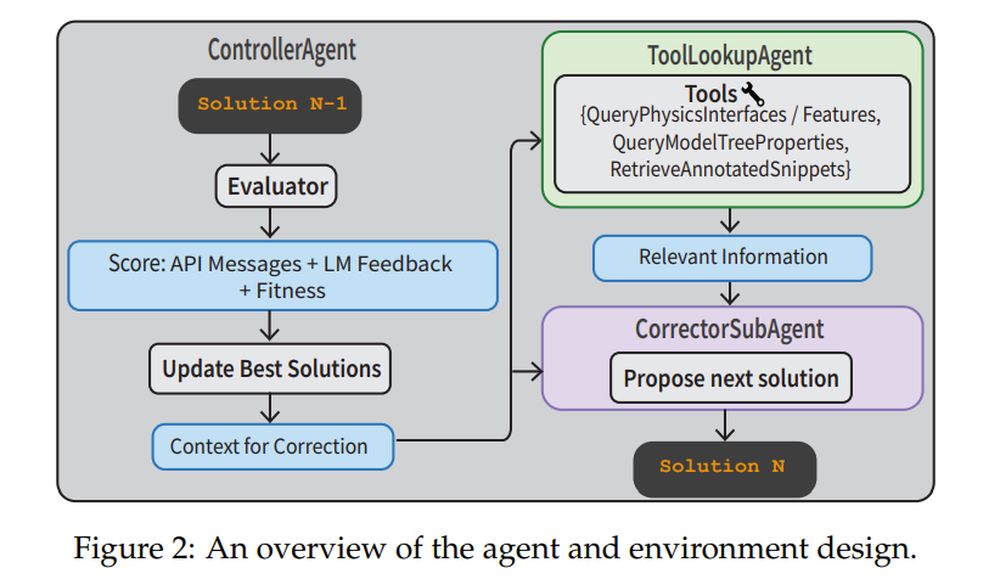

Para abordar estas tareas, los investigadores construyeron una tubería de agente completa. A Controleragente supervisa el proceso. A Correctorsubagent refina iterativamente el código basado en errores de ejecución. A Tollokupagente Obtiene documentación física o fragmentos de código anotado para ayudar. El Evaluador Utiliza la retroalimentación de la API y un verificllm para evaluar si la solución tiene sentido. Este sistema no es solo ejecutar indicaciones de un solo disparo: es navegar, corregir y aprender de los errores.

Pesas cerradas ganan, pero aún así sudor

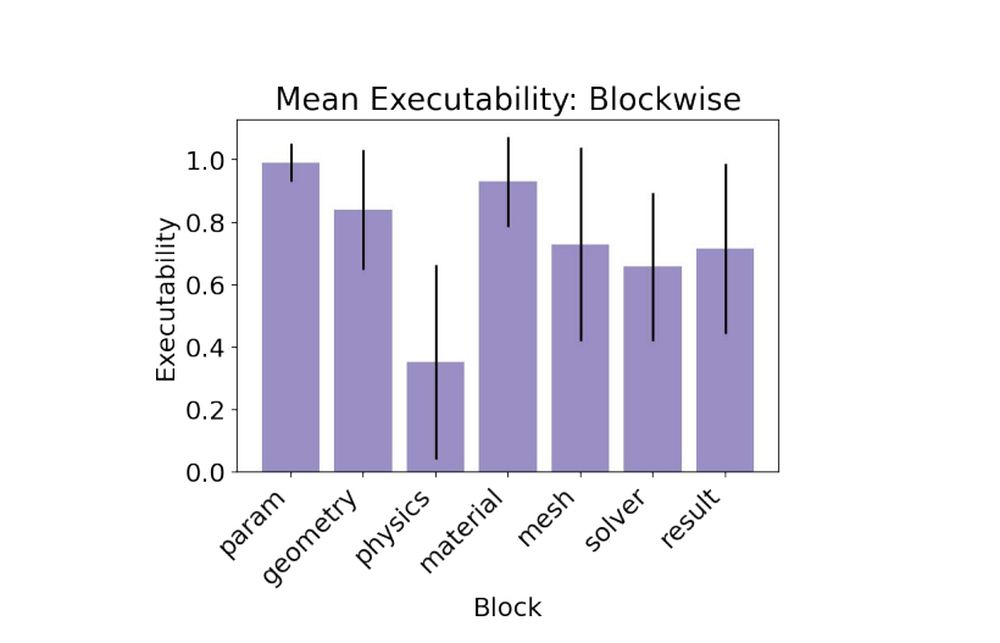

En las pruebas de referencia, los modelos de código cerrado como Claude 3.5, GPT-4O y Gemini 1.5 superaron a los modelos de peso abierto. Claude 3.5 lideró el paquete, logró una ejecución del 79% y obtuvo el único objetivo válido en un problema de oro. Los modelos abiertos lucharon, con algunas interfaces de física alucinantes o características incorrectas. La parte más desafiante? El bloque físicodonde los modelos necesitaban aplicar condiciones de contorno precisas y propiedades físicas para obtener resultados que coincidieran con la verdad del suelo.

- Soneto Claude 3.5: 0.79 ejecutabilidad, 1/15 objetivo válido

- GPT-4O: 0.78 ejecutabilidad, 0/15 objetivo válido

- Géminis-1.5-Pro: 0.60 Ejecutabilidad, 0/15 objetivo válido

Cuando un plan no es suficiente

El punto de referencia incluye dos tipos de tareas. En el Modelspecs Tarea, el LLM solo recibe las especificaciones técnicas y debe razonar una solución. En el Plan Tarea, el modelo recibe instrucciones paso a paso. Sorprendentemente, la tarea del plan no condujo a un mejor rendimiento. Los modelos a menudo fallaban tomando instrucciones demasiado literalmente y alucinando los nombres de API incorrectos. Agregar una lista de funciones de COMSOL válidas a la solicitud, llamado Phydoc en contexto Estrategia: Helped reduce las alucinaciones y mejoran la fáctica de la interfaz significativamente.

Lecciones para ingenieros de IA

Una gran comida para llevar: la traducción es más difícil que la planificación. Incluso cuando el modelo sabe qué hacer, expresarlo en el DSL de Comsol (lenguaje específico del dominio) es el obstáculo. La solución del equipo? Proporcione herramientas de conexión a tierra como bibliotecas de código anotadas y documentación en contexto, luego combínelo con flujos de trabajo de agente estructurados. Esa receta convirtió un bajo rendimiento de una sola vez en una mejora sólida de múltiples vueltas. De hecho, la estrategia de agente múltiple llegó 88% Ejecutabilidadel más alto de todos los experimentos.

- ModelsPecs + agente múltiple: 0.88 Ejecutabilidad, 2/15 objetivos válidos

- ModelsPecs + Phydoc: 0.62 Ejecutabilidad, 1/15 objetivos válidos

Las simulaciones son cómo los ingenieros compriman el tiempo y el riesgo. Feabench muestra que los LLM no están listos para ejecutar simulaciones sin supervisión, pero se están acercando a convertirse en copilotos útiles. Eso importa si queremos que la IA ayude en prototipos rápidos, descubrimiento científico o diseño estructural. Y si la IA puede aprender a modelar el mundo físico con tanta precisión como imita el lenguaje, no solo chateará, simulará, resolverá y tal vez algún día, incluso se inventará.