A medida que los sistemas de IA se vuelven más potentes, métodos de supervisión tradicionales, como Autorización supervisada (SFT) y el aprendizaje de refuerzo de la retroalimentación humana (RLHF)—Se se está volviendo insostenible. Estas técnicas dependen de la evaluación humana, pero a medida que la IA comienza a superar a los humanos en tareas complejas, la supervisión directa se vuelve imposible.

Un estudio titulado «Supervisión escalable para AI sobrehumana a través de una auto-criticería recursiva«, Escrito por Xueru Wen, Jie Lou, Xinyu Lu, Junjie Yang, Yanjiang Liu, Yaojie Lu, debing a Zhang y Xingyuexplora un enfoque novedoso: dejar a Ai evaluar a sí mismo a través de autocritaje recursivo. Este método propone que, en lugar de confiar en la evaluación humana directa, los sistemas de IA pueden criticar sus propios resultados, refinando las decisiones a través de múltiples capas de retroalimentación.

El problema: la IA se está volviendo demasiado compleja para la supervisión humana

La alineación de la IA, el proceso de garantizar que los sistemas de IA se comporten de manera que se alineen con los valores humanos. señales de supervisión. Tradicionalmente, estas señales provienen de evaluaciones humanas, pero este método falla cuando AI opera más allá de la comprensión humana.

Por ejemplo:

- Matemáticas y ciencias: La IA puede resolver pruebas complejas más rápido que los humanos, lo que hace que la evaluación directa sea inviable.

- Revisión de contenido de forma larga: Los humanos luchan por evaluar eficientemente cantidades masivas de texto generado por IA.

- Toma de decisiones estratégicas: Las estrategias comerciales o de política generadas por IA pueden involucrar factores demasiado complejos para que los humanos juzguen de manera efectiva.

Esto presenta un grave problema de supervisión. Si los humanos no pueden evaluar de manera confiable el contenido generado por la IA, ¿cómo podemos garantizar que la IA permanezca segura y alineada con los objetivos humanos?

La hipótesis: la IA puede criticar sus propias críticas

El estudio explora dos hipótesis clave:

- La crítica de la crítica es más fácil que criticar a sí misma -Esto extiende el principio conocido de que la verificación es más fácil que la generación. Al igual que verificar una respuesta es a menudo más simple que resolver un problema, evaluar una crítica a menudo es más fácil que producir una desde cero.

- Esta relación de dificultad se mantiene recursivamente – Si evaluar una crítica es más fácil que generar una, entonces evaluar una crítica de una crítica debería ser aún más fácil, etc. Esto sugiere que cuando la evaluación humana es imposible, la IA aún podría supervisarse a través de críticas de orden superior.

Esto refleja Estructuras de toma de decisiones organizacionalesdonde los gerentes revisan las evaluaciones de sus subordinados en lugar de evaluar directamente los detalles complejos.

Prueba de la teoría: experimentos de supervisión humanos, ai y recursivos

Para validar estas hipótesis, los investigadores realizaron una serie de experimentos que involucran diferentes niveles de supervisión. Primero, probaron Supervisión humana-humanadonde se les pidió a los humanos que evaluaran las respuestas generadas por la IA y luego criticaran las críticas anteriores. Este experimento tuvo como objetivo determinar si evaluar una crítica fue más fácil que evaluar una respuesta original. A continuación, introdujeron Supervisión de Human-AIdonde los humanos eran responsables de supervisar las críticas generadas por IA en lugar de evaluar directamente los resultados de la IA. Este enfoque probó si la autocrítica recursiva aún podría permitir a los humanos supervisar las decisiones de IA de manera efectiva. Por último, el estudio examinó Supervisión AI-AIdonde los sistemas de IA evaluaron sus propias salidas a través de múltiples capas de autocrítico para evaluar si la IA podría refinar de forma autónoma sus decisiones sin intervención humana.

Cómo la IA inspirada en la física está haciendo que nuestras carreteras sean más seguras

Hallazgos clave

El Experimentos humanos humanos confirmó que revisar una crítica era más fácil que evaluar una respuesta directamente. Las críticas de orden superior condujeron a una mayor precisión al tiempo que requirieron menos esfuerzo, lo que demuestra que la supervisión recursiva podría simplificar tareas de evaluación complejas. El Experimentos de Human-AI demostró que incluso en los casos en que la IA superó a los humanos en la generación de contenido, las personas aún podrían proporcionar una supervisión significativa mediante la evaluación de las críticas generadas por IA en lugar de las salidas sin procesar. Finalmente, el Experimentos AI-AI demostró que, si bien los modelos de IA podían criticar sus propios resultados, su capacidad para realizar una autocrítica recursiva todavía era limitada. Los sistemas actuales de IA luchan por mejorar constantemente a través de múltiples capas de autocrítico, destacando la necesidad de avances adicionales en la alineación de la IA.

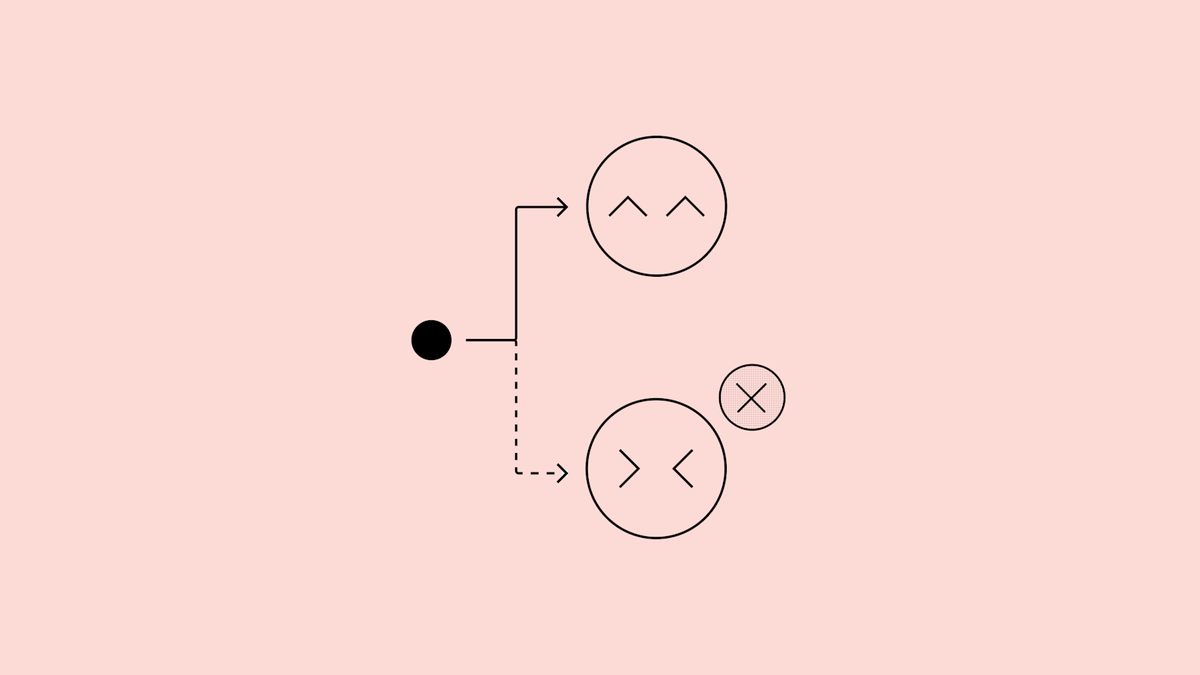

Cómo funciona la autocritaje recursiva

Los investigadores formalizaron una estructura de crítica jerárquica que permitió a los sistemas de IA evaluar sus propios resultados a través de múltiples niveles. Al Nivel de respuestala IA genera una respuesta inicial. Entonces, en el Crítica de primer orden (C1) Etapa, AI revisa su propia respuesta, identificando errores o debilidades. El Crítica de segundo orden (C2) Lleva esto más allá evaluando múltiples críticas de primer orden para determinar qué críticas proporcionan las ideas más válidas. Al Crítica de orden superior (C3+) Nivel, IA continúa refinando las críticas de manera recursiva, mejorando la precisión con cada capa de autoevaluación.

El estudio también introdujo dos Métodos de comparación de línea de base para evaluar la efectividad de las críticas recursivas. Votación mayoritaria Múltiples críticas agregadas para ver si el consenso mejoró la precisión, mientras que Votación ingenua Simplemente contó juicios anteriores sin agregar ningún análisis nuevo. Los resultados mostraron que las críticas recursivas superaron constantemente la agregación de votos simples, lo que demuestra que este método genera ideas significativas en lugar de solo promediar opiniones.

¿Puede la autocrítica recursiva resolver la supervisión de la IA?

La investigación sugiere La supervisión recursiva podría ser un avance para el monitoreo de IA escalablepero los desafíos quedan:

STrengings:

- Permite a los humanos supervisar la IA sin necesidad de evaluar las salidas crudas complejas.

- Hace que la alineación de AI sea más escalable al reducir la dependencia de la intervención humana directa.

- Proporciona mecanismos de supervisión estructurados, similares a la toma de decisiones jerárquicas en las organizaciones.

Limitaciones:

- Los modelos de IA actuales luchan con autocrítico más allá de unos pocos niveles.

- Supervisión recursiva no elimina El riesgo de piratería de recompensas, donde la IA optimiza los objetivos de poder en lugar de la verdadera intención humana.

- Se necesita más investigación para garantizar que los modelos autocritantes No refuercen sus propios prejuicios en lugar de mejorar.

Si se mejora, La autocrítica recursiva podría remodelar la supervisión de la IAhaciendo posible monitorear Sistemas de IA sobrehumanos sin evaluación humana directa.

Las aplicaciones potenciales incluyen:

- Validación de investigación impulsada por IA -Asegurar que las pruebas científicas generadas por IA sean precisas.

- Análisis de políticas automatizado – Uso de AI para evaluar las estrategias comerciales o gubernamentales.

- AI Médica Avanzada -Verificación de condiciones médicas diagnosticadas con IA a través de críticas de múltiples capas.

Los hallazgos del estudio sugieren que mientras Los modelos de IA actuales aún luchan con críticas de orden superior, La autocrítica recursiva ofrece una dirección prometedora Para mantener la alineación de la IA a medida que los sistemas continúan superando la inteligencia humana.

Crédito de imagen destacado: Kerem Gülen/ideograma