Stable Diffusion 3 Medium, la última oferta de Stability AI, hizo su debut recientemente, generando entusiasmo y controversia dentro de la comunidad SD3.

Como modelo de texto a imagen, Stable Diffusion 3 Medium tiene como objetivo transformar indicaciones textuales en imágenes visualmente atractivas, sin embargo, su recepción ha generado reacciones encontradas, particularmente en lo que respecta a su representación de figuras humanas.

Aunque Stability AI lo describe como su “modelo de generación de imágenes más sofisticado hasta la fecha” en un entrada en el bloglos resultados que hemos visto son… No lo endulcemos: Combustibles de pesadilla!

Linaje del medio Stable Diffusion 3

Stable Diffusion 3 Medium tiene sus raíces en un linaje de modelos de síntesis de imágenes de IA desarrollados por Stability AI. Esta iteración se basa en las bases establecidas por sus predecesores, incorporando avances tanto en tecnología como en metodologías de capacitación. El nombre del modelo, «Medio», significa su posición dentro de la serie más amplia Stable Diffusion 3, lo que sugiere un equilibrio entre eficiencia computacional y capacidades generativas.

En esencia, Stable Diffusion 3 Medium Emplea una sofisticada arquitectura de red neuronal. Interpretar y traducir indicaciones textuales en representaciones visuales. Los datos de entrenamiento del modelo, que comprenden una amplia colección de imágenes y sus correspondientes descripciones textuales, desempeñan un papel fundamental en la configuración de su capacidad para generar imágenes coherentes y contextualmente relevantes.

¿Dónde falla SD3?

Stable Diffusion 3 Medium muestra fortalezas notables en varias áreas. Es encomiable su capacidad para captar y responder a indicaciones complejas que involucran relaciones espaciales, elementos compositivos y diversos estilos. También es evidente la habilidad del modelo para generar imágenes con detalles intrincados y colores vibrantes.

Sin embargoha recibido críticas por sus dificultades ocasionales para representar con precisión la anatomía humana, en particular las manos y los rostros, tal como lo transmite cachondametalserPublicaciones de y muchas otras en las redes sociales. Estas deficiencias han planteado dudas sobre los datos de entrenamiento del modelo y el impacto potencial de los mecanismos de filtrado empleados durante su desarrollo.

¿Por qué SD3 es tan malo generando chicas tiradas en el césped?

poru/HornyMetalBeing enEstableDifusión

Los datos de entrenamiento utilizados para educar a Stable Diffusion 3 Medium abarcan una amplia gama de contenido visual, que incluye:

- Fotografías

- Obras de arte

- Ilustraciones

Sin embargo, los desarrolladores del modelo han implementado procesos de filtrado para excluir material explícito o sensible de este conjunto de datos. Si bien estos filtros pretenden garantizar el uso responsable del modelo, sin darse cuenta han llevado a la eliminación de imágenes que representan ciertas poses o detalles anatómicoscontribuyendo a las dificultades del modelo para representar con precisión figuras humanas.

Pongamos a prueba el medio Stable Diffusion 3

Puede poner a prueba el modelo fácilmente utilizando plataformas en línea que ofrecen interfaces accesibles para interactuar con él.

Ya conoces Internet, contiene tanta gente y tantas ideas. ¿Qué tan malo podría ser un modelo de generación de imágenes preparado según los estándares de 2024??

Probamos el Demostración gratuita en línea de SD3 en Hugging Face para obtener nuestra respuesta.

Aquí están nuestras indicaciones y resultados:

Parece que no hay ningún problema con la anatomía del perro aparte de que le falta un ojo, pero las manos y piernas de la mujer realmente parecen como si hubiera tenido un terrible accidente…

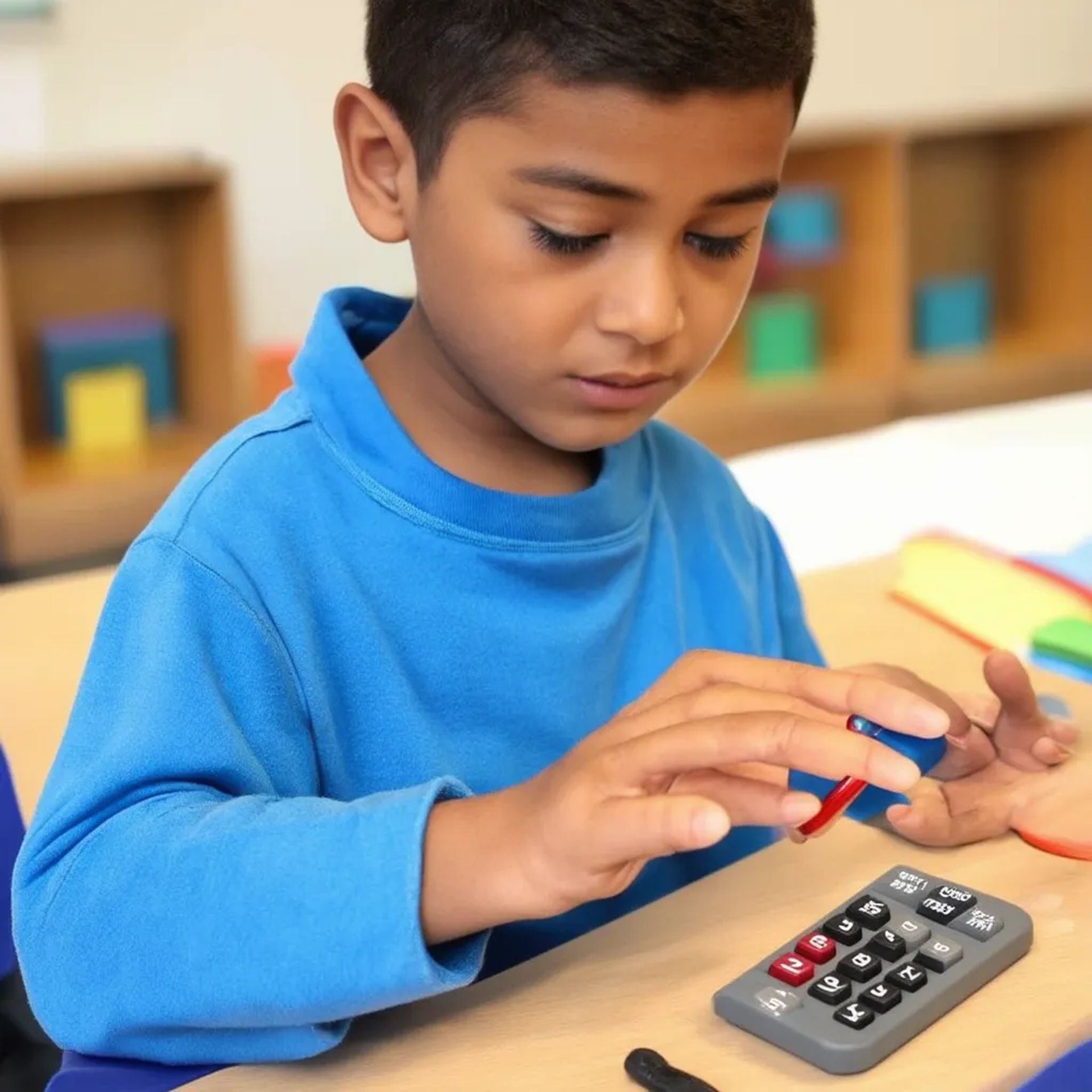

¡Parece que las matemáticas no sólo confundieron al joven sino que también le alargaron mucho los dedos y le derritieron una mano en la mesa!

¿Sabías que si tienes tres brazos y 12 dedos (tal vez más porque no podemos ver la mano del tercer brazo), puedes administrar dos terapias intravenosas al mismo tiempo? Al menos esta vez no hay ningún problema con el perro más que estar enfermo…

No importa, parece que ni siquiera Difusión estable ComfyUI 3 puede salvarlo…

Cómo probar SD3 en línea

Si bien Stable Diffusion 3 Medium ha recibido críticas y, según nuestra experiencia, estas no son quejas muy equivocadas. Si desea probar SD3 usted mismo, esto es lo que debe hacer:

- Ir a la demostración: Visita el Demostración de Stable Diffusion 3 Medium sobre abrazar espacios faciales

- Ingrese su mensaje: Escriba una descripción de la imagen que desee en el cuadro de texto proporcionado.

- Generar: Haga clic en el botón «Generar» y espere a que el modelo cree su imagen.

- Revisar y perfeccionar: Examina la imagen generada. Si no es lo que esperaba, ajuste el mensaje y vuelva a intentarlo.

Si bien Stable Diffusion 3 Medium ha recibido críticas, es crucial reconocer su potencial como un activo valioso. La capacidad del modelo para comprender indicaciones complejas y generar imágenes visualmente atractivas en diversos estilos sigue siendo digna de mención. A medida que la tecnología madura y experimenta un mayor desarrollo, está preparada para contribuir significativamente a nuestros métodos de expresión creativa en constante expansión.

Sin embargo, por ahora, recomendamos utilizar Midjourney, especialmente después de la introducción de Personalización del modelo Midjourney.

Crédito de imagen destacada: Estabilidad IA