Meta Segment Anything Model 2 (SAM 2) está causando sensación con sus impresionantes capacidades. A diferencia de los modelos tradicionales que tienen dificultades con nuevos tipos de objetos, SAM 2 utiliza el aprendizaje de cero disparos para identificar y segmentar elementos con los que no ha sido entrenado específicamente. Esto significa que puede manejar fácilmente una amplia variedad de contenido visual.

Imagine una herramienta que no solo segmenta objetos en un único fotograma, sino que también rastrea y mantiene la continuidad de los objetos a lo largo de toda una secuencia de vídeo, incluso en medio de oclusiones y cambios rápidos. SAM 2 logra esto a través de su arquitectura unificada y su mecanismo de memoria. A continuación, le mostramos cómo.

Explicación del modelo 2 de Meta Segment Anything (SAM 2)

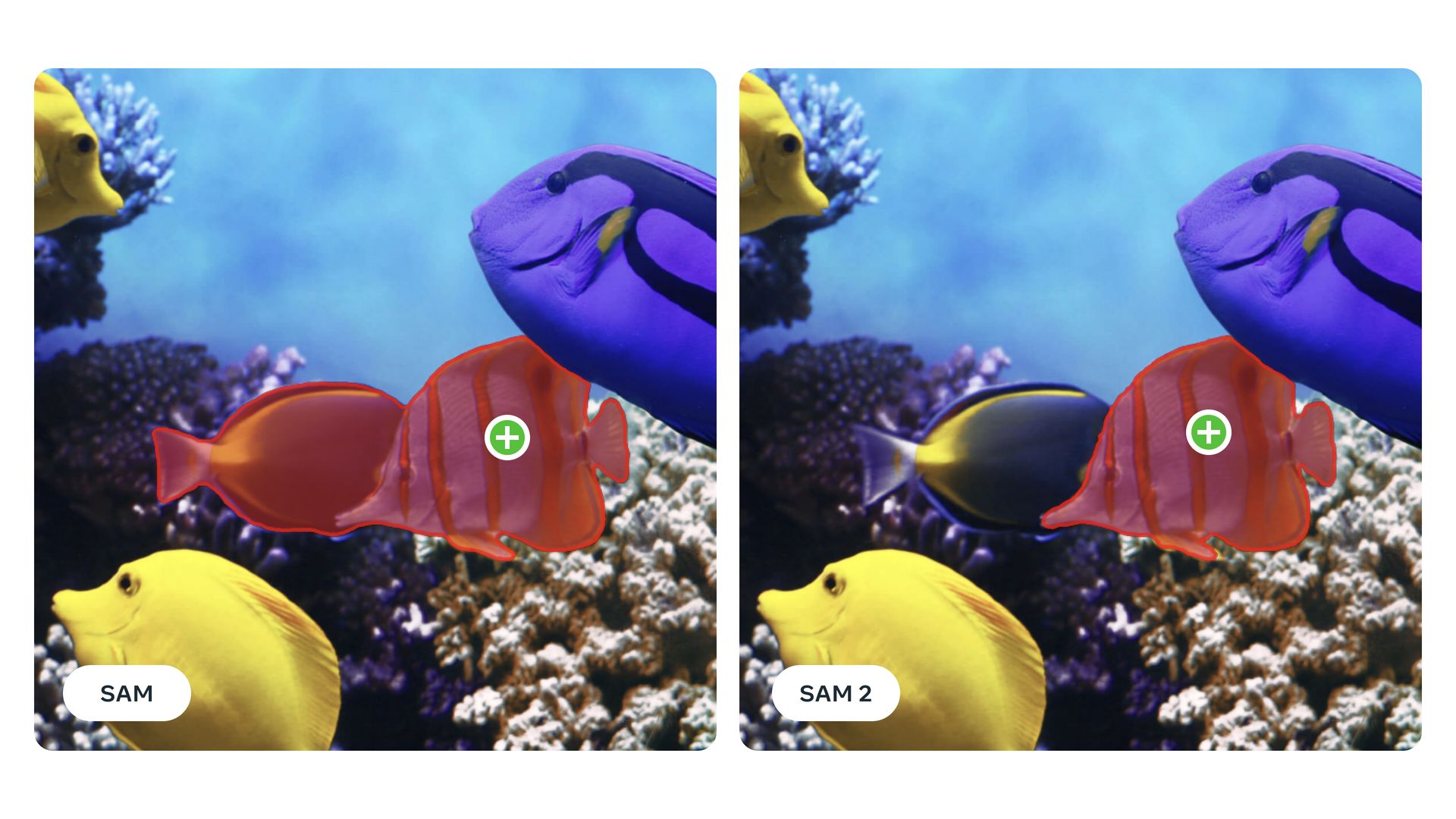

Meta Segment Anything Model 2 es un modelo avanzado de visión artificial diseñado para gestionar la segmentación de objetos en una variedad de tipos de medios, incluidas imágenes y vídeos. A diferencia de los modelos de segmentación tradicionales que pueden requerir un reentrenamiento extenso para nuevos tipos de objetos, SAM 2 está equipado con capacidades de aprendizaje de cero disparos. Gracias a sus sólidas capacidades de generalización, esto significa que puede segmentar objetos en los que no se ha entrenado explícitamente. Esto es particularmente útil para aplicaciones con contenido visual diverso o en evolución donde surgen nuevas categorías de objetos con frecuencia.

El núcleo de la funcionalidad de Meta SAM 2 es su arquitectura unificada, que procesa tanto imágenes como fotogramas de vídeo. Esta arquitectura incorpora un mecanismo de memoria que ayuda a mantener la continuidad entre los fotogramas de vídeo, lo que permite hacer frente a problemas como la oclusión y el movimiento de objetos.

El codificador de memoria del modelo captura información de fotogramas anteriores, que se almacena en un banco de memoria y a la que accede un módulo de atención de memoria. Esta configuración garantiza que el modelo pueda rastrear y segmentar objetos con precisión a lo largo del tiempo, incluso cuando están parcialmente ocultos o cuando la escena cambia de forma dinámica.

SAM 2 también es altamente interactivo, lo que permite a los usuarios proporcionar varios tipos de indicaciones (como clics, cuadros delimitadores o máscaras) para guiar el proceso de segmentación. Esta función de segmentación con indicaciones permite a los usuarios refinar los resultados de la segmentación en función de sus necesidades específicas y abordar cualquier ambigüedad en la detección de objetos. Al encontrarse con escenas complejas en las que son posibles múltiples interpretaciones, SAM 2 puede generar varias máscaras potenciales y seleccionar la más adecuada en función de los niveles de confianza.

El modelo se entrena y evalúa utilizando el Conjunto de datos SA-Vque se destaca por su escala y diversidad. Este conjunto de datos incluye alrededor de 51 000 secuencias de video del mundo real y más de 600 000 masklets, lo que proporciona un recurso integral para entrenar y probar modelos de segmentación. Las anotaciones en este conjunto de datos se generan de manera interactiva con SAM 2, lo que garantiza una alta precisión y relevancia para escenarios del mundo real. El conjunto de datos cubre una amplia gama de ubicaciones geográficas y varios tipos de contenido visual, incluidos escenarios con vistas parciales de objetos y oclusiones.

El modelo Segment Anything (SAM) 2 de Meta representa un avance importante en la segmentación de video interactivo, superando considerablemente a los modelos anteriores. Se destaca en 17 conjuntos de datos de video de toma cero, requiere tres veces menos interacciones humanas y ofrece resultados seis veces más rápido que su predecesor. SAMSAM 2 supera los estándares de referencia existentes, como DAVIS y YouTube-VOS, y procesa videos a aproximadamente 44 cuadros por segundo, lo que lo hace muy eficiente para aplicaciones en tiempo real. Su capacidad para realizar la segmentación de videos 8,4 veces más rápido que la anotación manual con SAM subraya aún más su efectividad y eficiencia en el manejo de tareas de video complejas.

Los avances de SAM 2 no solo son importantes para aplicaciones prácticas como el análisis y la anotación de videos, sino que también contribuyen al campo más amplio de la investigación en visión artificial. Al poner a disposición del público su código y conjunto de datos, Meta fomenta una mayor innovación y desarrollo en la tecnología de segmentación. Las mejoras futuras pueden centrarse en mejorar la capacidad del modelo para manejar oclusiones a largo plazo y escenas cada vez más complejas con múltiples objetos en movimiento, lo que continúa ampliando los límites de lo que es posible en la segmentación de objetos.

Cómo utilizar SAM 2

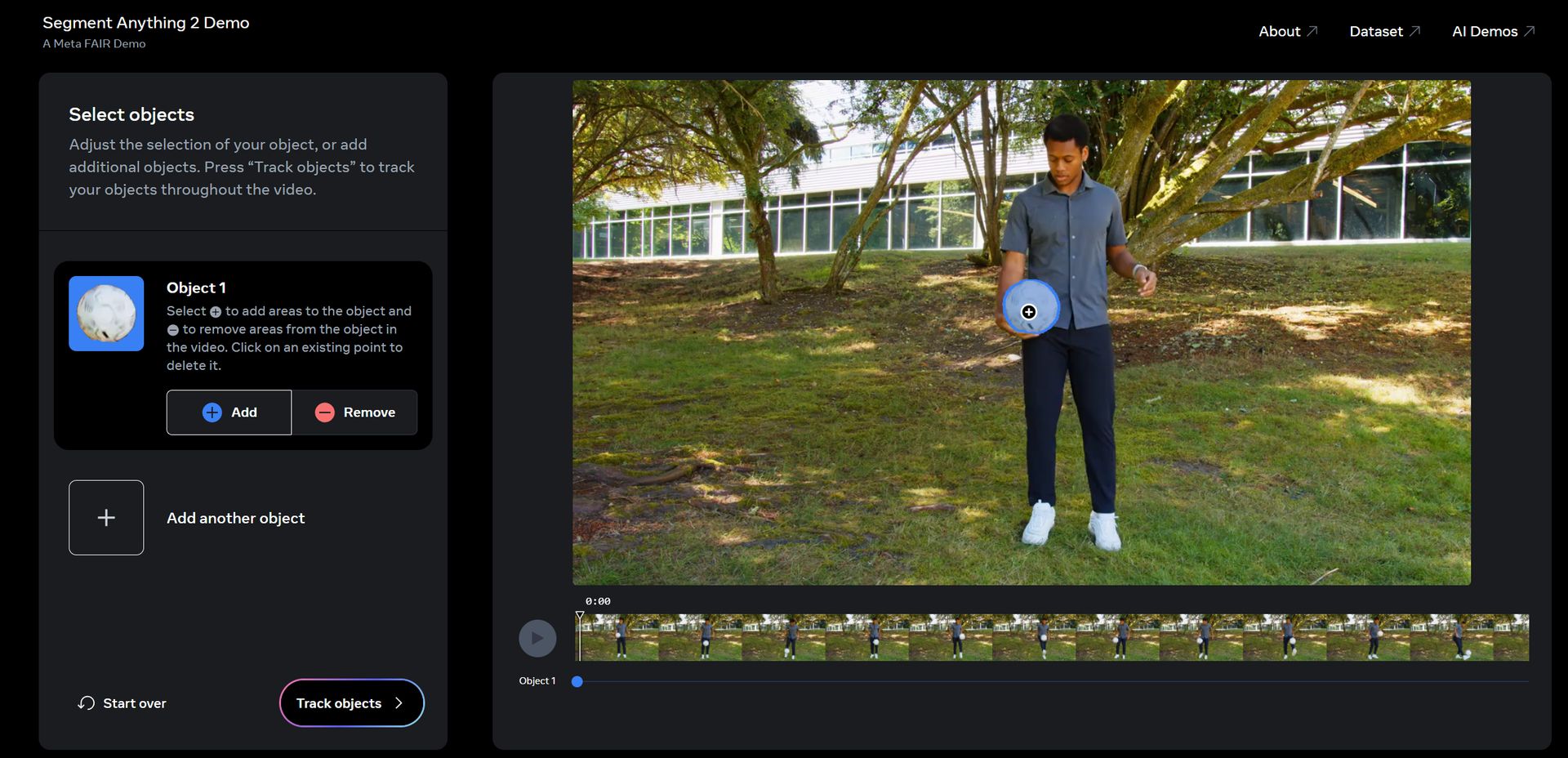

Meta Segment Anything Model 2 (SAM 2) tiene una demostración web, solo necesitas:

- haga clic aquí y visite la página de demostración.

- Acepta la advertencia

- Haga clic en el objeto o los objetos que desee seguir.

- Haz clic en “Rastrear objetos”

- Controle la salida. Si no hay problemas, haga clic en “Siguiente”

- Añade los efectos que quieras o deja que la IA haga lo suyo haciendo clic en «Sorpréndeme».

- Haga clic en Siguiente»

- Ahora puedes obtener un enlace o descargarlo. Aquí está nuestro resultado:

Prueba del modelo 2 de cualquier segmento meta (SAM 2) foto.twitter.com/d07PGto0eO

—Alan Davis (@AlanDav73775659) 30 de julio de 2024

¡Eso es todo!

Crédito de la imagen destacada: Meta