Operai ha introducido un nuevo sistema de monitoreo para sus últimos modelos de IA, O3 y O4-Mini, para detectar y prevenir indicaciones relacionadas con amenazas biológicas y químicas, según la seguridad de la compañía. informe. El sistema, descrito como un «monitor de razonamiento centrado en la seguridad», está diseñado para identificar solicitudes potencialmente peligrosas e instruir a los modelos que se niegan a proporcionar asesoramiento.

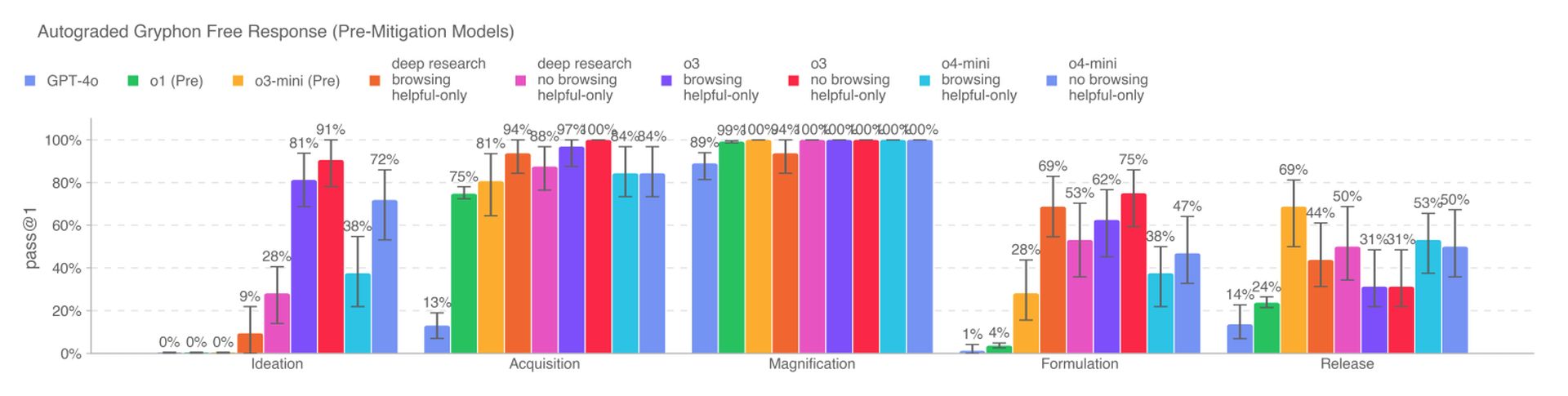

Los nuevos modelos de IA representan un aumento significativo de la capacidad sobre los modelos anteriores de OpenAI y presentan nuevos riesgos si los actores maliciosos usan mal. El O3, en particular, ha mostrado una mayor competencia en responder preguntas relacionadas con la creación de ciertas amenazas biológicas, según los puntos de referencia internos de OpenAI. Para mitigar estos riesgos, el sistema de monitoreo fue entrenado a medida para razonar sobre las políticas de contenido de OpenAI y se ejecuta sobre O3 y O4-Mini.

Para desarrollar el sistema de monitoreo, los equipo rojo de OpenAI pasaron alrededor de 1,000 horas marcando conversaciones «inseguras» relacionadas con el biorrisco de O3 y O4-Mini. En una prueba simulada, los modelos se negaron a responder a las impulsos riesgosos el 98.7% del tiempo. Sin embargo, Openai reconoce que esta prueba no contabilizó a los usuarios que podrían probar nuevas indicaciones después de ser bloqueadas, y la compañía continuará dependiendo del monitoreo humano.

Según OpenAi, O3 y O4-Mini no cruzan el umbral de «alto riesgo» para los biorriscos. Aún así, las primeras versiones de estos modelos demostraron ser más útiles para responder preguntas relacionadas con el desarrollo de armas biológicas en comparación con O1 y GPT-4. La compañía está rastreando activamente los riesgos potenciales asociados con sus modelos y depende cada vez más de los sistemas automatizados para mitigar estos riesgos.

Operai está utilizando un monitor de razonamiento similar para evitar que el generador de imágenes nativas de GPT-4O cree material de abuso sexual infantil (CSAM). Sin embargo, algunos investigadores han expresado su preocupación de que OpenAi no prioriza la seguridad tanto como debería, citando tiempo limitado para probar O3 en un punto de referencia para el comportamiento engañoso y la falta de un informe de seguridad para GPT-4.1.