Los investigadores de semillas de Bytedance implementaron la optimización de políticas proximales aumentadas de valor (VAPO), un marco de capacitación de aprendizaje de refuerzo diseñado para agudizar el razonamiento de los modelos de idiomas grandes en tareas complejas y largas, logrando nuevos resultados de última generación en el punto de referencia AIME24.

La capacitación de LLM para un razonamiento intrincado utilizando el aprendizaje de refuerzo basado en el valor se enfrentó previamente a obstáculos significativos. Los métodos lucharon con el sesgo del modelo de valor, adaptándose de manera efectiva a secuencias de respuesta de longitudes ampliamente variables y gestionar señales de recompensa dispersas, especialmente en tareas basadas en verificadores que proporcionan solo retroalimentación binaria.

VAPO aborda estos desafíos a través de tres innovaciones centrales: un marco de capacitación basado en el valor detallado, un mecanismo de estimación de ventaja generalizada de longitud adaptativa (GAE) que ajusta los parámetros de ajuste de la longitud de la respuesta y la integración sistemática de técnicas de investigaciones anteriores.

Esta combinación crea un sistema donde las mejoras funcionan sinérgicamente. Utilizando el modelo QWEN2.5-32B sin datos SFT específicos, VAPO mejoró las puntuaciones de referencia de 5 a 60, superando los métodos de estado de arte anteriores por 10 puntos.

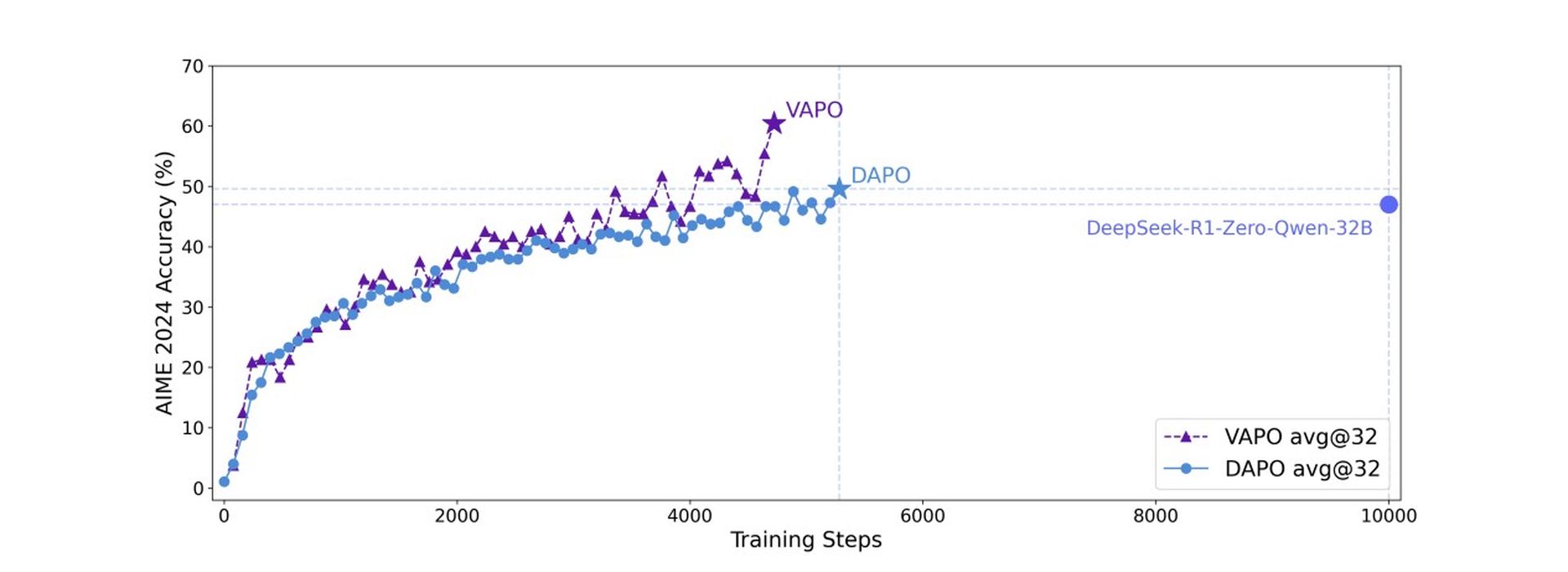

VAPO se basa en el algoritmo de optimización de políticas proximales (PPO), pero incorpora modificaciones clave para mejorar el razonamiento matemático. El análisis de entrenamiento reveló que VAPO exhibe curvas de entrenamiento más suaves en comparación con el método DAPO sin valor, lo que indica una optimización más estable.

VAPO también demostró una mejor escala de longitud para una mejor generalización, un crecimiento de puntaje más rápido atribuible a las señales granulares de su modelo de valor y una entropía más baja en etapas de entrenamiento posteriores. Si bien la entropía reducida puede limitar potencialmente la exploración, el método equilibra efectivamente esto, mejorando la reproducibilidad y la estabilidad con un impacto de rendimiento mínimo.

En el punto de referencia AIME24, Deepseek R1 usando GRPO logró 47 puntos, y DAPO alcanzó 50 puntos. VAPO, utilizando el modelo QWEN-32B, coincidió con el rendimiento de DAPO con solo el 60% de los pasos de actualización y estableció un nuevo puntaje de última generación de 60.4 en 5,000 pasos. En contraste, Vanilla PPO obtuvo solo 5 puntos debido al colapso de aprendizaje del modelo de valor.

Este punto de referencia pregunta si AI puede pensar como un ingeniero

Los estudios de ablación confirmaron la efectividad de siete modificaciones distintas dentro de VAPO. La pretención de valor previene el colapso del modelo; GAE desacoplado permite la optimización completa de respuestas largas; GAE adaptativo equilibra la optimización de respuesta corta y larga; Clip-Highter fomenta una exploración completa; La pérdida de nivel de token aumenta la ponderación para respuestas largas; incorporando la pérdida de LM de ejemplo positivo agregó 6 puntos; y el muestreo grupal contribuyó con 5 puntos al puntaje final.

Investigadores destacar Ese VAPO, que utiliza el modelo QWEN2.5-32B, demuestra que este enfoque basado en el valor puede superar decisivamente a los métodos sin valor como GRPO y DAPO, estableciendo un nuevo nivel de rendimiento para tareas de razonamiento complejos y abordar desafíos fundamentales en modelos de valor de entrenamiento para escenarios largos de la cadena de cables.