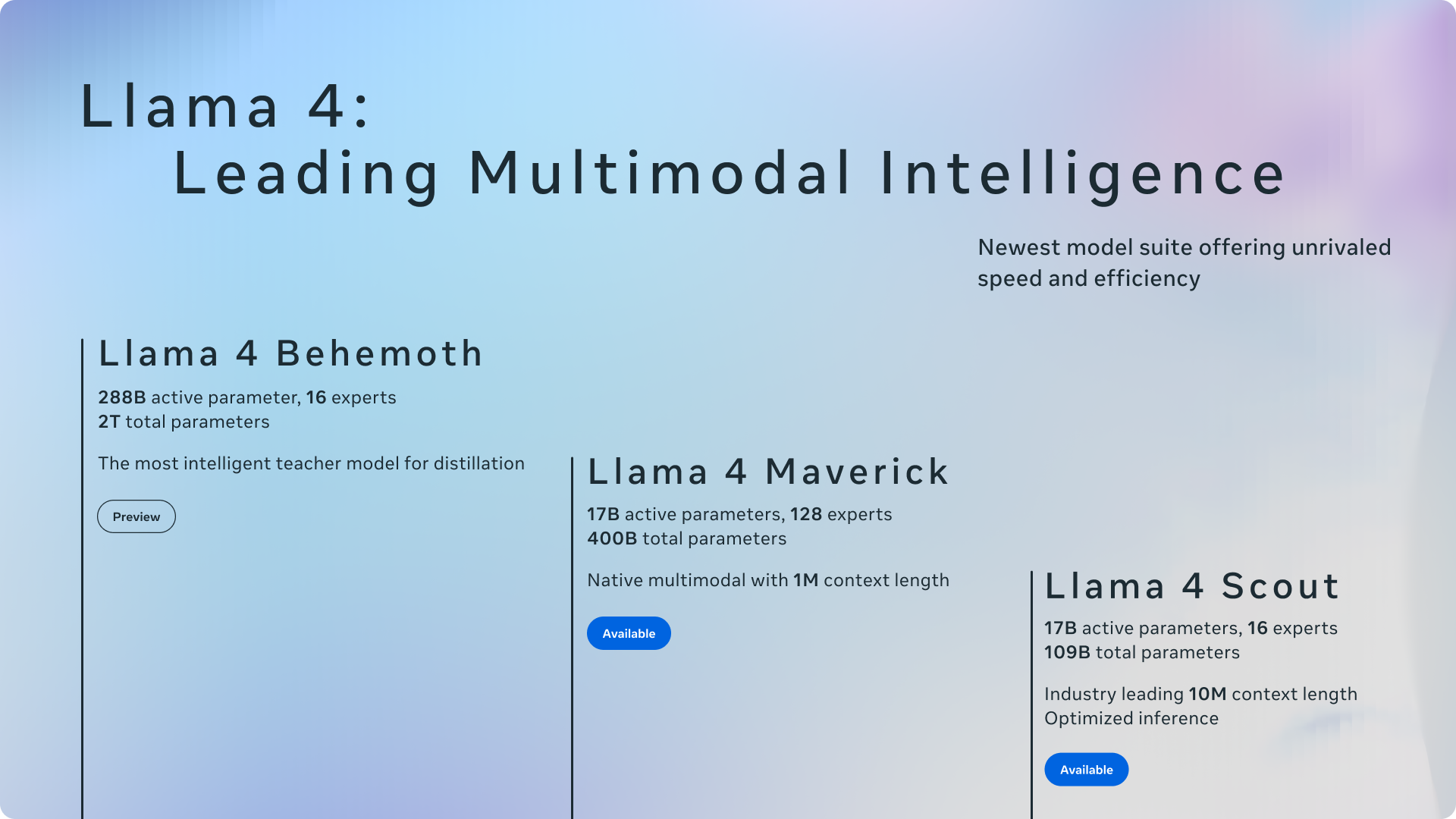

Meta tiene anunciado oficialmente Su conjunto más avanzado de modelos de inteligencia artificial hasta la fecha: la familia Llama 4. Esta nueva generación incluye Llama 4 Scout y Llama 4 Maverick, el primero de los modelos de peso abierto de Meta que ofrece multimodalidad nativa y soporte de longitud de contexto sin precedentes. Estos modelos también marcan la incursión inicial de Meta en el uso de una arquitectura de mezcla de expertos (MOE). Meta también proporcionó una vista previa de Llama 4 Behemoth, una LLM altamente inteligente actualmente en capacitación, diseñada para servir como maestro para futuros modelos.

Esta importante actualización del ecosistema de LLAMA llega aproximadamente un año después del lanzamiento de Llama 3 en 2024subrayando el compromiso de Meta de abrir innovación en el espacio de IA. Según Meta, hacer que los modelos líderes estén abiertamente a disposición es crucial para fomentar el desarrollo de experiencias personalizadas.

Scout and Maverick: modelos multimodales con arquitectura innovadora

Llama 4 Scout y Llama 4 Maverick son los modelos eficientes iniciales de esta serie. Llama 4 Scout cuenta con 17 mil millones de parámetros activos en 16 expertos, mientras que Llama 4 Maverick también cuenta con 17 mil millones de parámetros activos, pero aprovecha un grupo más grande de 128 expertos dentro de su arquitectura MOE. Meta resalta la eficiencia de este diseño, señalando que Llama 4 Scout puede caber en una sola GPU H100 (con cuantización INT4) y Llama 4 Maverick en un solo host H100, facilitando una implementación más fácil.

La adopción de una arquitectura de mezcla de expertos (MOE) es un avance clave. En los modelos MOE, solo se activan una fracción de los parámetros totales para cada token, lo que lleva a una mayor capacitación e inferencia de eficiencia de cómputo, lo que finalmente ofrece una mayor calidad para un presupuesto de cómputo dado. Por ejemplo, Llama 4 Maverick tiene 400 mil millones de parámetros totales, pero solo 17 mil millones están activos durante el uso.

Tanto Llama 4 Scout como Llama 4 Maverick son de forma nativa multimodal, incorporando fusión temprana para procesar sin problemas tokens de texto y visión dentro de una red troncal de modelo unificado. Esto permite el pre-entrenamiento conjunto en grandes cantidades de datos de texto, imagen y video no etiquetados. Meta también ha mejorado el codificador Vision en Llama 4, basándose en Metaclip pero entrenándolo por separado junto a un modelo de LLAMA congelado para una mejor adaptación.

Llama 4 Behemoth: un modelo de maestro con puntos de referencia prometedores

Meta proporcionó un vistazo a Llama 4 Behemoth, un modelo centrado en el maestro con un asombroso parámetros activos de 288 mil millones y casi dos billones de parámetros totales en 16 expertos. Meta afirma que Behemoth supera a los modelos principales como GPT-4.5, Claude Sonnet 3.7 y Géminis 2.0 Pro en puntos de referencia centrados en el vástago como Math-500 y GPQA Diamond. Si bien Llama 4 Behemoth todavía está en entrenamiento y aún no está disponible, jugó un papel crucial en «Codistilling» el modelo de Llama 4 Maverick, lo que lleva a mejoras de calidad significativas.

Longitud de contexto y capacidades multilingües

Una característica destacada de los modelos LLAMA 4 es su longitud de contexto significativamente mayor. Llama 4 Scout lidera a la industria con una ventana de contexto de entrada de 10 millones de tokens, un aumento dramático de los 128k de Llama 3. Este contexto extendido permite capacidades avanzadas como resumen y razonamiento multi-documentos sobre grandes bases de código. Ambos modelos fueron capacitados previamente en un conjunto de datos masivo superior a 30 billones de tokens, más del doble que el de Llama 3, y que abarca más de 200 idiomas, con más de 100 idiomas con más de mil millones de tokens cada una.

Integración en meta aplicaciones y disponibilidad de desarrolladores

Reflejando el compromiso de Meta con Open Innovation, Llama 4 Scout y Llama 4 Maverick están disponibles para descargar hoy en Llama.com y abrazar la cara. Meta también anunció que estos modelos ahora están impulsando meta ai dentro de aplicaciones populares como WhatsApp, Messenger, Instagram Direct y en el sitio web de Meta.ai. Esta integración permite a los usuarios experimentar directamente las capacidades de los nuevos modelos LLAMA 4.

Meta enfatizó su compromiso de desarrollar modelos de IA útiles y seguros. Llama 4 incorpora las mejores prácticas descritas en su Guía de uso del desarrollador de protecciones de IA, incluidas las mitigaciones en varias etapas de desarrollo. También destacaron salvaguardas de código abierto como Llama Guard y Promte Guard para ayudar a los desarrolladores a identificar y prevenir entradas y salidas dañinas.

Al abordar el problema bien conocido de BIAS en LLMS, Meta declaró que se han realizado mejoras significativas en LLAMA 4. El modelo rechaza menos indicaciones sobre temas políticos y sociales debatidos y demuestra una respuesta más equilibrada en diferentes puntos de vista, mostrando un rendimiento comparable a Grok en esta área.