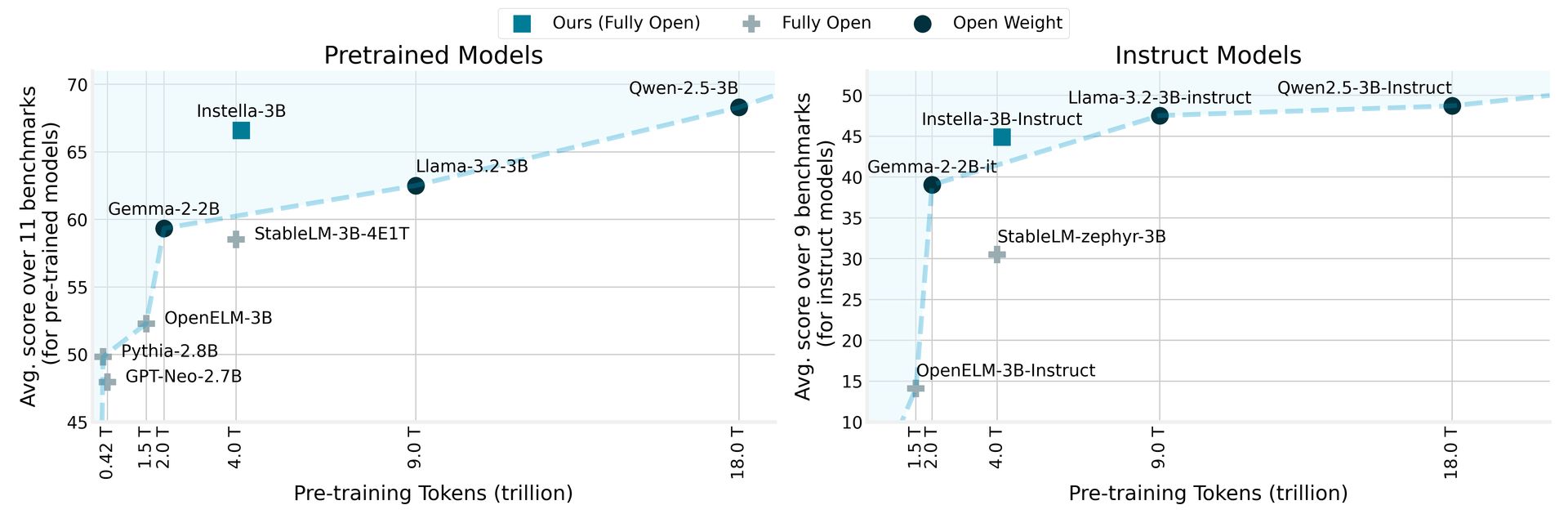

AMD tiene presentado Instella, una familia de modelos de lenguaje de código abierto con 3 mil millones de parámetros, entrenado desde cero en GPU AMD Instinct ™ MI300X. Los modelos de Instella superan a los modelos abiertos existentes de tamaños similares y compiten de manera efectiva con los principales modelos de peso abierto, incluidos LLAMA-3.2-3B, GEMMA-2-2B y QWEN-2.5-3B, incluidas sus versiones ajustadas a las instrucciones.

AMD presenta Instella: modelos de lenguaje de código abierto superan a los rivales de rendimiento

Instella emplea una arquitectura de transformador autorregresivo que consta de 36 capas de decodificadores y 32 cabezas de atención, lo que le permite procesar largas secuencias de hasta 4,096 tokens. El modelo utiliza un vocabulario de aproximadamente 50,000 tokens, administrado por el tokenizador OLMO, lo que lo hace experto en generar e interpretar el texto en varios dominios.

El procedimiento de capacitación para Instella destaca la colaboración entre las innovaciones de hardware y software de AMD. Este nuevo modelo se basa en las bases establecidas por los modelos anteriores de 1 billón de parámetros de AMD, pasando de la capacitación en GPU MI250 de 64 AMD MI250 con 1.3 billones de tokens para usar GPU MI300X de 128 instinto con tokens de 4.15 billones de 4.15 billones para el modelo actual de 3 billones de parámetros.

Al comparar Instella con modelos anteriores, AMD informa que no solo supera los modelos completamente abiertos existentes, sino que también logra un rendimiento competitivo con los modelos de peso abierto de última generación, que marca un hito significativo en el campo de procesamiento del lenguaje natural. Esta iniciativa se alinea con el compromiso de AMD para hacer que la tecnología avanzada sea más accesible y fomentando la colaboración e innovación dentro de la comunidad de IA.

El precio de AMD RX 9000 podría hacer que repita esa compra RTX 5090

Fases de modelo de Instella y datos de entrenamiento

Este lanzamiento incluye varias versiones de los modelos Instella, cada una de las cuales representan diferentes etapas de entrenamiento:

| Modelo | Escenario | Datos de capacitación (tokens) | Descripción |

|---|---|---|---|

| Instella-3b-etapa1 | Prerreining (etapa 1) | 4.065 billones | Pres previa de la primera etapa para desarrollar el dominio del lenguaje natural. |

| Instella-3b | Prerreining (etapa 2) | 57.575 mil millones | Pres prevista en la segunda etapa para mejorar las capacidades de resolución de problemas. |

| Instella-3b-sft | Sft | 8.902 mil millones (épocas x3) | Ajuste fino supervisado (SFT) para habilitar las capacidades de seguimiento de instrucciones. |

| Instella-3b-instructo | Dpo | 760 millones | Alineación con las preferencias humanas y la mejora de las capacidades de chat con optimización de preferencia directa (DPO). |

En la tubería de capacitación en varias etapas, la primera etapa previa al entrenamiento utilizó 4.065 billones de tokens de diversos conjuntos de datos, estableciendo la comprensión del lenguaje fundamental. La capacitación posterior en 57.575 mil millones de tokens adicionales mejoró aún más el rendimiento del modelo en tareas y dominios variados.

Durante el ajuste fino supervisado, Instella-3B-SFT fue entrenado con 8.9 mil millones de tokens, mejorando las capacidades de respuesta interactiva. La etapa final, Instella-3B-Instructo, se sometió a un entrenamiento de alineación con optimización directa de preferencias utilizando tokens de 0.76 mil millones, asegurando que las salidas del modelo estén alineadas con los valores y preferencias humanas.

AMD ha realizado todos los artefactos asociados con los modelos Instella de código abierto, incluidos pesos de modelos, configuraciones de capacitación, conjuntos de datos y código, fomentando la colaboración e innovación en la comunidad de IA. Se puede acceder a estos recursos a través de Cara abrazada tarjetas modelo y Github Repositorios.

Crédito de imagen destacado: Amd