Microsoft Corp. tiene expandido Su línea PHI de modelos de lenguaje de código abierto con la introducción de dos nuevos algoritmos diseñados para procesamiento multimodal y eficiencia de hardware: PHI-4-MINI y PHI-4-Multimodal.

Características PHI-4-MINI y PHI-4-Multimodales

Phi-4-Mini es un modelo solo de texto que incorpora 3.8 mil millones de parámetros, lo que le permite ejecutar eficientemente en dispositivos móviles. Se basa en una arquitectura de transformador de decodificador, que analiza solo el texto que precede a una palabra para determinar su significado, mejorando así la velocidad de procesamiento y reduciendo los requisitos de hardware. Además, Phi-4-Mini utiliza una técnica de optimización de rendimiento conocida como atención de consulta agrupada (GQA) para disminuir el uso de hardware asociado con su mecanismo de atención.

Microsoft Phi-4 AI aborda matemáticas complejas con parámetros de 14b

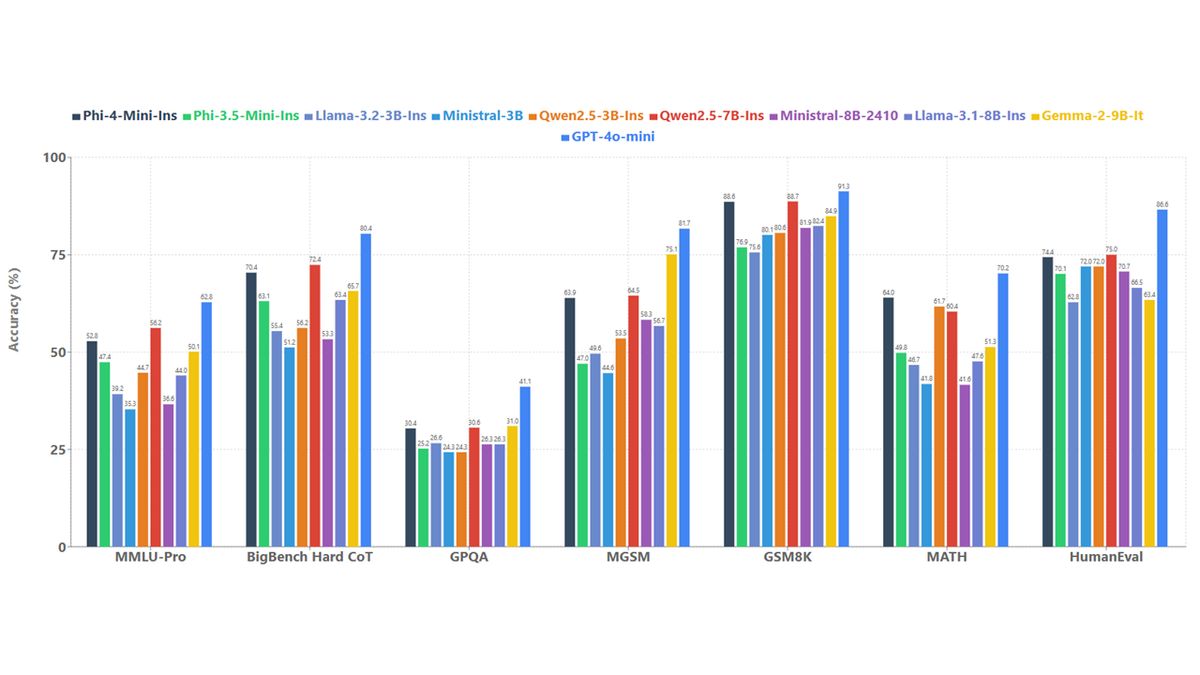

Este modelo es capaz de generar texto, traducir documentos y ejecutar acciones dentro de aplicaciones externas. Microsoft afirma que PHI-4-Mini se destaca en tareas que requieren razonamiento complejo, como cálculos matemáticos y desafíos de codificación, logrando una precisión significativamente mejorada en las pruebas de referencia internas en comparación con otros modelos de idiomas de tamaño similar.

El segundo modelo, Phi-4-Multimodal, es una versión mejorada de Phi-4-Mini, con 5.6 mil millones de parámetros. Es capaz de procesar texto, imágenes, audio y entradas de video. Este modelo fue entrenado utilizando una nueva técnica llamada mezcla de loras, que optimiza las capacidades del modelo para el procesamiento multimodal sin modificaciones extensas a sus pesos existentes.

Microsoft realizó pruebas de referencia en PHI-4-Multimodal, donde obtuvo una puntuación promedio de 72 en el procesamiento de datos visuales, apenas tímido en el GPT-4 de OpenAI, que obtuvo 73. Gemini Flash 2.0 de Google LED con un puntaje de 74.3. En tareas combinadas visuales y de audio, PHI-4-Multimodal superó a Gemini-2.0 Flash «por un gran margen» y superó a Internomni, que está especializado para el procesamiento multimodal.

Tanto Phi-4-Multimodal como Phi-4-Mini tienen licencia bajo la licencia MIT y estarán disponibles a través de Cara abrazadapermitiendo uso comercial. Los desarrolladores pueden acceder a estos modelos a través de Azure ai fundición y Catálogo de API de Nvidia para explorar más su potencial.

Phi-4-Multimodal está particularmente diseñado para facilitar las interacciones naturales y conscientes del contexto al integrar múltiples tipos de entrada en un solo modelo de procesamiento. Incluye mejoras como un vocabulario más grande, capacidades multilingües y una eficiencia computacional mejorada para la ejecución en el dispositivo.

Phi-4-Mini ofrece un rendimiento impresionante en las tareas basadas en texto, incluidas las capacidades de razonamiento y llamadas de funciones, lo que le permite interactuar con las interfaces de programación estructuradas de manera efectiva. La plataforma admite secuencias de hasta 128,000 tokens.

Además, ambos modelos han sufrido extensas pruebas de seguridad, dirigidas por el equipo rojo interno de AI AI (AIRT) de Microsoft, que evaluó los modelos utilizando metodologías de evaluación integrales que abordan las tendencias actuales en la ciberseguridad, la justicia y la seguridad del usuario.

La personalización y la facilidad de implementación son ventajas adicionales de estos modelos, ya que sus tamaños más pequeños les permiten ser ajustados para tareas específicas con demandas computacionales relativamente bajas. Ejemplos de tareas adecuadas para ajustar incluyen la traducción del habla y la respuesta a las preguntas médicas.

Para obtener más detalles sobre los modelos y sus aplicaciones, se alienta a los desarrolladores a consultar el Libro de cocina PHI Disponible en Github.

Crédito de la imagen destacada: Microsoft