Los modelos de idiomas grandes (LLM) se están volviendo más inteligentes, pero también están golpeando una pared: el manejo de piezas largas de texto es lento y computacionalmente costoso. Los mecanismos de atención tradicionales, el núcleo de cómo la IA procesa y recuerda la información, se esfuerza por escalar de manera eficiente, lo que hace que los modelos sean costosos para entrenar y correr.

Ahora, investigadores de Deepseek-AI y University de Pekín tener introducido Un enfoque que cambia el juego Atención nativamente escasa (NSA). Este nuevo método promete hacer modelos de IA significativamente más rápido, más barato y más eficientetodo mientras mantiene el mismo nivel de capacidad de razonamiento que los enfoques tradicionales.

Por qué el problema de atención de la IA necesita una solución

Imagina leer un libro donde tienes que tener en cuenta cada oración en todo momento, así es como Atención completa Los mecanismos funcionan en IA. Escanean y almacenan información en secuencias largas, pero a medida que crece la longitud de contexto (piense en miles de palabras), este enfoque se vuelve increíblemente lento y computacionalmente pesado.

Para abordar esto, los investigadores han explorado Atención escasa—Conamente procesa selectivamente la información más importante en lugar de todo. Sin embargo, los métodos escasos existentes tienen debilidades importantes:

- Son difíciles de entrenar desde ceroa menudo requiere que los modelos aprendan primero con plena atención antes de cambiar a un enfoque escaso.

- No optimizan completamente para el hardware modernolo que significa que las mejoras teóricas de velocidad no siempre se traducen en eficiencia del mundo real.

Cómo la NSA cambia el juego

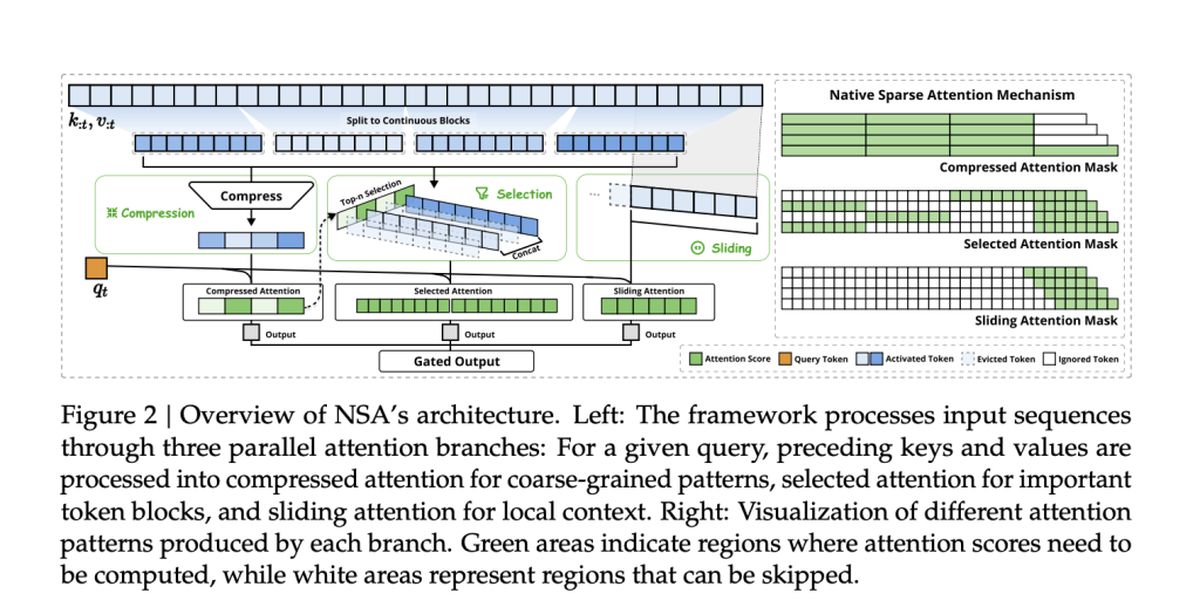

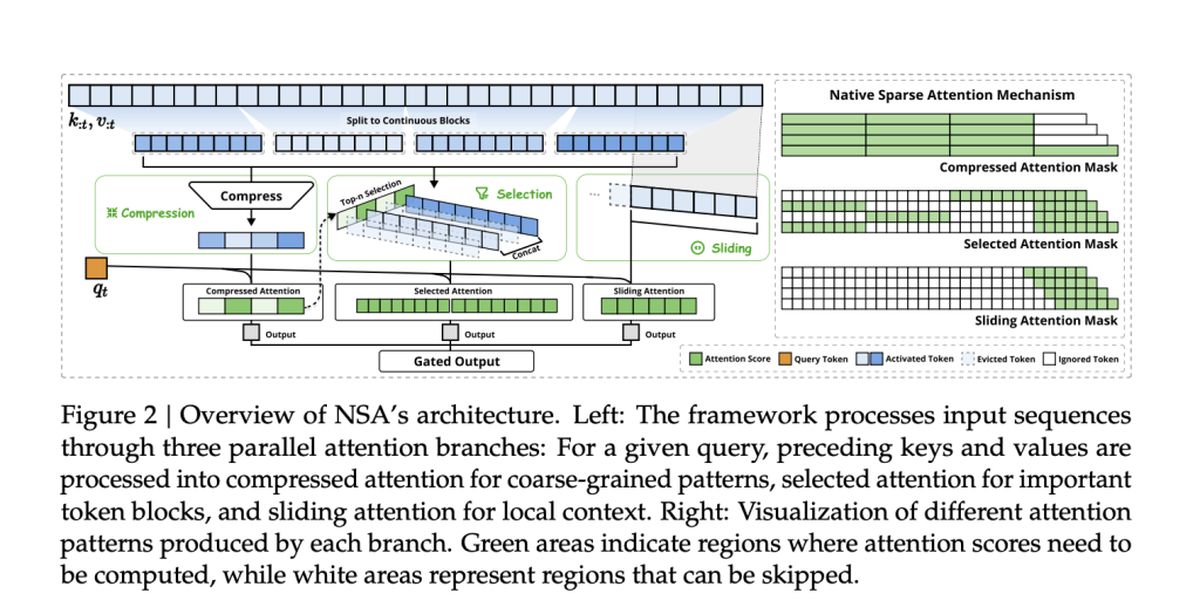

El equipo detrás de la NSA, incluidos Jingyang Yuan, Huazuo Gao, Damai Dai y sus colegas, adoptó un nuevo enfoque. Su método integra de forma nativa desde el principioen lugar de aplicarlo como una ocurrencia tardía.

NSA logra esto con Dos innovaciones clave:

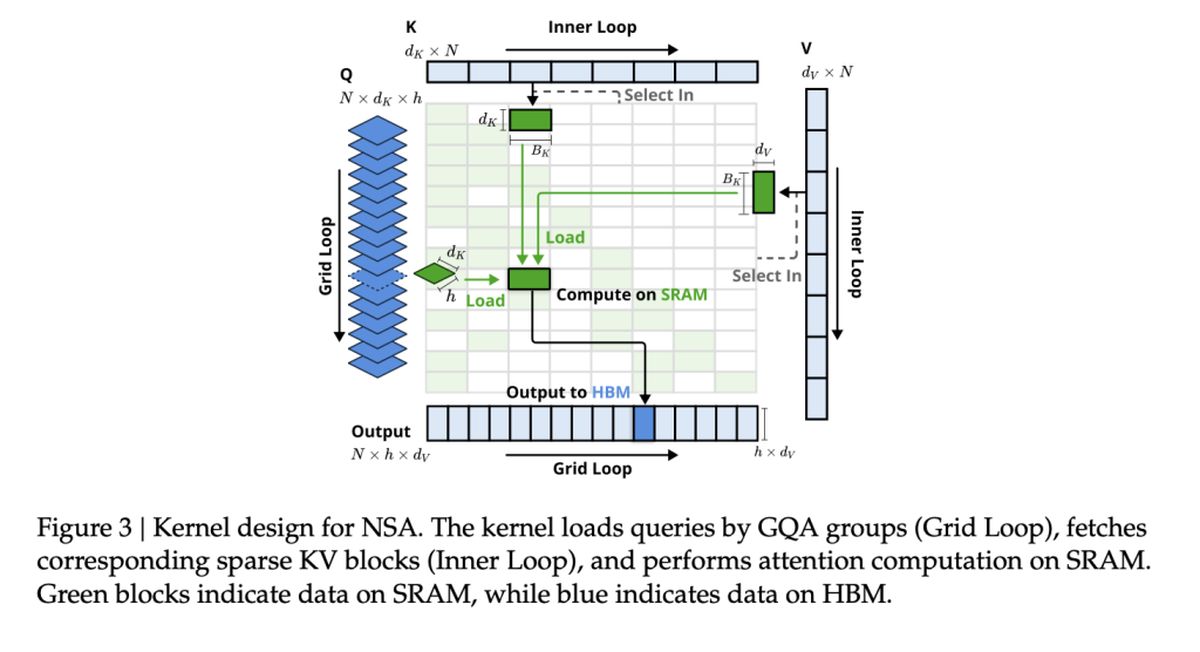

- Eficiencia alineada por hardware: La NSA está construida para maximizar el rendimiento de la GPU, evitando los cuellos de botella de la memoria y garantizar las aceleraciones del mundo real.

- Trainabilidad de extremo a extremo: A diferencia de los métodos dispersos anteriores, la NSA es totalmente entrenable desde cero, reduciendo los costos de entrenamiento sin perder precisión.

Velocidad y precisión: la ventaja de la NSA

Entonces, ¿cómo se compara la NSA con los modelos tradicionales de atención plena? Según el estudio, NSA logra hasta 11 × mejoras de velocidad Mientras aún coincide, o incluso un rendimiento superior, la atención llena en los puntos de referencia clave.

Algunas de las mayores victorias incluyen:

- Procesamiento más rápido: NSA acelera la capacidad de AI para manejar documentos largos, bases de código y conversaciones de múltiples vueltas.

- Mejor razonamiento: A pesar de ser «escaso», los modelos de la NSA coincidir o superar Modelos de atención completa en tareas de razonamiento de la cadena de pensamiento.

- Costos más bajos: Al reducir el cálculo sin sacrificar el rendimiento, la NSA podría hacer que la IA avanzada sea más asequible para entrenar y desplegar.

Métodos de atención escasa existentes

Muchos mecanismos de atención escasa existentes intentan reducir la sobrecarga computacional mediante Tokens de poda selectivamente o Optimización del acceso a la memoria. Sin embargo, a menudo se quedan cortos en la implementación práctica, ya sea porque introducen componentes no entrenables o no se alinean con las arquitecturas modernas de GPU.

Por ejemplo:

- Clusterkv y MagicPig Confíe en técnicas discretas de agrupación o hashing, que interrumpen el flujo de gradiente y obstaculizan el entrenamiento modelo.

- H2O y minferencia Aplicar la escasez solo durante etapas específicas de inferencia, lo que limita las mejoras de velocidad en la tubería completa.

- Quest e infllm Use métodos de selección de bloque, pero su puntuación basada en heurística a menudo resulta en tasas de retiro más bajas.

NSA Aborda estas limitaciones integrando la escasez de forma nativa—Encenerse la eficiencia tanto en el entrenamiento como en la inferencia al tiempo que preserva la precisión del modelo. Esto significa No hay aproximaciones post-hoc o compensaciones entre la velocidad y la capacidad de razonamiento.

El rendimiento de la NSA en las tareas del mundo real

Para validar la efectividad de la NSA, los investigadores lo probaron en una variedad de tareas de IA, comparando su rendimiento con modelos tradicionales de atención plena y métodos de atención escasa de última generación. Los resultados destacan la capacidad de la NSA para coincidir o superar los modelos de atención completa mientras reduce significativamente los costos computacionales.

Rendimiento de referencia general

NSA demostró Fuerte precisión entre el conocimiento, el razonamiento y la codificación de puntos de referenciaincluido:

- MMLU y CMMLU: Hacer coincidir toda la atención en las tareas basadas en el conocimiento

- GSM8K y Matemáticas: Superar la atención completa en un razonamiento complejo

- Humaneval y MBPP: Entrega de un rendimiento de codificación sólida

Comprensión de contexto largo

NSA sobresale en el manejo de secuencias de contexto largo en puntos de referencia como Bancada larga. En las tareas que requieren memoria contextual profunda, NSA mantuvo:

- Alto retiro en tareas de recuperación (Aguja-in a-haystack, documento QA)

- Precisión estable en razonamiento multi-salto (HPQ, 2Wiki, Govrpt)

Ganancias de velocidad del mundo real

Las optimizaciones alineadas en hardware en NSA conducen a:

- 9 × velocidades de inferencia más rápidas para secuencias de 64k-longitud

- 6 × eficiencia de entrenamiento más rápida En comparación con los modelos de atención completa

- Consumo de ancho de banda de memoria reducidohacer que las aplicaciones de IA a gran escala sean más factibles