La inteligencia artificial está mejorando para comprender el mundo en tres dimensiones, pero un nuevo estudio sugiere que muchos Los puntos de referencia del modelo de idioma grande 3D (LLM) podrían no estar probando capacidades 3D en absoluto. En cambio, estas evaluaciones pueden ser víctimas de lo que los investigadores llaman el problema de «2D-stating», donde los modelos de IA capacitados principalmente en imágenes 2D pueden superar a los modelos 3D dedicados simplemente al convertir las nubes de puntos en las imágenes.

Un equipo de la Universidad Shanghai Jiao Tong, incluidos Jiahe Jin, Yanheng He y Mingyan Yang, ha encontrado en su estudio: «»Revisando los puntos de referencia 3D LLM: ¿Realmente estamos probando capacidades 3D? ”, que muchas tareas utilizadas para evaluar la IA 3D se pueden resolver con la misma facilidad mediante modelos de lenguaje de visión (VLMS), los sistemas AI capacitados principalmente en imágenes y texto 2D. Esto plantea una pregunta crucial: ¿Los puntos de referencia actuales realmente miden la comprensión 3D, o simplemente están probando qué tan bien la IA puede procesar las representaciones 2D de los datos 3D?

Catadeo 2D: el atajo que expone puntos de referencia débiles

El problema proviene de cómo se evalúan los LLM 3D. Muchos puntos de referencia existentes confían en Preguntas y respuestas y titulares de tareasdonde se le pide a una IA que describa un objeto 3D o responda preguntas al respecto. La suposición es que un IA capacitada en 3D Debería funcionar mejor de una que solo comprende imágenes 2D.

Sin embargo, los investigadores encontraron que VLMS como GPT-4O y QWEN2-VLque no fueron diseñados específicamente para tareas 3D, podría a menudo superan los modelos 3D de última generación—Mint Simple mirando imágenes 2D de nubes puntuales. Esto sugiere que estos puntos de referencia en realidad no están probando si la IA entiende las estructuras 3D, sino más bien Qué tan bien puede inferir información 3D de imágenes planas.

Para demostrar esto, el equipo desarrolló VLM3Dun método que convierte las nubes de punto 3D en imágenes renderizadas antes de alimentarlas en un VLM. Cuando se analiza en los principales puntos de referencia de AI 3D, incluido 3D MM-VET, ObjAversexl-Lvis, Scanqa y SQA3D—Vlm3d superó o coincidió constantemente modelos 3D líderes en muchas tareas.

Por qué algunas tareas 3D son más vulnerables que otras

Mientras que los VLM se destacaron en tareas como el reconocimiento de objetos y la descripción básica de la escena, tuvieron problemas en las tareas que requirieron una comprensión más profunda de Relaciones espaciales, oclusiones y consistencia múltiple.

- Puntos de referencia simples de objetos 3D: Muchas tareas de reconocimiento de objetos en puntos de referencia 3D podrían ser fácilmente resuelto usando imágenes 2D. El estudio encontró que los VLM podrían coincidir o exceder los modelos 3D en estos casos, lo que demuestra que los puntos de referencia no estaban probando efectivamente la comprensión 3D.

- Partes de referencia de escena complejos: Tareas que requieren que la IA entienda entornos 3D completos, como Preguntas y respuestas a nivel de escena, navegacióny razonamiento situacionalfueron mucho más difíciles de hacer trampa para VLMS. Aquí, 3D LLMS constantemente tuvieron un mejor rendimiento, lo que demuestra que estas tareas dependen del verdadero razonamiento espacial 3D.

Esto significa que No todos los puntos de referencia 3D son defectuosos—Pero muchos de ellos no pueden distinguir entre capacidad 3D genuina y trucos de inferencia 2D.

Cuando los modelos 2D se atascan

Una de las mayores debilidades de VLM en las tareas 3D proviene de Selección de punto de vista—El hecho de que una sola imagen 2D solo captura parte de una escena 3D.

Los investigadores probaron tres enfoques de representación diferentes Para evaluar cuánto impacta el rendimiento:

- Vista única: El enfoque más simple, donde un objeto o escena se representa desde una perspectiva fija. VLMS se desempeñó mejor aquíya que podían extraer suficiente información de una sola imagen.

- Vista múltiple: Las imágenes fueron capturadas de cuatro ángulos diferentesdando a los modelos de IA más contexto. Sorprendentemente, VLMS no mejoró significativamente En comparación con los modelos de visión única, lo que sugiere que luchan por combinar múltiples perspectivas en una comprensión 3D unificada.

- Vista de Oracle: La IA fue dada el mejor punto de vista posible por responder a cada pregunta. Aquí, VLMS funcionó mucho mejorpero aún no alcanzó 3D LLMS dedicado, lo que demuestra que incluso cuando se les dan imágenes perfectas, carecen de verdaderas habilidades de razonamiento 3D.

Esto refuerza la idea de que VLMS no «entiende» 3D—La les va bien cuando se les dan las vistas 2D correctas.

Lo que necesita cambiar

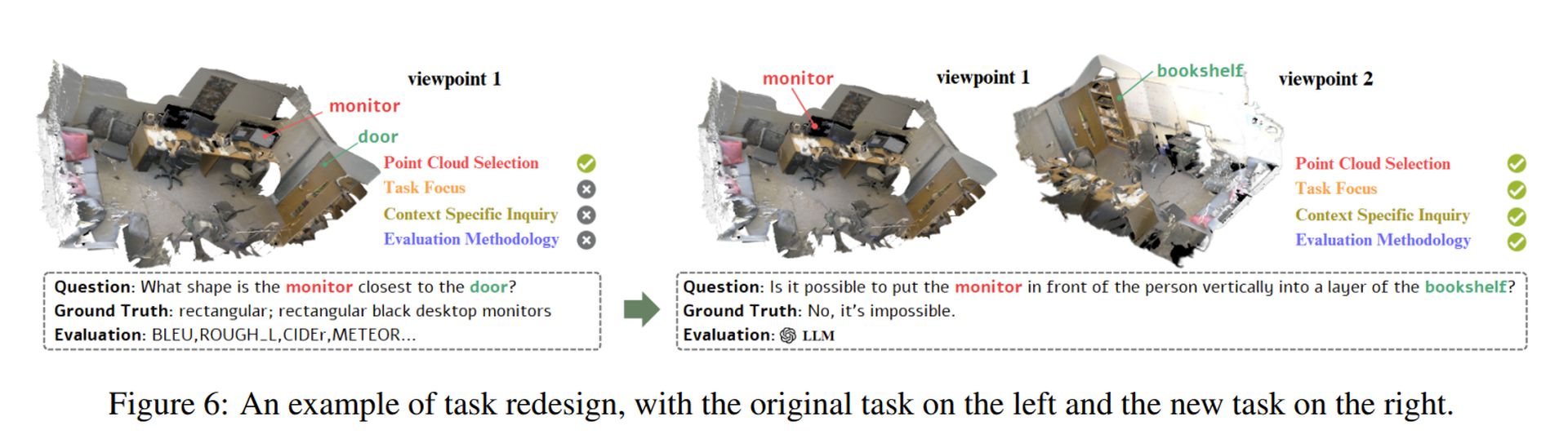

Para evaluar realmente los modelos de IA 3D, el estudio propone Cuatro principios clave Para diseñar mejores puntos de referencia:

- Datos 3D más complejos: En lugar de usar nubes de punto de objeto simples, los puntos de referencia deben incluir escenas 3D detalladas y realistas con complejidad estructural.

- Tareas que requieren un razonamiento 3D real: En lugar de solo reconocer objetos, la IA debe probarse en tareas que requieren comprensión espacialcomo predecir superficies ocultas o razonamiento sobre las interacciones de los objetos.

- Desafíos conscientes del contexto: Las preguntas deben estar diseñadas para centrarse en propiedades 3D únicasasegurando que no puedan ser respondidos usando solo una imagen 2D.

- Mejores métricas de evaluación: Los puntos de referencia actuales a menudo confían en puntajes de similitud de textoque no pueden capturar verdadero entendimiento 3D. En cambio, los modelos de IA deben evaluarse en función de su capacidad para Inferir la profundidad, la estructura y las relaciones de los objetos en el espacio tridimensional.

Los investigadores demostraron cómo estos principios podrían aplicarse por Rediseñando una tarea defectuosa (Ver imagen de arriba). Su enfoque asegura que los modelos de IA deban realmente Procesar estructuras 3D en lugar de confiar en atajos 2D.

Crédito de imagen destacado: Sebastian Svenson/Unsplash