Un nuevo modelo de IA llamado S1, presentado En un artículo publicado el 2 de febrero, atrae la atención por su rendimiento rentable que rivaliza con el O1 de Openai, logrando capacidades significativas a un costo de capacitación de solo $ 6.

AI Modelo S1 emerge como una alternativa rentable al O1 de OpenAi

El modelo S1 alcanza los niveles de rendimiento cercanos al estado de arte, utilizando una infraestructura más simple. Mejora los modelos de idiomas grandes (LLM) durante la inferencia al extender el «tiempo de pensamiento» a través de intervenciones como reemplazar las etiquetas terminales con indicaciones como «espera».

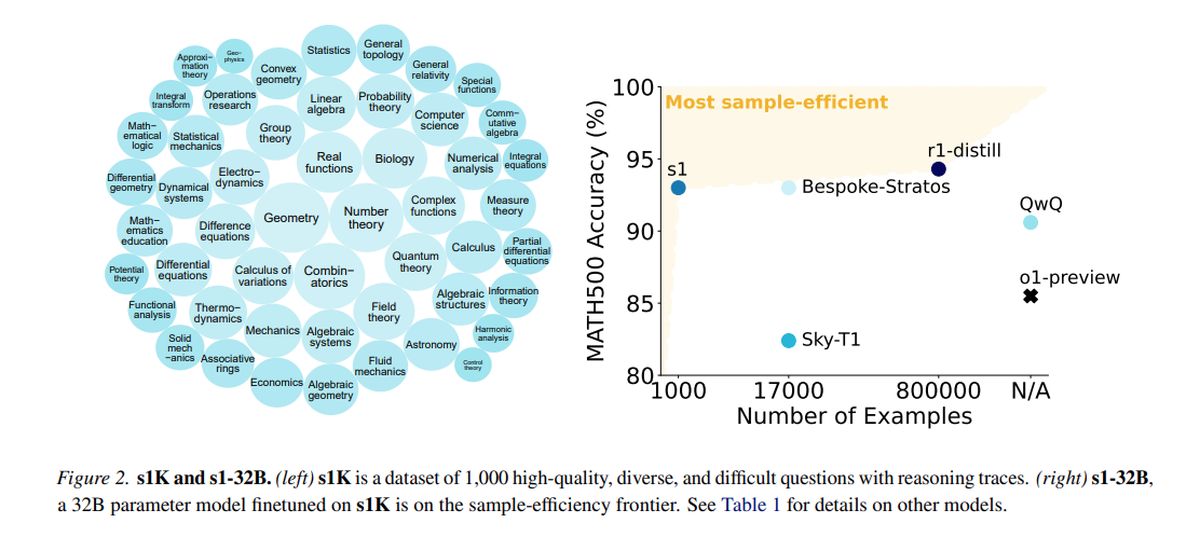

Entrenado en un conjunto de datos destilados que consta de 1,000 ejemplos de alta calidad de Qwen2.5, desarrollado por Alibaba Cloud, S1 empleó 16 GPU H100 NVIDIA, con una sola carrera de capacitación que duró aproximadamente 26 minutos. El costo computacional total fue de aproximadamente $ 6, lo que permitió una experimentación más frecuente, incluso para equipos con recursos limitados.

Mientras que organizaciones más grandes como OpenAI y Anthrope dependen de una infraestructura extensa, las innovaciones como S1 demuestran el potencial de progreso dentro de los presupuestos restringidos. Sin embargo, la introducción de S1 ha provocado preocupaciones con respecto al «Declaración», una práctica en la que los modelos utilizan conjuntos de datos destilados de otros sistemas de IA, planteando cuestiones éticas y legales que han encendido las discusiones de la industria.

En las pruebas que miden las matemáticas y las habilidades de codificación, S1 realiza comparablemente a los principales modelos de razonamiento, como Openi’s O1 y Deepseek’s R1. El modelo S1, incluidos sus datos y código de entrenamiento, es accesible en GitHub.

El equipo detrás de S1 comenzó con un modelo base listo para usar y lo refinó a través de la destilación, un método para extraer capacidades de razonamiento de un modelo de IA existente utilizando sus respuestas. Específicamente, S1 se destila de Google Géminis 2.0 Experimental de pensamiento flash, que representa un enfoque similar utilizado por los investigadores de Berkeley para desarrollar un modelo de razonamiento de IA por aproximadamente $ 450 el mes pasado.

La capacidad de los equipos de investigación más pequeños para innovar en el espacio de IA sin un respaldo financiero sustancial presenta tanto la emoción como los desafíos. La pregunta surge sobre la sostenibilidad de las ventajas patentadas en un paisaje donde los modelos costosos pueden replicarse de manera asequible.

Operai ha expresado insatisfacción, alegando que Deepseek se cosechó de manera inadecuada los datos de su API con el propósito de destilación modelo. Los investigadores tenían como objetivo diseñar un enfoque directo que logre un rendimiento de razonamiento robusto y la «escalada de tiempo de prueba», lo que permite a los modelos de IA realizarse en un análisis más profundo antes de responder.

La investigación S1 indica que los modelos de razonamiento pueden destilarse utilizando un conjunto de datos relativamente pequeño a través de un método llamado ajuste fino supervisado (SFT), que instruye al modelo AI que imiten ciertos comportamientos dentro de un conjunto de datos. Este método tiende a ser más económico que el enfoque de aprendizaje de refuerzo a gran escala utilizado por Deepseek para su modelo R1.

Google proporciona acceso gratuito a Gemini 2.0 Flash Thinking Experimental, aunque el uso está sujeto a límites de tarifa diaria, y sus términos prohíben que los modelos de ingeniería inversa creen servicios competidores. El proceso de capacitación S1 implicó curar un conjunto de datos de 1,000 preguntas y respuestas personalizadas junto con los procesos de razonamiento derivados de Gemini 2.0.

Después del entrenamiento, que tomó menos de 30 minutos, S1 demostró un fuerte rendimiento en puntos de referencia de IA específicos. Niklas Manennighoff, un investigador de Stanford involucrado en el proyecto, indicó que los recursos informáticos necesarios podrían alquilar hoy por alrededor de $ 20.

Los investigadores también implementaron una técnica para mejorar la precisión de S1 al instruirlo a «esperar» durante el razonamiento, extendiendo así su tiempo de pensamiento y logrando respuestas ligeramente mejoradas.

Crédito de imagen destacado: Google DeepMind/Unsplash