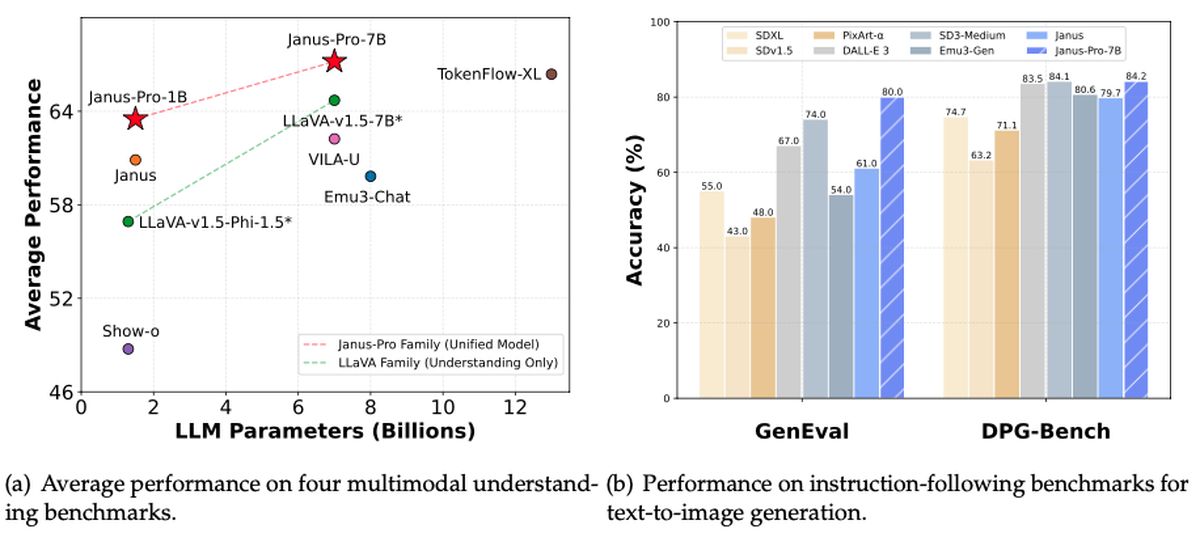

Deepseek ha presentado otra contribución importante al paisaje de IA de código abierto. Esta vez, es Janus-Pro-7b: una potencia multimodal capaz de comprender y generar imágenes. De acuerdo a Rowan Cheungel nuevo modelo no solo eclipsa el Dall-E 3 de OpenAI y la difusión estable en puntos de referencia como Gineval y DPG-Bench, sino que también muestra el mismo espíritu «disponible» que hizo que el modelo R1 anterior de Deepseek fuera de Deepseek sea una sensación viral. Mientras tanto, los inversores están luchando por dar sentido al aumento en los avances de IA, con Las acciones de Nvidia se sumergen más del 17% al mediodía.

¿Podría Janus-Pro-7B ser el próximo gran disruptor en un mercado tecnológico ya turbulento?

¿Qué es Deepseek Janus-Pro-7b?

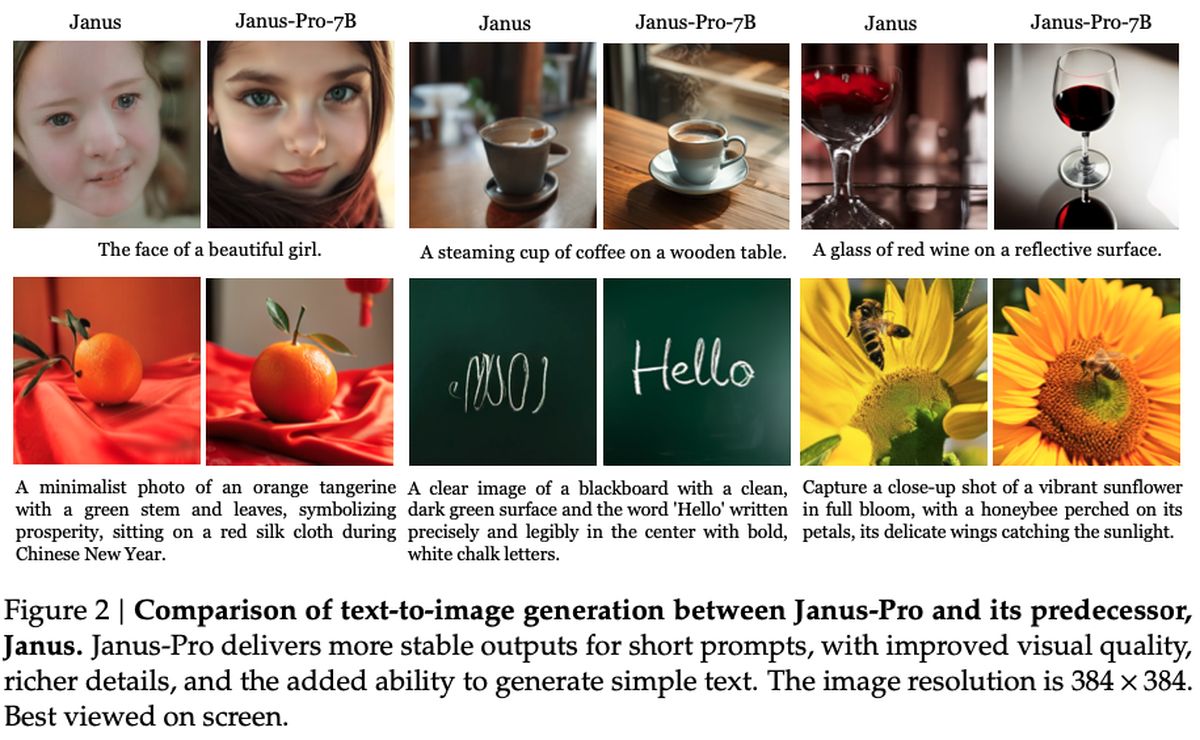

Bajo el capó, Janus-Pro-7b busca cerrar la brecha entre el poderoso procesamiento de la visión y la generación de texto rápido. Al tomar prestado un nuevo enfoque de desacoplamiento de su codificador Siglip-L, el sistema puede analizar rápidamente una imagen de 384 x 384 antes de saltar al modo de salida creativa. Coincide, o incluso supera, muchos modelos especializados en el espacio, un logro especialmente sorprendente dado que también sigue siendo notablemente fácil de personalizar y extender.

Los analistas señalan la filosofía consistente de Deepseek: manténgalo de código abierto, mantenga la privacidad primero y subrayan rivales basados en suscripción. Janus-Pro-7b parece entregar los tres frentes, estableciendo marcas de alto rendimiento al tiempo que preserva la accesibilidad que atrajo a los fanáticos a las capacidades fuera de línea de Deepseek-R1.

En términos puramente objetivos, Janus-Pro-7b tiene licencia bajo un permiso permisivo Marco del MITcon pautas de uso adicionales de Deepseek. El modelo se integra con proyectos posteriores a través de un repositorio de GitHub, y según los informes, utiliza solo 16x muestreo en su tubería de generación de imágenes. Los indicadores actuales sugieren que la llegada de Janus-Pro-7B puede generar una nueva competencia entre los desarrolladores de IA, aunque solo el tiempo dirá cómo esta última oferta gratuita afectará la zona de IA.

¿Cómo configurar Deepseek-R1 fácilmente de forma gratuita (en línea y local)?

¿Cómo funciona?

Como se detalla en el trabajo de investigación Publicado por Deepseek, el modelo emplea un codificador Siglip-Large-Patch16-384, que divide cada imagen en parches 16 × 16 a una resolución de 384 × 384. Este enfoque conserva los detalles de grano fino, ayudando al sistema a interpretar las imágenes con mayor precisión. En el lado de la generación, Janus-Pro utiliza un libro de códigos de 16,384 tokens para representar imágenes a una escala de 16 × muestras descendentes, lo que permite reconstrucciones eficientes que rivalizan, si no superan los modelos de difusión tradicionales en calidad.

Dos adaptadores clave de MLP (perceptrón de múltiples capas) conectan estos componentes de comprensión y generación, asegurando los flujos de datos sin problemas entre las dos tareas. Durante el entrenamiento, el modelo ve una combinación de datos de imagen y texto, lo que le permite aprender tanto cómo interpretar escenas visuales como producir sus propias imágenes. Las sesiones generalmente tardan de 7 a 14 días en grupos de GPU a gran escala (para versiones de parámetros 1.5B y 7B), con rendimiento probado en puntos de referencia como GQA (para la comprensión visual) y VisualGen (para la creación de imágenes). El resultado es un marco versátil que se destaca en tareas multimodales, gracias a su arquitectura especializada pero cohesiva.

¿Cómo usar Deepseek Janus-Pro-7b?

Comenzar con Janus-Pro-7B es tan simple como dirigirse a su repositorio oficial de GitHub, clonando o descargando el código e instalando las dependencias necesarias. El repositorio incluye un ReadMe integral que lo guía a través de la configuración de un entorno de Python, tirando de los pesos del modelo y ejecutando scripts de muestra. Dependiendo de su hardware, puede elegir entre el modo solo CPU o la aceleración de GPU del arnés para un rendimiento más rápido. De cualquier manera, el proceso de instalación permanece sencillo, gracias a los requisitos previos bien documentados e instrucciones paso a paso.

Una vez que todo está en funcionamiento, puede alimentar las indicaciones para la generación de texto o proporcionar entradas de imagen para las capacidades multimodales únicas del modelo. Los cuadernos de muestra en el repositorio demuestran cómo generar salidas creativas, aplicar transformaciones de imágenes avanzadas o explorar escenarios de «preguntas y respuestas visuales». Para los usuarios más avanzados, el diseño modular del repositorio significa que puede ajustar las capas subyacentes, conectar sus propios conjuntos de datos o incluso apilar el modelo junto con otras versiones profundas como R1.