Deepseek-R1 está dominando las discusiones tecnológicas en los foros de Reddit, X y Developer, con los usuarios que lo llaman «AI de People’s» por su extraña capacidad de rivalizar modelos pagados como Google Gemini y el GPT-4O de OpenAI, todo sin costar nada.

Deepseek-r1a razonamiento de código abierto y de código abierto aiofrece una alternativa de privacidad primero al modelo O1 de $ 200/mes de OpenAi, con un rendimiento comparable en codificación, matemáticas y resolución lógica de problemas. Esta guía proporciona instrucciones paso a paso para instalar Deepseek-R1 localmente e integrarla en proyectos, potencialmente ahorrando cientos de dólares mensualmente.

¿Por qué Deepseek-R1 es de tendencia?

A diferencia de los modelos cerrados que bloquean a los usuarios en suscripciones y acuerdos de intercambio de datos, Deepseek-R1 opera completamente fuera de línea cuando se implementa localmente. Los puntos de referencia de las redes sociales lo muestran resolviendo problemas de código de leet 12% más rápido que OPERAI’S O1 modelo mientras usa solo el 30% de los recursos del sistema. Una demostración de Tiktok que codifica un rastreador de gastos basado en Python en 90 segundos ha acumulado 2.7 millones de visitas, con comentarios como «Gemini nunca podría» inundar el hilo. Su atractivo? Sin tarifas de API, sin límites de uso y sin conexión a Internet obligatoria.

¿Qué es Deepseek-R1 y cómo se compara con OpenAI-O1?

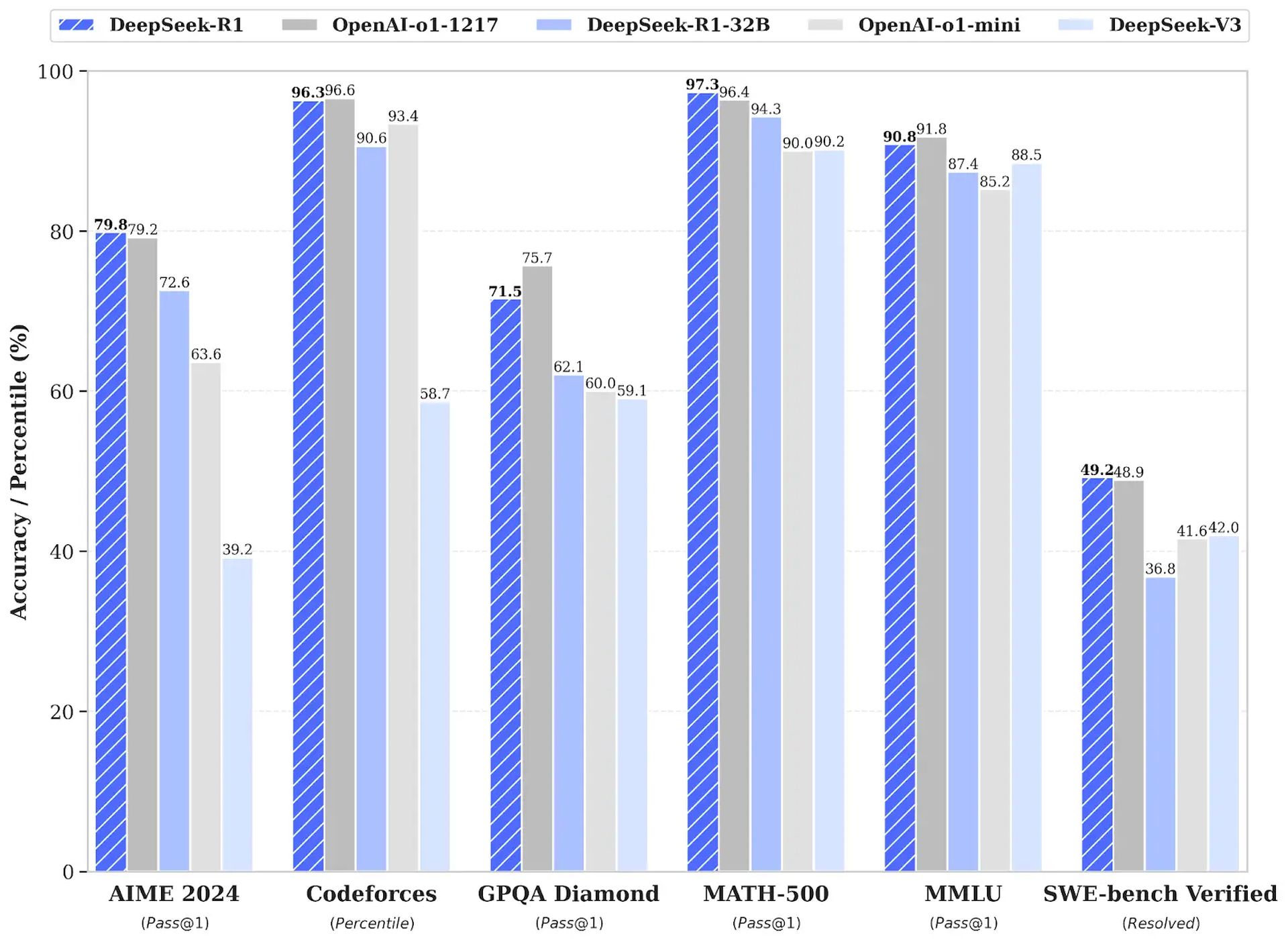

Deepseek-R1 es una IA de razonamiento revolucionaria que utiliza el aprendizaje de refuerzo (RL) en lugar de ajustar supervisado, logrando un puntaje de 79.8% pase@1 en el punto de referencia de matemáticas AIME 2024. Supera a OpenAI-O1 en rentabilidad, con los costos de API un 96.4% más barato ($ 0.55 vs. $ 15 por millón de tokens de entrada) y la capacidad de ejecutarse localmente en el hardware del consumidor. Deepseek-R1 es de código abierto, que ofrece seis modelos destilados que van desde 1.5B a 671B de parámetros para diversas aplicaciones.

Guía de instalación paso a paso para Deepseek-R1 (local)

Para instalar Deepseek-R1 localmente utilizando Ollama y Open Web UI, siga estos pasos:

1. Instalar Ollama a través de terminal (macOS/Linux):

curl -fsSL https://ollama.com/install.sh | sh ollama -v #check Ollama version2. Descargue un modelo destilado Deepseek-R1 a través de Ollama:

# Default 7B model (4.7GB - ideal for consumer GPUs)

ollama run deepseek-r1

# Larger 70B model (requires 24GB+ VRAM)

ollama run deepseek-r1:70b

# Full DeepSeek-R1 (requires 336GB+ VRAM for 4-bit quantization)

ollama run deepseek-r1:671b3. Configure la interfaz de usuario web Open para una interfaz privada:

docker run -d -p 3000:8080

--add-host=host.docker.internal:host-gateway

-v open-webui:/app/backend/data

--name open-webui

--restart always

ghcr.io/open-webui/open-webui:mainAcceder a la interfaz en http: // localhost: 3000 y seleccionar deepseek-r1:latest. Todos los datos permanecen en su máquina, asegurando la privacidad.

Cómo integrar Deepseek-R1 en sus proyectos

Deepseek-r1 se puede integrar localmente o a través de su API de nube:

1. Implementación local (privacidad primero):

import openai

Connect to your local Ollama instance

client = openai.Client(

base_url="http://localhost:11434/v1",

api_key="ollama" # Authentication-free private access

)

response = client.chat.completions.create(

model="deepseek-r1:XXb ", # change the "XX" by the distilled model you choose

messages=[{"role": "user", "content": "Explain blockchain security"}],

temperature=0.7 # Controls creativity vs precision

)2. Uso de la API oficial de nube Deepseek-R1:

import openai from dotenv import load_dotenv import os

load_dotenv()

client = openai.OpenAI(

base_url="https://api.deepseek.com/v1",

api_key=os.getenv("DEEPSEEK_API_KEY")

)

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": "Write web scraping code with error handling"}],

max_tokens=1000 # Limit costs for long responses

)Deepseek-R1 proporciona una alternativa rentable y centrada en la privacidad a OpenAI-O1, ideal para los desarrolladores que buscan ahorrar dinero y mantener la seguridad de los datos. Para obtener más ayuda o para compartir experiencias, se alienta a los usuarios a interactuar con la comunidad.

Crédito de imagen destacado: Veterano