Generación de texto a video ya no es lo que era hace apenas unos años. Lo transformamos en una herramienta con una funcionalidad verdaderamente futurista. Los usuarios crean contenido para páginas personales, las personas influyentes lo aprovechan para la autopromoción y las empresas lo utilizan para todo, desde publicidad y materiales educativos hasta capacitación virtual y producción de películas. La mayoría de los sistemas de texto a vídeo se basan en la arquitectura de transformadores de difusión, que son la vanguardia en el mundo de la generación de vídeo. Esta tecnología sirve como base para servicios como Luma y Kling. Sin embargo, este estatus no se consolidó hasta 2024, cuando los primeros transformadores de difusión para vídeo ganaron adopción en el mercado.

El punto de inflexión llegó con Lanzamiento de OpenAI de SORAmostrando tomas increíblemente realistas que eran casi indistinguibles de la vida real. OpenAI demostró que su transformador de difusión podía generar contenido de vídeo con éxito. Este movimiento validó el potencial de la tecnología y provocó una tendencia en toda la industria: ahora, aproximadamente el 90% de los modelos actuales se basan en transformadores de difusión.

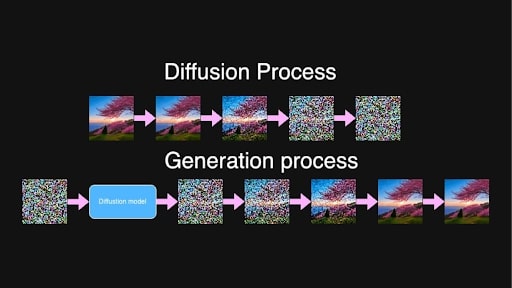

La difusión es un proceso fascinante que merece una exploración más exhaustiva. Entendamos cómo funciona la difusión, los desafíos que aborda la tecnología de transformadores en este proceso y por qué juega un papel tan importante en la generación de texto a video.

¿Cuál es el proceso de difusión en GenAI?

En el corazón de la generación de texto a vídeo y de texto a imagen se encuentra el proceso de difusión. Inspirados en el fenómeno físico en el que las sustancias se mezclan gradualmente (como la tinta que se difunde en el agua), los modelos de difusión en el aprendizaje automático implican un proceso de dos pasos: agregar ruido a los datos y luego aprender a eliminarlo.

Durante el entrenamiento, el modelo toma imágenes o secuencias de cuadros de video y agrega progresivamente ruido en varios pasos hasta que el contenido original se vuelve indistinguible. Básicamente, lo convierte en puro ruido.

Procesos de difusión y generación para el mensaje “Hermoso árbol de sakura colocado en la colina durante el amanecer”

Procesos de difusión y generación para el mensaje “Hermoso árbol de sakura colocado en la colina durante el amanecer”

Al generar contenido nuevo, el proceso funciona a la inversa. El modelo está entrenado para predecir y eliminar el ruido en incrementos, centrándose en un paso de ruido intermedio aleatorio entre dos puntos, t y t+1. Debido al largo proceso de entrenamiento, el modelo ha observado todos los pasos en la progresión desde ruido puro hasta imágenes casi limpias y ahora tiene bastante capacidad para identificar y reducir el ruido básicamente en cualquier nivel.

A partir de ruido puro y aleatorio, el modelo, guiado por el texto de entrada, crea iterativamente fotogramas de vídeo que son coherentes y coinciden con la descripción textual. El contenido de vídeo detallado y de alta calidad es el resultado de este proceso muy gradual.

La difusión latente es lo que hace que esto sea computacionalmente posible. En lugar de trabajar directamente con imágenes o vídeos de alta resolución, un codificador comprime los datos en un espacio latente.

Esto se hace para reducir (significativamente) la cantidad de datos que el modelo necesita procesar, acelerando la generación sin comprometer la calidad. Después de que el proceso de difusión refina las representaciones latentes, un decodificador las transforma nuevamente en imágenes o videos de resolución completa.

El problema con la generación de vídeo.

A diferencia de una sola imagen, el vídeo requiere que los objetos y personajes permanezcan estables en todo momento, evitando cambios inesperados o de apariencia. Todos hemos visto las maravillas de las que es capaz la IA generativa, pero la falta ocasional de un brazo o una expresión facial indistinguible está dentro de la norma. En el vídeo, sin embargo, hay más en juego; La consistencia es primordial para una sensación fluida.

Entonces, si un personaje aparece en el primer cuadro con un atuendo específico, ese atuendo debe verse idéntico en cada cuadro posterior. Cualquier cambio en la apariencia del personaje, o cualquier “transformación” de los objetos en el fondo, rompe la continuidad y hace que el video parezca antinatural o incluso inquietante.

Imagen proporcionada por el autor.

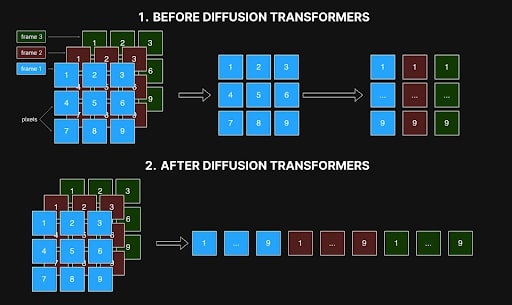

Los primeros métodos abordaban la generación de vídeo procesando fotogramas individualmente, donde cada píxel de un fotograma solo hacía referencia a su píxel correspondiente en otros. Sin embargo, este enfoque fotograma a fotograma a menudo daba lugar a inconsistencias, ya que no podía capturar las relaciones espaciales y temporales entre fotogramas que son esenciales para transiciones suaves y movimientos realistas. Artefactos como colores cambiantes, formas fluctuantes o características desalineadas son el resultado de esta falta de coherencia y disminuyen la calidad general del video.

Imagen proporcionada por el autor.

Imagen proporcionada por el autor.

El mayor obstáculo para resolver esto fue la demanda computacional y el costo. Para un vídeo de 10 segundos a 10 fotogramas por segundo, generar 100 fotogramas aumenta la complejidad exponencialmente. Crear estos 100 fotogramas es aproximadamente 10.000 veces más complejo que generar un solo fotograma debido a la necesidad de una coherencia precisa entre fotogramas. Esta tarea requiere 10.000 veces más en términos de memoria, tiempo de procesamiento y recursos computacionales, superando a menudo los límites prácticos. Como puede imaginar, el lujo de experimentar con este proceso estaba al alcance de unos pocos elegidos en la industria.

Esto es lo que hizo que el lanzamiento de SORA por parte de OpenAI fuera tan significativo: demostraron que los transformadores de difusión podían efectivamente manejar la generación de video a pesar de la inmensa complejidad de la tarea.

Cómo los transformadores de difusión resolvieron el problema de la autoconsistencia en la generación de vídeo

La aparición de transformadores de difusión abordó varios problemas: permitieron la generación de vídeos de resolución y duración arbitrarias y al mismo tiempo lograron una alta coherencia. Esto se debe en gran medida a que pueden trabajar con secuencias largas, siempre que quepan en la memoria, y al mecanismo de autoatención.

En inteligencia artificial, la autoatención es un mecanismo que calcula los pesos de atención entre elementos de una secuencia, determinando en qué medida cada elemento debe ser influenciado por otros. Permite que cada elemento de una secuencia considere todos los demás elementos simultáneamente y permite que los modelos se centren en partes relevantes de los datos de entrada al generar resultados, capturando dependencias tanto en el espacio como en el tiempo.

En la generación de vídeo, esto significa que cada píxel de cada fotograma puede relacionarse con todos los demás píxeles de todos los fotogramas. Esta interconexión garantiza que los objetos y personajes permanezcan consistentes a lo largo de todo el vídeo, de principio a fin. Si un personaje aparece en un cuadro, la atención propia ayuda a evitar cambios y a mantener la apariencia de ese personaje en todos los cuadros posteriores.

Antes, los modelos incorporaban una forma de autoatención dentro de una red convolucional, pero esta estructura limitaba su capacidad para lograr la misma consistencia y coherencia que ahora es posible con los transformadores de difusión.

Sin embargo, con atención espacio-temporal simultánea en transformadores de difusión, la arquitectura puede cargar datos de diferentes marcos simultáneamente y analizarlos como una secuencia unificada. Como se muestra en la imagen a continuación, los métodos anteriores procesaban interacciones dentro de cada cuadro y solo vinculaban cada píxel con su posición correspondiente en otros cuadros (ver Figura 1). Esta visión restringida obstaculizó su capacidad para capturar las relaciones espaciales y temporales esenciales para un movimiento suave y realista. Ahora, con los transformadores de difusión, todo se procesa simultáneamente (Figura 2).

Interacción espacio-temporal en redes de difusión antes y después de transformadores. Imagen proporcionada por el autor.

Interacción espacio-temporal en redes de difusión antes y después de transformadores. Imagen proporcionada por el autor.

Este procesamiento holístico mantiene detalles estables en todos los fotogramas, asegurando que las escenas no se transformen inesperadamente y se conviertan en un desastre incoherente de un producto final. Los transformadores de difusión también pueden manejar secuencias de longitud y resolución arbitrarias, siempre que quepan en la memoria. Con este avance, la generación de vídeos más largos es factible sin sacrificar la coherencia o la calidad, abordando desafíos que los métodos anteriores basados en convolución no podían superar.

La llegada de los transformadores de difusión reformuló la generación de texto a vídeo. Permitió la producción de videos autoconsistentes y de alta calidad en longitudes y resoluciones arbitrarias. La autoatención dentro de los transformadores es un componente clave para abordar desafíos como mantener la coherencia del marco y manejar relaciones espaciales y temporales complejas. El lanzamiento de SORA por parte de OpenAI demostró esta capacidad, estableciendo un nuevo estándar en la industria: ahora, aproximadamente el 90% de los sistemas avanzados de texto a video se basan en transformadores de difusión, con actores importantes como Luma, Clink y Runway Gen-3 liderando el mercado.

A pesar de estos impresionantes avances, los transformadores de difusión siguen consumiendo muchos recursos y requieren casi 10.000 veces más recursos que la generación de una sola imagen, lo que hace que el entrenamiento de modelos de alta calidad siga siendo una tarea muy costosa. Sin embargo, la comunidad de código abierto ha tomado medidas importantes para hacer que esta tecnología sea más accesible. Proyectos como Open-SORA y Open-SORA-Plan, así como otras iniciativas como Mira Video Generation, Cog y Cog-2, han abierto nuevas posibilidades para que desarrolladores e investigadores experimenten e innoven. Respaldados por empresas e instituciones académicas, estos proyectos de código abierto dan esperanzas de un progreso continuo y una mayor accesibilidad en la generación de videos, beneficiando no solo a las grandes corporaciones sino también a los creadores independientes y entusiastas deseosos de experimentar. Esto, como cualquier otro esfuerzo impulsado por la comunidad, abre un futuro en el que se democratiza la generación de videos, llevando esta poderosa tecnología a muchos más creativos para que la exploren.