Según un bbc Según el informe, la recién lanzada plataforma de inteligencia artificial de Apple, Apple Intelligence, enfrentó una reacción violenta después de anunciar incorrectamente la muerte de Luigi Mangione, un sospechoso de asesinato. La notificación, enviada vía iPhone la semana pasada, resumió una bbc informar incorrectamente, lo que generó críticas tanto de los usuarios como de las organizaciones de medios. Este incidente plantea importantes dudas sobre la confiabilidad y precisión de la información generada por IA.

La herramienta de inteligencia artificial de Apple informa erróneamente la notificación de muerte del sospechoso de asesinato

Apple ha integrado Apple Intelligence en sus sistemas operativos, incluidos iOS 18 y macOS Sequoia. Entre sus características, la plataforma ofrece herramientas de IA generativa diseñadas para la escritura y la creación de imágenes. Además, proporciona una función para categorizar y resumir notificaciones, destinada a reducir las distracciones del usuario a lo largo del día. Sin embargo, la reciente notificación falsa resalta posibles imprecisiones y deficiencias de esta nueva característica, dejando a los usuarios perplejos y preocupados por la integridad de la información que se comparte.

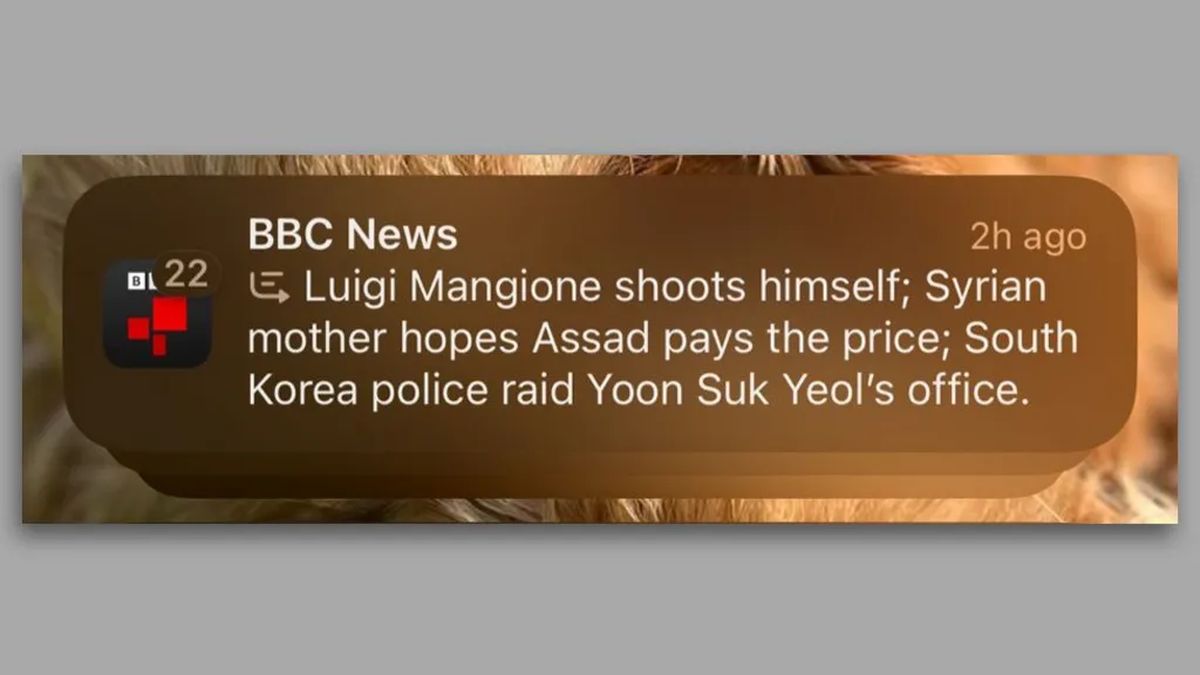

En una notificación fechada el 13 de diciembre de 2024, los usuarios de iPhone recibieron un mensaje que decía: “Luigi Mangione se pega un tiro”, junto con otros dos resúmenes de noticias de última hora. Esta notificación errónea rápidamente llamó la atención, particularmente porque informaba erróneamente un detalle crucial sobre Mangione, acusado de matar al ex director ejecutivo de UnitedHealthcare, Brian Thompson, el 4 de diciembre. bbcque no había publicado ninguna información sobre el presunto disparo de Mangione, presentó una denuncia ante Apple. Desde entonces, la red ha pedido a Apple que reconsidere su herramienta de inteligencia artificial generativa.

El problema subyacente parece surgir de los modelos de lenguaje (LLM) utilizados por Apple Intelligence. De acuerdo a la calleKomninos Chatzipapas, director de Orion AI Solutions, «Los LLM como GPT-4o… realmente no tienen ninguna comprensión inherente de lo que es verdad y lo que no». Estos modelos predicen estadísticamente las siguientes palabras basándose en vastos conjuntos de datos; sin embargo, este método puede dar como resultado contenido que parezca confiable y que tergiverse los hechos. En este caso, Chatzipapas especuló que Apple pudo haber entrenado inadvertidamente su modelo de resumen con ejemplos similares en los que individuos se dispararon, generando un titular engañoso.

Las implicaciones de este incidente se extienden más allá de las prácticas internas de Apple. Reporteros sin Fronteras ha instado a la empresa a eliminar la función de resumen, destacando la gravedad de la difusión de información inexacta vinculada a medios de comunicación acreditados. Vincent Berthier de Reporteros sin Fronteras articulado preocupaciones sobre la desinformación generada por la IA que daña la credibilidad de las fuentes de noticias. Afirmó: «Las IA son máquinas de probabilidad y los hechos no se pueden decidir tirando los dados». Esto refuerza el argumento de que los modelos de IA carecen actualmente de la madurez necesaria para garantizar una difusión fiable de noticias.

No permita que la IA se beneficie del dolor y la pena de las familias

Este incidente no es aislado. Desde el lanzamiento de Apple Intelligence en EE. UU. en junio, los usuarios han informado de más imprecisiones, incluida una notificación que afirmaba incorrectamente que el primer ministro israelí, Benjamín Netanyahu, había sido arrestado. Aunque la Corte Penal Internacional emitió una orden de arresto contra Netanyahu, la notificación omitió un contexto crucial y solo mostró la frase “Netanyahu arrestado”.

La controversia en torno a Apple Intelligence revela desafíos relacionados con la autonomía de los editores de noticias en la era de la IA. Si bien algunas organizaciones de medios emplean activamente herramientas de inteligencia artificial para escribir e informar, los usuarios de la función de Apple reciben resúmenes que pueden tergiversar los hechos, y todo ello aparece bajo el nombre del editor. Este principio podría tener implicaciones más amplias sobre cómo se reporta y percibe la información en la era digital.

Apple aún no ha respondido a las consultas sobre su proceso de revisión o cualquier paso que pretenda tomar en relación con el BBC preocupaciones. El panorama actual de la tecnología de inteligencia artificial, moldeado significativamente por la introducción de plataformas como ChatGPT, ha estimulado una rápida innovación, pero también crea un terreno fértil para imprecisiones que pueden engañar al público. A medida que continúan las investigaciones sobre el contenido generado por IA y sus implicaciones, la importancia de garantizar la confiabilidad y la precisión se vuelve cada vez más primordial.

Crédito de la imagen destacada: Maxim Hopman/Unsplash