- No todos los LLM son iguales: GPT-3.5-turbo-instruct se destaca como el modelo de ajedrez más capaz probado.

- El ajuste es crucial: El ajuste de instrucciones y la exposición específica de conjuntos de datos mejoran drásticamente el rendimiento en dominios específicos.

- El ajedrez como referente: El experimento destaca el ajedrez como un punto de referencia valioso para evaluar las capacidades de LLM y perfeccionar los sistemas de inteligencia artificial.

¿Pueden los modelos de lenguaje de IA jugar al ajedrez? Esa pregunta provocó una investigación reciente sobre qué tan bien los modelos de lenguaje grandes (LLM) manejan las tareas de ajedrez, revelando ideas inesperadas sobre sus fortalezas, debilidades y metodologías de entrenamiento.

Si bien algunos modelos fracasaron incluso contra los motores de ajedrez más simples, otros, como la instrucción turbo GPT-3.5 de OpenAI, mostraron un potencial sorprendente, lo que apunta a implicaciones intrigantes para el desarrollo de la IA.

Prueba de LLM contra motores de ajedrez

Los investigadores probaron varios LLM pidiéndoles que jugaran ajedrez como grandes maestros, proporcionando estados del juego en notación algebraica. El entusiasmo inicial se centró en si los LLM, capacitados en vastos corpus de texto, podrían aprovechar el conocimiento incorporado del ajedrez para predecir movimientos de manera efectiva.

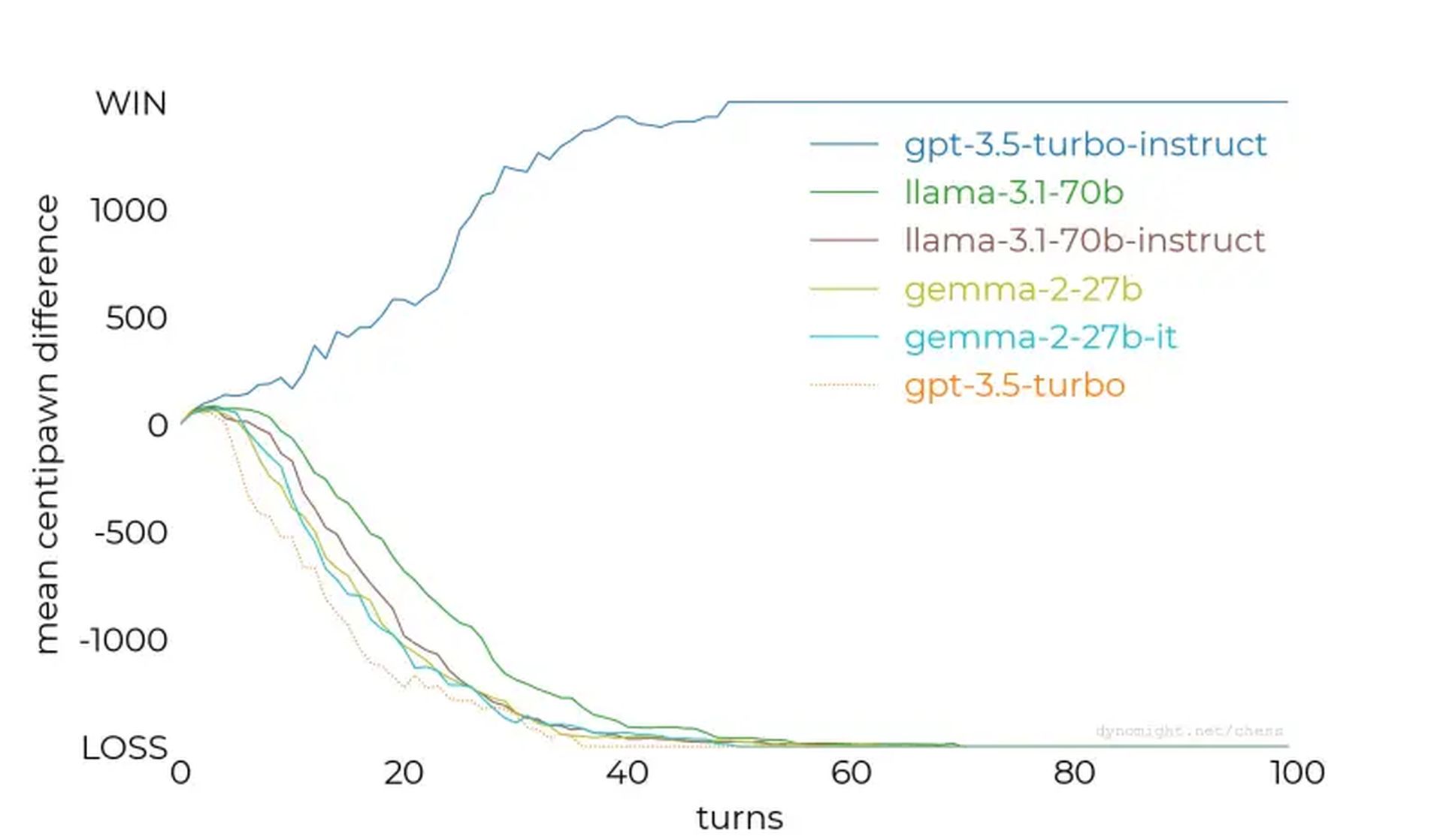

Sin embargo, los resultados mostraron que no todos los LLM son iguales.

El estudiar comenzó con modelos más pequeños como llama-3.2-3bque tiene 3 mil millones de parámetros. Después de 50 juegos contra el nivel de dificultad más bajo de Stockfish, el modelo perdió todos los partidos, sin poder proteger sus piezas ni mantener una posición favorable en el tablero.

Las pruebas se escalaron a modelos más grandes, como llama-3.1-70b y su variante adaptada a las instrucciones, pero también tuvieron problemas y mostraron sólo ligeras mejoras. Otros modelos, incluidos Qwen-2.5-72b y comando-r-v01continuó la tendencia, revelando una incapacidad general para comprender incluso las estrategias básicas del ajedrez.

GPT-3.5-turbo-instruct fue el ganador inesperado

El punto de inflexión llegó con GPT-3.5-turbo-instrucciónque sobresalió contra Stockfish, incluso cuando se aumentó el nivel de dificultad del motor. A diferencia de sus homólogos orientados al chat como gpt-3.5-turbo y gpt-4oel modelo ajustado por instrucciones produjo consistentemente movimientos ganadores.

¿Por qué algunos modelos sobresalen mientras que otros fracasan?

Los hallazgos clave de la investigación ofrecieron información valiosa:

- El ajuste de instrucciones importa: Modelos como GPT-3.5-turbo-instruct se beneficiaron del ajuste de la retroalimentación humana, lo que mejoró su capacidad para procesar tareas estructuradas como el ajedrez.

- Exposición del conjunto de datos: Se especula que los modelos de instrucción pueden haber estado expuestos a un conjunto de datos más rico de juegos de ajedrez, lo que les otorga un razonamiento estratégico superior.

- Desafíos de la tokenización: Pequeños matices, como espacios incorrectos en las indicaciones, alteraron el rendimiento y resaltaron la sensibilidad de los LLM al formato de entrada.

- Los datos en competencia influyen: Capacitar a los LLM en diversos conjuntos de datos puede diluir su capacidad para sobresalir en tareas especializadas, como el ajedrez, a menos que se contrarreste con ajustes específicos.

A medida que la IA continúa mejorando, estas lecciones informarán estrategias para mejorar el rendimiento del modelo en todas las disciplinas. Ya sea ajedrez, comprensión del lenguaje natural u otras tareas complejas, comprender cómo entrenar y ajustar la IA es esencial para desbloquear todo su potencial.

Crédito de imagen destacada: Piotr Makowski/desempaquetar