OpenAI Orion, el modelo de IA de próxima generación de la compañía, está chocando contra muros de rendimiento que exponen las limitaciones de los enfoques de escalamiento tradicionales. Fuentes familiarizadas con el asunto revelan que Orion está generando menores ganancias de rendimiento que sus predecesores, lo que llevó a OpenAI a repensar su estrategia de desarrollo.

Las primeras pruebas revelan mejoras estancadas

Las pruebas iniciales de los empleados indican que Orión OpenAI logró un rendimiento de nivel GPT-4 después de completar solo el 20% de su entrenamiento. Si bien esto puede parecer impresionante, es importante tener en cuenta que las primeras etapas del entrenamiento de la IA suelen producir las mejoras más espectaculares. Es poco probable que el 80% restante de la capacitación produzca avances significativos, lo que sugiere que OpenAI Orion podría no superar a GPT-4 por un amplio margen.

«Algunos investigadores de la compañía creen que Orion no es mejor que su predecesor en el manejo de ciertas tareas», informó La información. «Orion se desempeña mejor en tareas de lenguaje, pero es posible que no supere a los modelos anteriores en tareas como la codificación, según un empleado de OpenAI».

El dilema de la escasez de datos

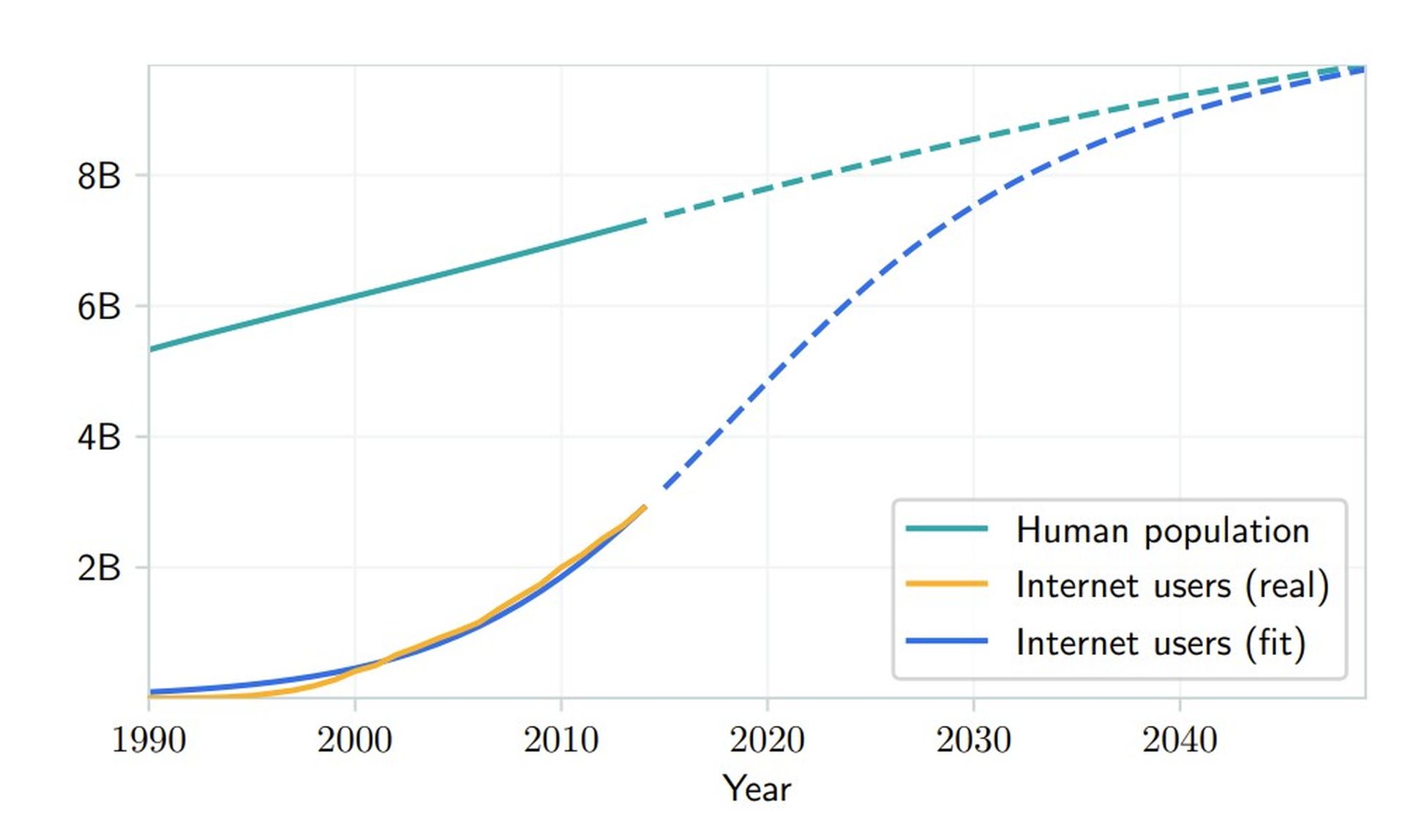

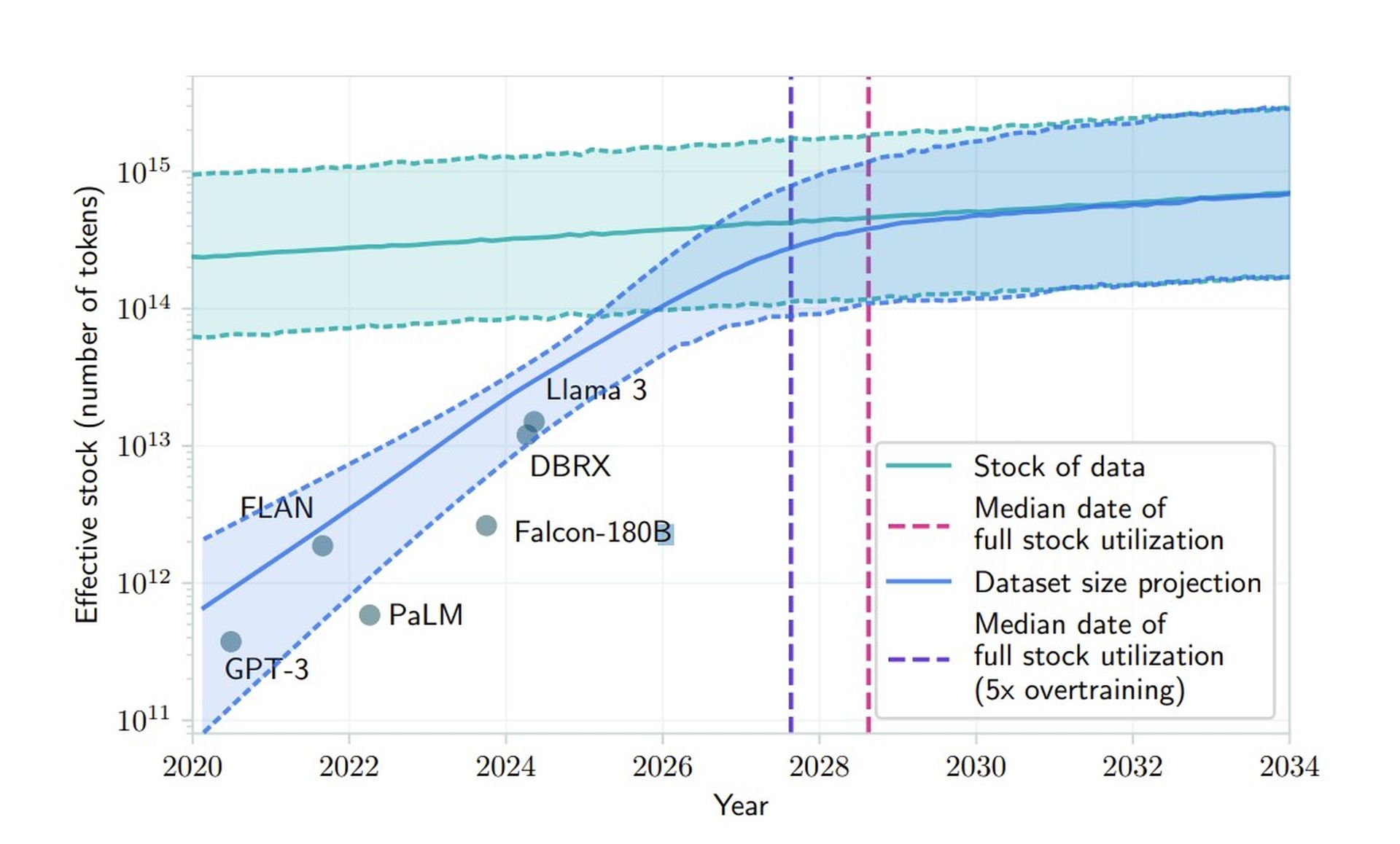

Los desafíos de OpenAI con Orion resaltan un problema fundamental en la industria de la IA: la oferta cada vez menor de datos de entrenamiento de alta calidad. Una investigación publicada en junio predice que las empresas de inteligencia artificial agotarán los datos de texto públicos disponibles generados por humanos entre 2026 y 2032. Esta escasez marca un punto de inflexión crítico para los enfoques de desarrollo tradicionales, lo que obliga a empresas como OpenAI a explorar métodos alternativos.

«Nuestros hallazgos indican que las tendencias actuales de desarrollo de LLM no pueden sostenerse únicamente mediante el escalamiento de datos convencional», la investigación estados de papel. Esto subraya la necesidad de generar datos sintéticos, transferir aprendizaje y utilizar datos no públicos para mejorar el rendimiento del modelo.

La estrategia de desarrollo de doble vía de OpenAI

Para abordar estos desafíos, OpenAI está reestructurando su enfoque separando el desarrollo de modelos en dos vías distintas. La Serie O, cuyo nombre en código es Strawberry, se centra en las capacidades de razonamiento y representa una nueva dirección en la arquitectura de modelos. Estos modelos operan con una intensidad computacional significativamente mayor y están diseñados explícitamente para tareas complejas de resolución de problemas.

Paralelamente, los modelos Orion (o la serie GPT) continúan evolucionando, concentrándose en tareas generales de procesamiento del lenguaje y comunicación. El director de productos de OpenAI, Kevin Weil, confirmó esta estrategia durante una AMA y afirmó: «No es ni una ni otra, son ambas: mejores modelos base y más cálculo de tiempo de inferencia/escala fresa».

Datos sintéticos: un arma de doble filo

OpenAI está explorando la generación de datos sintéticos para abordar la escasez de datos para OpenAI Orion. Sin embargo, esta solución introduce nuevas complicaciones a la hora de mantener la calidad y fiabilidad del modelo. Los modelos de entrenamiento sobre contenido generado por IA pueden conducir a ciclos de retroalimentación que amplifican imperfecciones sutiles, creando un efecto compuesto que es cada vez más difícil de detectar y corregir.

Los investigadores han descubierto que depender en gran medida de datos sintéticos puede hacer que los modelos se degraden con el tiempo. El equipo de Foundations de OpenAI está desarrollando nuevos mecanismos de filtrado para mantener la calidad de los datos, implementando técnicas de validación para distinguir entre contenido sintético de alta calidad y potencialmente problemático. También están explorando enfoques de capacitación híbridos que combinan contenido generado por humanos y por IA para maximizar los beneficios y minimizar los inconvenientes.

OpenAI Orion aún se encuentra en sus primeras etapas, con un importante trabajo de desarrollo por delante. El director ejecutivo, Sam Altman, ha indicado que no estará listo para su implementación este año ni el próximo. Este cronograma ampliado podría resultar ventajoso, ya que permitiría a los investigadores abordar las limitaciones actuales y descubrir nuevos métodos para mejorar el modelo.

Ante mayores expectativas después de una reciente ronda de financiación de 6.600 millones de dólares, OpenAI pretende superar estos desafíos innovando su estrategia de desarrollo. Al abordar de frente el dilema de la escasez de datos, la compañía espera garantizar que OpenAI Orion tenga un impacto sustancial en su eventual lanzamiento.

Crédito de la imagen destacada: Jonathan Kemper/Unsplash