En un mundo dominado por modelos de IA inflados que viven en la nube, Mistral AI está cambiando el guión. La startup francesa acaba de soltado dos nuevos modelos, Ministral 3B y 8B, que están diseñados para ejecutarse en dispositivos perimetrales.

Les Ministraux: Ministral 3B y 8B

Las nuevas ofertas de Mistral, denominadas “Les Ministraux”, pueden parecer una película de autor francesa, pero estos modelos están preparados para revolucionar el mundo de la IA. Con sólo 3 mil millones y 8 mil millones de parámetros respectivamente, la familia Ministraux apuesta por la eficiencia. Olvídese de esos modelos de IA que acaparan recursos y que requieren un centro de datos para funcionar.

«Nuestros clientes y socios más innovadores han estado pidiendo cada vez más inferencias locales que prioricen la privacidad para aplicaciones críticas», explicó Mistral.

Longitud del contexto como nunca antes

Aquí es donde la cosa se pone realmente interesante: tanto el modelo 3B como el 8B pueden manejar una ventana de contexto de 128.000 tokens. Eso es el equivalente a un libro de 50 páginas. A modo de comparación, incluso OpenAI GPT-4 Turbo limita aproximadamente el mismo número de tokens, y eso no es poca cosa.

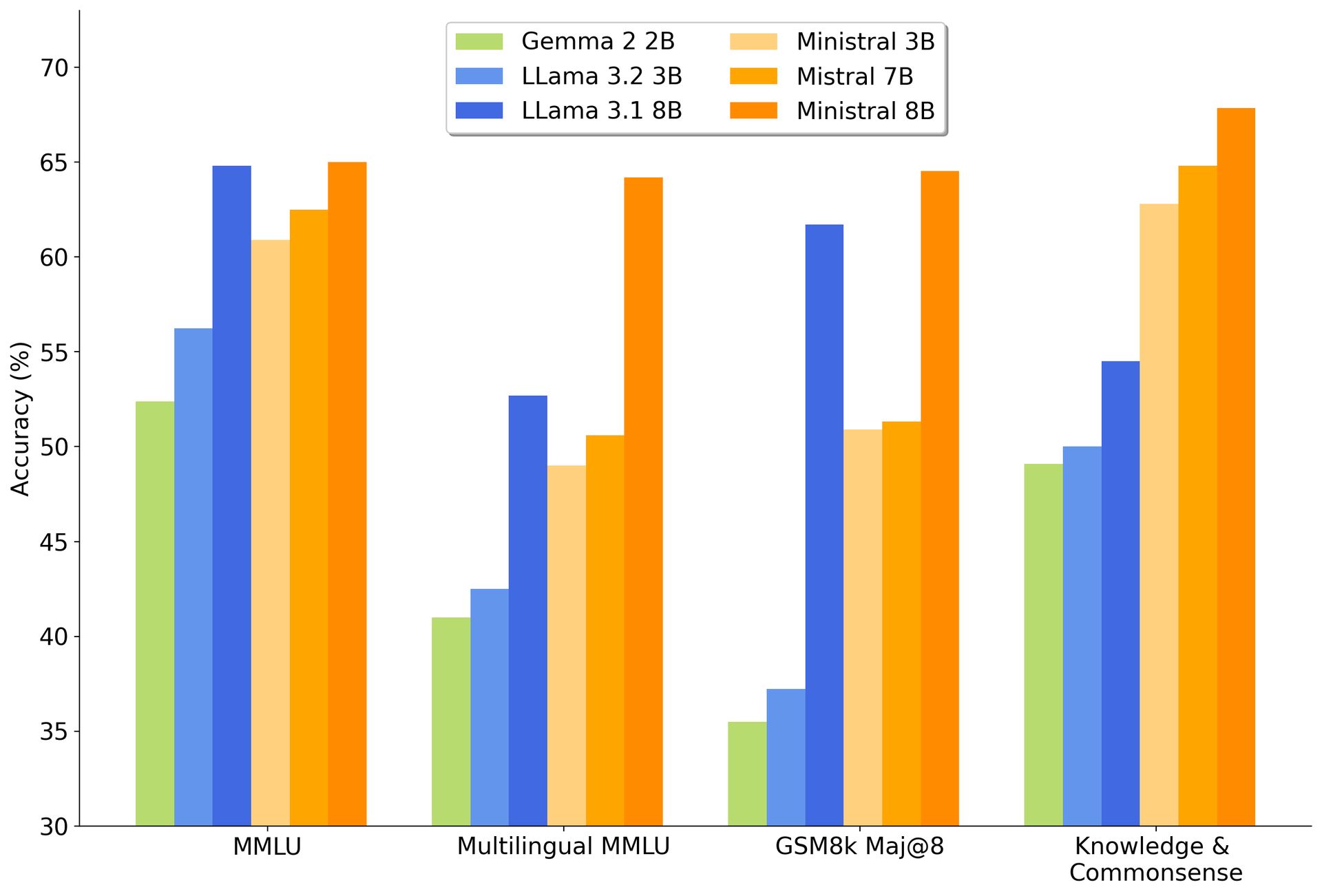

Con este tipo de capacidad, los modelos Ministraux no sólo superan a su predecesor, el Mistral 7B, sino que también se están comiendo el rendimiento de Google. Gema 2 2B y Modelos de Llama de Meta para el desayuno.

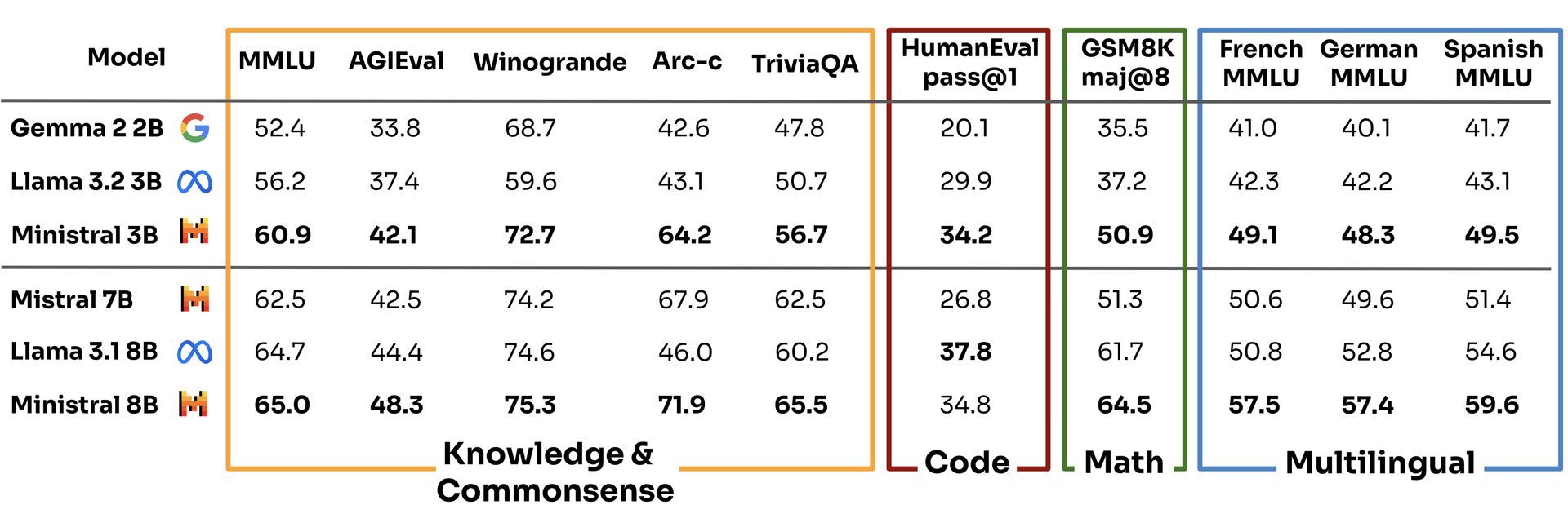

Según los propios puntos de referencia de Mistral, el modelo 3B obtuvo una puntuación de 60,9 en la evaluación de comprensión del lenguaje multitarea, dejando atrás a competidores como Llama 3.2 3B y Gemma 2 2B con 56,2 y 52,4, respectivamente.

Nada mal para un modelo “más pequeño”, ¿verdad?

Mientras todos los demás en el mundo de la IA luchan por crear modelos más grandes y malos que consumen energía, Mistral está jugando un juego diferente. Al ejecutarse en dispositivos locales, Les Ministraux eliminó la necesidad de servidores masivos en la nube y, al hacerlo, ofrece una opción mucho más ecológica. Es una medida que se alinea perfectamente con la creciente presión sobre las empresas de tecnología para que sean más conscientes del medio ambiente. La IA podría ser el futuro, pero nadie quiere que ese futuro llegue a costa del planeta.

También está el ángulo de la privacidad. Como todo se ejecuta localmente, sus datos permanecen en su dispositivo, lo cual es una gran victoria para industrias como la atención médica y las finanzas, que están cada vez más bajo el microscopio por la forma en que manejan la información confidencial. Puedes considerarlo como IA sin espionaje: un cambio refrescante en un mundo donde cada aplicación parece estar recopilando más datos que la NSA.

El plan maestro de Mistral: construir, alterar, repetir

Pero no nos engañemos: Mistral no está haciendo esto sólo por un bien mayor. La empresa, cofundada por ex alumnos de Meta y DeepMind de Google, está en el negocio de causar sensación. Ya han recaudado 640 millones de dólares en capital de riesgo y están enfocados en construir modelos de IA que no solo rivalicen con GPT-4 de OpenAI y Claude de Anthropic, sino que también obtengan ganancias en el proceso.

Y aunque ganar dinero en el espacio de la IA generativa es tan fácil como ganar la lotería, Mistral no se echa atrás. De hecho, comenzaron a generar ingresos el verano pasado, que es más de lo que se puede decir de muchos de sus competidores.

Al ofrecer Ministral 8B con fines de investigación y hacer que ambos modelos estén disponibles a través de su plataforma en la nube, La Platforme, Mistral se está posicionando como el chico genial en el bloque de la IA: lo suficientemente abierto para atraer desarrolladores, pero lo suficientemente inteligente como para monetizar su tecnología a través de asociaciones estratégicas. Es un enfoque híbrido que refleja lo que hicieron los gigantes del código abierto como Red Hat en el mundo Linux, fomentando la comunidad y al mismo tiempo manteniendo las cajas registradoras sonando.

Créditos de imagen: Mistral