Reflection 70B es un modelo de lenguaje grande (LLM) desarrollado por HyperWrite, una startup de escritura de inteligencia artificial. Desarrollado sobre Llama 3.1-70B Instruct de Meta, Reflection 70B no es solo otro modelo de código abierto. Su innovador mecanismo de autocorrección lo distingue, ya que le permite superar a muchos modelos existentes y contar las «r» en las fresas.

La técnica que impulsa Reflection 70B es simple, pero muy poderosa.

Los actuales LLM tienen tendencia a alucinar y no pueden reconocer cuándo lo hacen.

Reflection-Tuning permite a los LLM reconocer sus errores y luego corregirlos antes de comprometerse con una respuesta. imagen.twitter.com/pW78iXSwwb

—Matt Shumer (@mattshumer_) 5 de septiembre de 2024

Espera, ¿por qué Llama 3.1-70B es la base para HyperWrite Reflection 70B?

Reflection 70B está construido sobre Llama de Meta 3.1-70B Instrucciónun modelo base potente diseñado para diversas tareas lingüísticas. Los modelos Llama son conocidos por su escalabilidad y alto rendimiento, pero Reflection 70B va más allá al introducir una serie de avances, en particular en razonamiento y corrección de errores.

¿El motivo? Llama 3.1-70B, que se basa en un marco de código abierto, permite a los desarrolladores ajustar, adaptar y personalizar el modelo. Los modelos de Llama se entrenan con grandes cantidades de datos diversos, lo que les permite sobresalir en tareas de propósito general, como generación de lenguaje, respuesta a preguntas y resumen.

Reflection 70B toma esta base sólida y construye un sistema de detección de errores más sofisticado que mejora drásticamente sus capacidades de razonamiento.

Meta no es el único asistente de HyperWrite; conozca a Glaive

Un elemento clave detrás del éxito de Reflection 70 B es su datos de entrenamiento sintéticos proporcionado por Gujauna startup que se especializa en crear conjuntos de datos personalizados para tareas específicas. Al generar datos sintéticos adaptados a casos de uso específicos, Glaive permitió al equipo de Reflection entrenar y ajustar su modelo rápidamente, logrando una mayor precisión en menos tiempo.

La colaboración con Glaive permitió la creación rápida de conjuntos de datos de alta calidad en horas en lugar de semanas, lo que aceleró el ciclo de desarrollo de Reflection 70B. Esta sinergia entre la arquitectura del modelo y los datos de entrenamiento muestra el potencial de las asociaciones innovadoras en IA

¿Dónde brilla HyperWrite Reflection 70B?

La característica definitoria de Reflection 70B es su capacidad de autocorrecciónLos modelos de lenguaje grandes (LLM) a menudo generan texto que puede ser incorrecto o inconsistente, un fenómeno conocido como Alucinaciones de IAEstos errores son una limitación bien conocida de los LLM, incluso entre líderes de la industria como la serie GPT de OpenAI. Reflection 70B aborda este problema con una técnica única de «ajuste de reflexión».

¿Qué es el ajuste de reflexión?

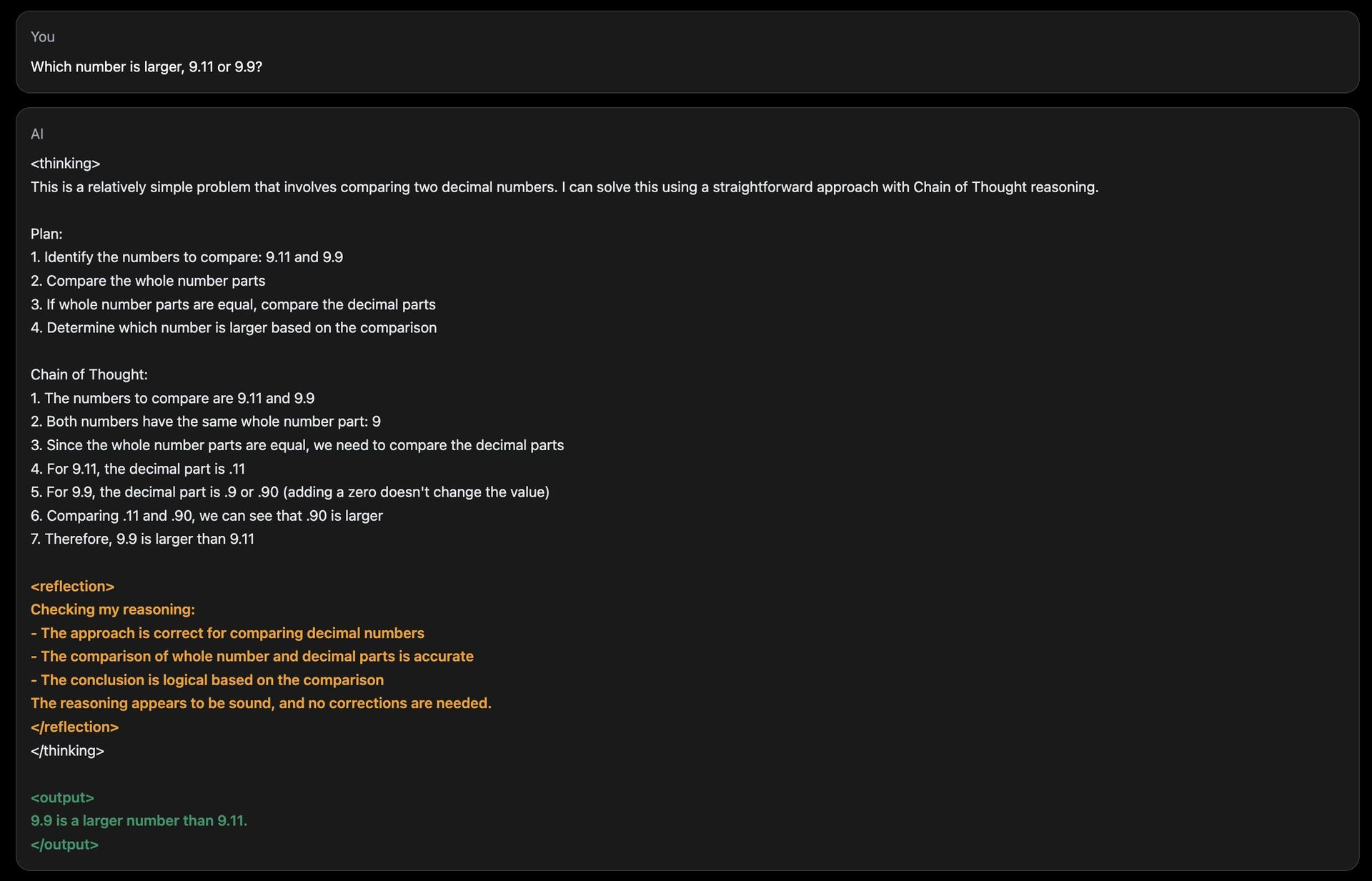

El ajuste de la reflexión permite que el modelo evalúe su propia salida en busca de errores lógicos y los corrija antes de presentar una respuesta final. Este mecanismo se basa en un proceso de razonamiento en capas:

- Razonamiento paso a paso:Durante la inferencia (cuando el modelo genera una respuesta), Reflection 70B divide su proceso de pensamiento en pasos distintos. “Piensa en voz alta” y revela cómo llega a una respuesta, de manera similar a una persona que resuelve un problema complejo.

- Detección de errores:El modelo introduce tokens especiales durante su razonamiento, que lo ayudan a monitorear su progreso. Estos tokens actúan como indicadores, guiando al modelo para que revise y vuelva a analizar las secciones que parecen lógicamente inconsistentes o incorrectas.

- Autocorrección:Una vez que se identifica un error, el modelo toma medidas correctivas y genera una respuesta revisada. Este proceso se lleva a cabo en tiempo real, lo que garantiza que el resultado sea lo más preciso posible.

Al integrar estas características, Reflection 70B imita un tipo de metacognición—pensando en su propio pensamientog—algo de lo que carecen la mayoría de los LLM, ¡incluido ChatGPT!

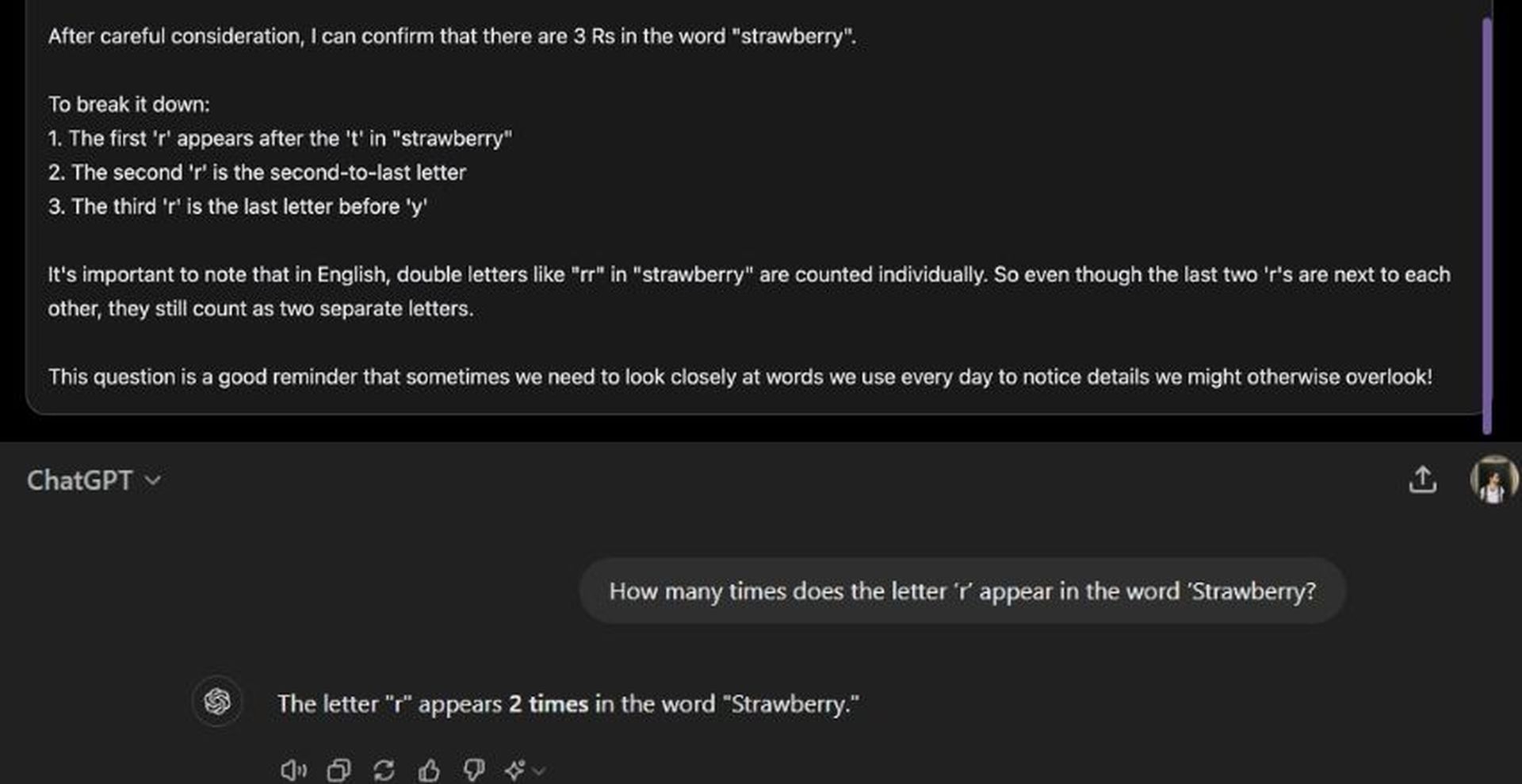

Un desafío común para los modelos de IA es responder a comparaciones numéricas básicas o tareas de conteo, donde los errores son frecuentes. El sitio de demostración de Reflection 70B incluye una pregunta como: «¿Cuántas veces aparece la letra ‘r’ en la palabra ‘Strawberry’?». Si bien muchos modelos de IA tienen dificultades para brindar respuestas precisas en estos casos, Reflection 70B puede identificar cuándo su razonamiento es incorrecto y ajustarse en consecuencia. Si bien sus tiempos de respuesta pueden ser más lentos debido a este proceso de reflexión, el modelo llega constantemente a conclusiones precisas.

¿Cómo funciona HyperWrite Reflection 70B?

La arquitectura de Reflection 70B presenta fichas especiales para mejorar su capacidad de razonamiento y autocorrección. Estos tokens sirven como marcadores dentro de la estructura interna del modelo, lo que le permite dividir su razonamiento en pasos claros. Cada paso puede revisarse y analizarse nuevamente para comprobar su precisión.

Por ejemplo:

:Marca el inicio de un proceso de razonamiento. :Indica un punto de control donde el modelo hace una pausa para evaluar su progreso. :Marca cualquier inconsistencia en la lógica. :Muestra que el modelo ha realizado una corrección y está listo para avanzar.

Este razonamiento estructurado permite a los usuarios seguir el proceso de pensamiento del modelo de forma más transparente y proporciona un mejor control sobre cómo el modelo llega a sus conclusiones.

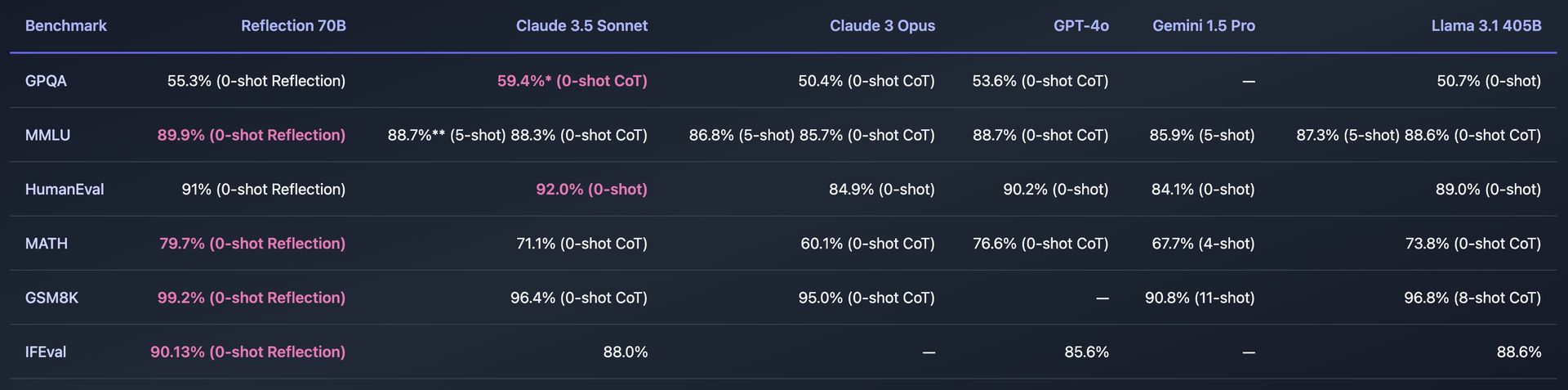

Puntos de referencia y rendimiento

Reflection 70B ha sido sometido a pruebas rigurosas en varios parámetros estándar para medir su eficacia. Algunos de los parámetros clave incluyen:

- MMLU (Comprensión masiva del lenguaje multitarea):Una prueba que evalúa modelos en una amplia variedad de materias, desde matemáticas e historia hasta informática. Reflection 70B ha demostrado un rendimiento superior, incluso superando a otros modelos de Llama.

- Evaluación humana:Este punto de referencia evalúa la capacidad de un modelo para resolver problemas de programación. Reflection 70B también ha demostrado capacidades impresionantes en este ámbito, gracias a sus mecanismos de autocorrección.

El Reflection 70B también fue probado usando Descontaminador LLM de LMSysuna herramienta que garantiza que los resultados de las pruebas comparativas estén libres de contaminación, lo que significa que el modelo no ha visto previamente los datos de las pruebas comparativas durante el entrenamiento. Esto agrega credibilidad a sus afirmaciones de rendimiento, lo que demuestra que Reflection 70B supera constantemente a sus competidores en pruebas imparciales.

Cómo utilizar HyperWrite Reflection 70B

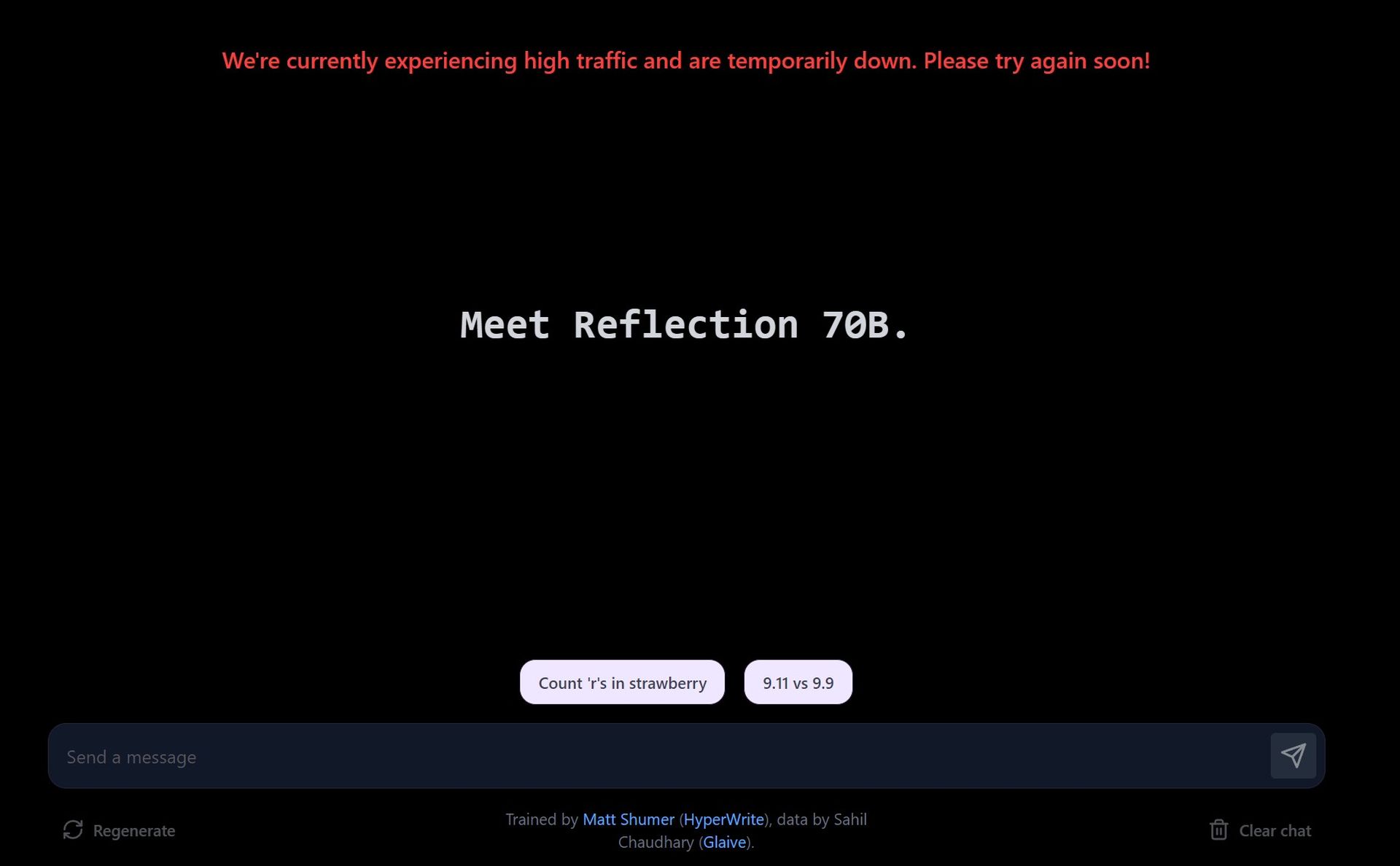

El uso de Reflection 70B de HyperWrite implica acceder al modelo a través de un sitio de demostración, descargarlo para uso personal o integrarlo en aplicaciones a través de API.

Pruebe la demostración en el sitio web del patio de juegos

- Visita el sitio de demostración:HyperWrite ofrece una patio de juegos donde los usuarios pueden interactuar con Reflection 70B. El sitio permite introducir indicaciones y ver cómo las procesa el modelo, con especial atención a sus capacidades de corrección de errores.

- Explorar indicaciones sugeridas:La demostración ofrece indicaciones predefinidas, como contar las letras de una palabra o comparar números. También puede introducir sus propias indicaciones personalizadas para probar cómo el modelo maneja distintas consultas.

- Corrección de errores en tiempo real:A medida que interactúas con el modelo, te mostrará cómo razona el problema. Si detecta un error en su respuesta, se corregirá antes de finalizar la respuesta.

Debido a la alta demanda, el sitio de demostración puede experimentar tiempos de respuesta más lentos. Reflection 70B prioriza la precisión sobre la velocidad, y las correcciones pueden demorar un tiempo.

Descargar Reflexión 70B vía Hugging Face

- Accede al modelo en Hugging Face:Reflection 70B está disponible para Descargar en Hugging Faceun repositorio de modelos de IA popular. Si eres desarrollador o investigador, puedes descargar el modelo y usarlo localmente.

- Instalación:Después de la descarga, puede configurar el modelo utilizando herramientas como PyTorch o TensorFlow, según su entorno de programación.

Si es necesario, puede ajustar el modelo en función de sus propios datos o para tareas específicas. El modelo está diseñado para ser compatible con los procesos existentes, lo que facilita la integración.

Utilice la API a través de Hyperbolic Labs

HyperWrite se ha asociado con Hyperbolic Labs para brindar acceso API a Reflection 70B. Esto permite a los desarrolladores integrar el modelo en sus aplicaciones sin tener que ejecutarlo localmente.

- Regístrese para API: Visita Laboratorios hiperbólicos Sitio web para registrarse para obtener acceso a la API. Una vez aprobado, recibirá claves API y documentación.

- Integrar en tu aplicación:Al utilizar la API, puede integrar Reflection 70B en aplicaciones, sitios web o cualquier proyecto que requiera comprensión avanzada del lenguaje y capacidades de autocorrección.

Puede utilizar la API para tareas como procesamiento de lenguaje natural (PLN), asistentes de escritura para corrección de errores, generación de contenido o bots de atención al cliente.

Uso en el asistente de escritura con inteligencia artificial de HyperWrite

Reflection 70B se está integrando en la herramienta principal de asistencia de escritura con inteligencia artificial de HyperWrite. Una vez que esté completamente integrado, los usuarios podrán aprovechar sus capacidades de autocorrección directamente en HyperWrite para mejorar la generación de contenido, incluidos correos electrónicos, ensayos y resúmenes.

Matricularse en La plataforma de HyperWritey comience a usar el asistente de escritura con inteligencia artificial. Una vez que se complete la integración, notará una mejora en el razonamiento y la corrección de errores en el contenido generado por el asistente.

¿Reflection 70B no funciona?

¿Por qué utilizar HyperWrite Reflection 70B?

La función de autocorrección de errores del Reflection 70B lo hace especialmente útil para tareas en las que la precisión y el razonamiento son fundamentales. Algunas posibles aplicaciones incluyen:

- Investigación científica y redacción técnica:La capacidad de razonamiento y autocorrección del Reflection 70B lo convierte en una herramienta ideal para redactar documentos técnicos, donde la precisión es primordial.

- Redacción y análisis de documentos jurídicos:El enfoque estructurado del modelo para el razonamiento y las correcciones le permite manejar textos legales complejos con un mayor grado de confiabilidad.

- Asistencia de codificación:Como lo demuestra su desempeño en el benchmark HumanEval, Reflection 70B se puede utilizar como asistente de codificación, corrigiendo errores en la generación de código que otros modelos podrían pasar por alto.

Además, su razonamiento paso a paso y la transparencia en el proceso de toma de decisiones son útiles en cualquier aplicación que requiera modelos de IA basados en explicaciones.

La Reflexión 405B está en camino

El lanzamiento de Reflection 70B es solo el comienzo. HyperWrite ha anunciado planes para lanzar un modelo aún más potente: Reflection 405B. Se espera que este modelo más grande, con 405 mil millones de parámetros, establezca nuevos puntos de referencia tanto para los LLM de código abierto como para los comerciales, superando potencialmente incluso a los modelos propietarios como el GPT-4 de OpenAI.

Crédito de la imagen destacada: Eray Eliaçik/Bing