Microsoft encontró su manera de competir con NVIDIAel acelerador de IA Maia 100. Este nuevo chip representa un movimiento estratégico para desafiar El dominio de NVIDIA en el sector del hardware de IA al ofrecer capacidades avanzadas diseñadas para computación en la nube de alto rendimiento. Con Maia 100, Microsoft pretende proporcionar una solución más rentable y eficiente para gestionar cargas de trabajo de IA a gran escala.

Todo lo que sabemos hasta ahora sobre Maia 100 de Microsoft

Maia 100 de Microsoft es un nuevo y potente acelerador de IA diseñado para gestionar grandes tareas de IA en la nube. Presentado en Patatas fritas calientes 2024, Este chip es un gran paso adelante para hacer que la infraestructura de IA sea más rentable, y aquí explicamos cómo:

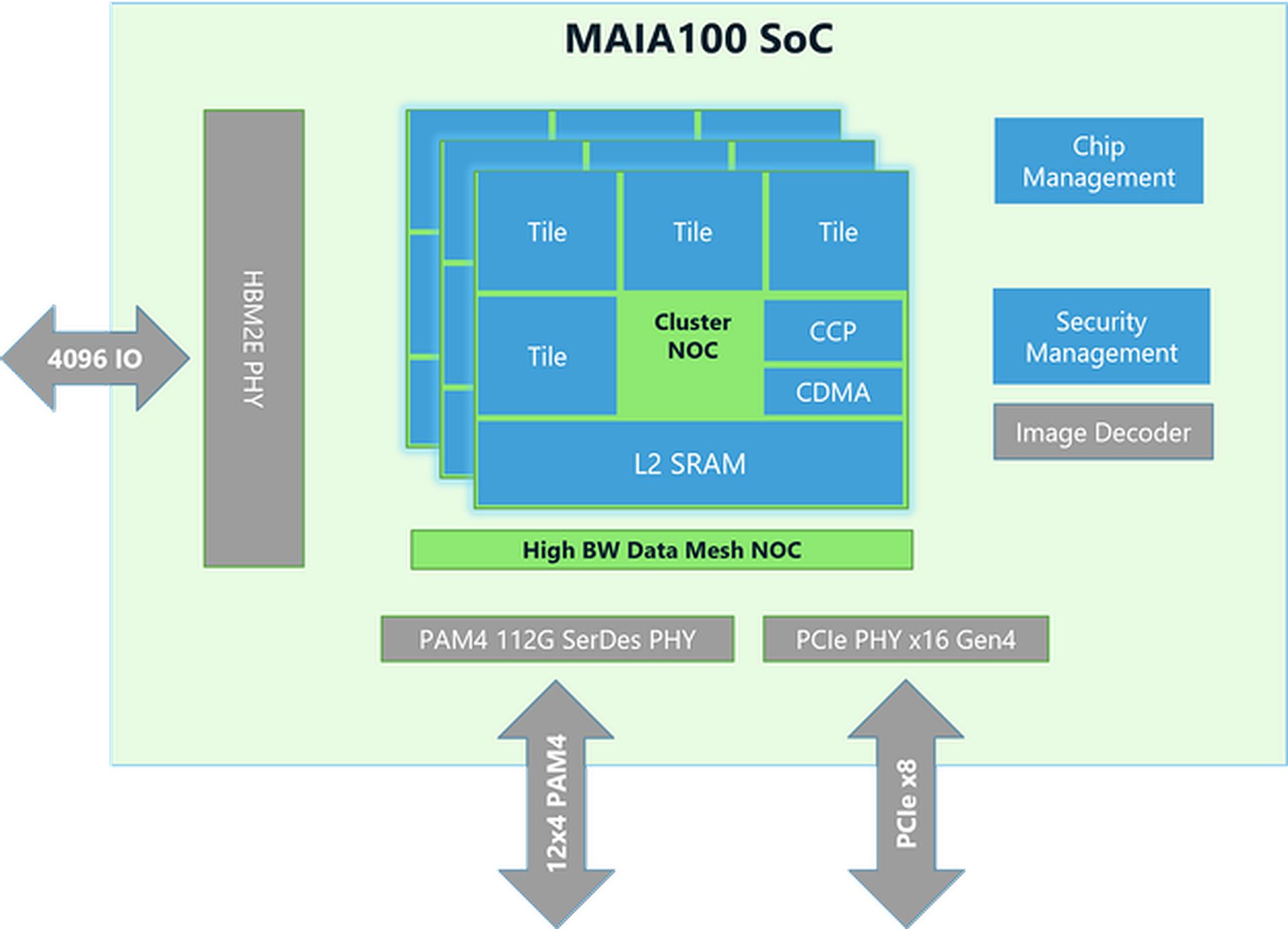

Diseño y tecnología de chips

- Tamaño y fabricación:El chip Maia 100 tiene un tamaño de aproximadamente 820 mm² y está fabricado con la tecnología avanzada N5 de TSMC. Utiliza la tecnología COWOS-S, que ayuda a integrar el chip con otros componentes de manera eficaz.

- Memoria y ancho de banda:El chip tiene mucha memoria y puede manejar una enorme cantidad de datos. Tiene una gran memoria SRAM integrada (un tipo de memoria rápida) y cuatro chips de memoria HBM2E. Juntos, proporcionan una velocidad de transferencia de datos de 1,8 terabytes por segundo y 64 gigabytes de capacidad de memoria. Esta configuración es crucial para procesar grandes conjuntos de datos de IA rápidamente.

Rendimiento y eficiencia energética

- Consumo de energía:Maia 100 puede manejar hasta 700 vatios de potencia, pero está configurado para utilizar 500 vatios para lograr una mayor eficiencia. Esto le permite tener un buen rendimiento y al mismo tiempo mantener el consumo de energía bajo control.

- Unidad tensora:El chip incluye una unidad tensora de alta velocidad para manejar tareas complejas de IA, como entrenar modelos y hacer predicciones. Puede procesar diferentes tipos de datos, incluido un nuevo formato llamado MX, que Microsoft presentó en 2023. Esta unidad está diseñada para manejar muchos cálculos a la vez de manera eficiente.

- Procesador vectorial:Maia 100 tiene un procesador vectorial que admite varios tipos de datos, como FP32 (coma flotante de 32 bits) y BF16 (coma flotante de 16 bits). Esto ayuda a realizar una amplia gama de tareas de aprendizaje automático.

- Motor DMAEl motor de acceso directo a memoria (DMA) ayuda a mover datos rápidamente y admite diferentes formas de dividir tensores (fragmentos de datos), lo que mejora la eficiencia.

Manejo y eficiencia de datos

- Almacenamiento y compresión de datos:Maia 100 utiliza un almacenamiento de datos de menor precisión y un motor de compresión para reducir la cantidad de datos que se deben mover. Esto ayuda a gestionar tareas de IA de gran tamaño de manera más eficiente.

- Blocs de notas:Tiene grandes áreas de almacenamiento temporal L1 y L2 administradas por software para garantizar que los datos se utilicen de manera eficiente y se ahorre energía.

- Redes:El chip admite conexiones Ethernet de alta velocidad, lo que le permite manejar hasta 4800 Gbps de datos en ciertas formas y 1200 Gbps en otras. Este protocolo de red personalizado garantiza una transferencia de datos rápida y confiable, que también es segura con el cifrado AES-GCM.

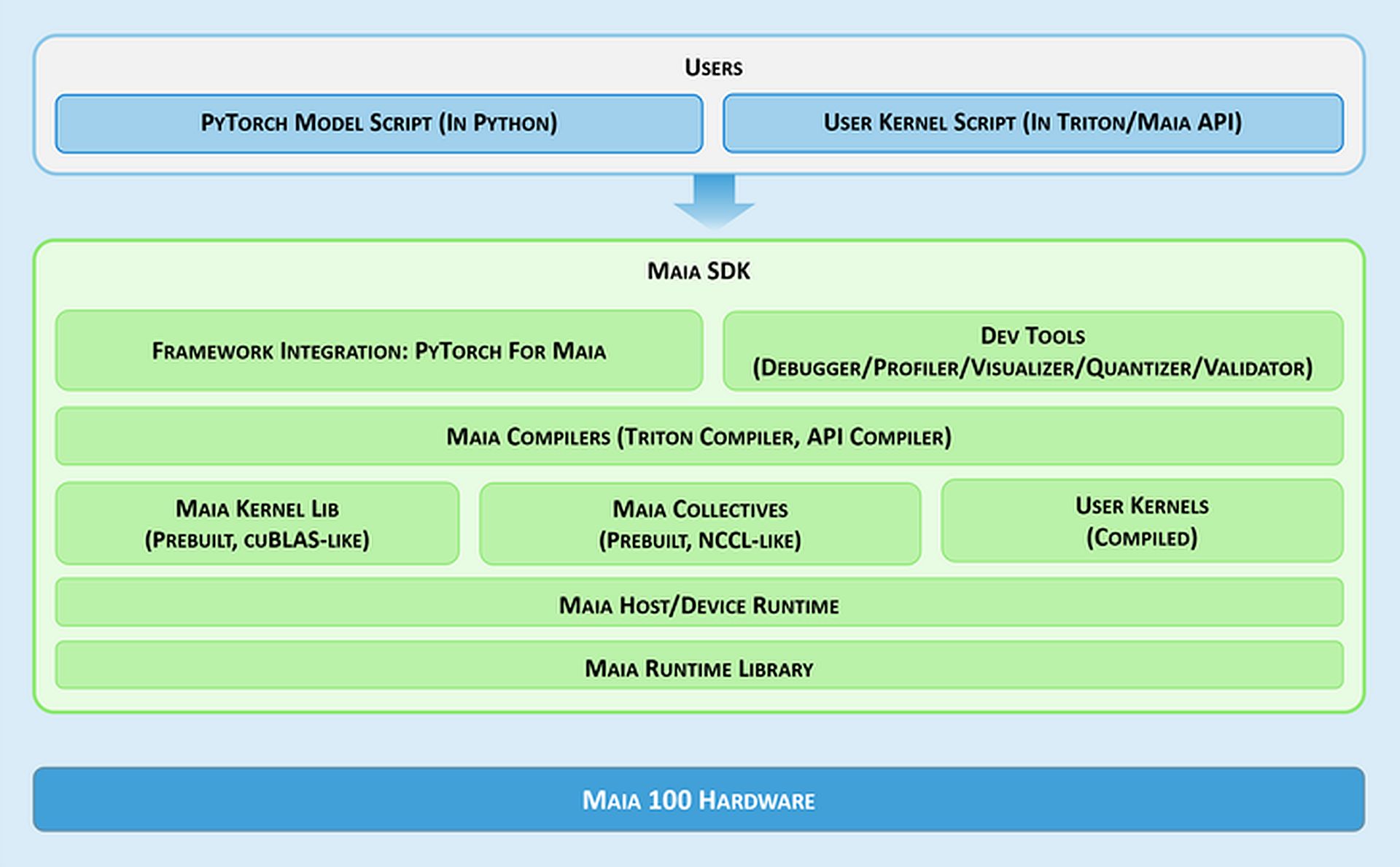

Herramientas de software e integración

- SDK de Maia:Microsoft proporciona un conjunto de herramientas llamado Maia SDK para facilitar el uso de Maia 100. Estas herramientas incluyen:

- Integración del marco:Un backend de PyTorch que admite tanto el modo ansioso (para un desarrollo rápido) como el modo gráfico (para un mejor rendimiento).

- Herramientas para desarrolladores:Herramientas para depurar, ajustar el rendimiento y validar modelos, que ayudan a mejorar la eficiencia de las tareas de IA.

- Compiladores:Maia admite dos modelos de programación: Triton, un lenguaje fácil de usar para aprendizaje profundo, y la API de Maia, un modelo personalizado para alto rendimiento.

- Kernel y biblioteca colectiva:Proporciona núcleos de comunicación y computación optimizados para el aprendizaje automático, con opciones para crear núcleos personalizados.

- Tiempo de ejecución del host/dispositivo:Administra la asignación de memoria, la ejecución de programas, la programación de tareas y la administración de dispositivos.

Modelos de programación y manejo de datos

- Programación asincrónica:Maia admite la programación asincrónica con semáforos, lo que ayuda a superponer los cálculos con las transferencias de datos para mejorar la eficiencia.

- Modelos de programación:Los desarrolladores pueden elegir entre:

- Tritón:Un plan de medición simple para aprendizaje profundo que funciona tanto en GPU como en Maia. Maneja la memoria y la sincronización automáticamente.

- API de Maia:Un modelo de programación más detallado para aquellos que necesitan un control preciso sobre el rendimiento, requiriendo más código y gestión.

- Optimización del flujo de datos:Maia utiliza un método basado en Gather para la multiplicación de matrices (GEMM) en lugar del método All-Reduce tradicional. Esto hace que el procesamiento sea más rápido al combinar los resultados directamente en SRAM (memoria rápida), lo que reduce la latencia y mejora el rendimiento.

- Uso de SRAM:El chip utiliza SRAM para almacenar temporalmente datos y resultados, lo que reduce la necesidad de accesos más lentos a la memoria y mejora el rendimiento general.

Flexibilidad y portabilidad

Maia 100 puede ejecutar modelos de PyTorch con cambios mínimos. El backend de PyTorch admite tanto el desarrollo (modo Eager) como el alto rendimiento (modo gráfico), lo que facilita el traslado de modelos entre diferentes configuraciones de hardware.

¿Necesitas un resumen de las especificaciones del Maia 100?

| Especificación | Detalles |

| Tamaño del chip | ~820 mm² |

| Tecnología de fabricación | Proceso TSMC N5 con intercalador COWOS-S |

| SRAM integrada | Gran capacidad para un acceso rápido a los datos. |

| Memoria | 64 GB HBM2E (memoria de gran ancho de banda) |

| Ancho de banda total | 1,8 terabytes por segundo |

| Potencia de diseño térmico (TDP) | Admite hasta 700 W, aprovisionado a 500 W |

| Unidad tensorial | Alta velocidad, compatible con formato MX, 16xRx16 |

| Procesador vectorial | Motor superescalar personalizado, compatible con FP32 y BF16 |

| Motor DMA | Admite varios esquemas de fragmentación de tensores |

| Compresión de datos | Incluye motor de compresión para mayor eficiencia. |

| Ancho de banda de Ethernet | Hasta 4800 Gbps en modo de recopilación total, 1200 Gbps en modo de conexión total |

| Protocolo de red | Cifrado AES-GCM personalizado, similar a RoCE |

| Modelos de programación | Triton (lenguaje específico del dominio), API Maia (modelo personalizado) |

| Blocs de notas | Grandes L1 y L2, gestionados por software |

| Uso de SRAM | Para almacenar en búfer activaciones y resultados |

| Kit de desarrollo de software | Incluye backend de PyTorch, herramientas de depuración, compiladores y gestión del tiempo de ejecución. |

| Optimización del flujo de datos | Multiplicación de matrices basada en recopilación (GEMM) |

¡Eso es todo! En resumen, el acelerador de IA Maia 100 de Microsoft se posiciona como un competidor directo de las ofertas de NVIDIA en el mercado de hardware de IA. Con su arquitectura avanzada y sus características de rendimiento, Maia 100 busca brindar una alternativa viable para manejar tareas de IA a gran escala.

Crédito de la imagen destacada: Microsoft