Colossus es un innovador sistema de entrenamiento de inteligencia artificial (IA) desarrollado por Elon Musk. Corporación xAIEsta supercomputadora, descrita por Musk como la “El sistema de entrenamiento de IA más potente del mundo”, es un componente fundamental de la estrategia de xAI para liderar en el campo de la IA, que avanza rápidamente.

Este fin de semana, el @xAI El equipo puso en marcha nuestro grupo de capacitación Colossus 100k H100. De principio a fin, se realizó en 122 días.

Colossus es el sistema de entrenamiento de IA más potente del mundo. Además, duplicará su tamaño hasta alcanzar los 200.000 (50.000 H200) en unos meses.

Excelente…

— Elon Musk (@elonmusk) 2 de septiembre de 2024

Nvidia impulsará el Colossus

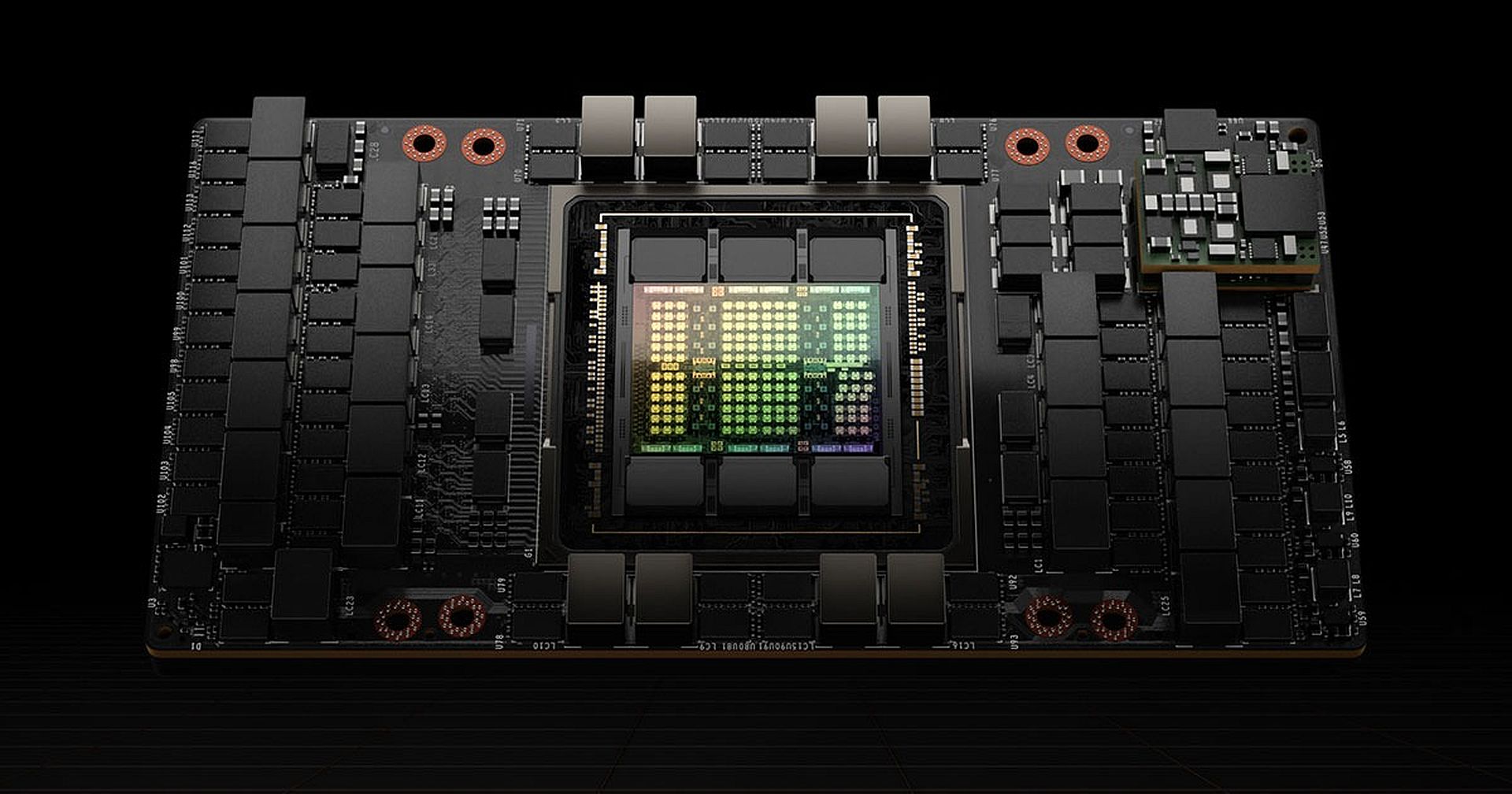

En el núcleo de Colossus se encuentran 100.000 Tarjetas gráficas NVIDIA H100. Estas GPU (unidades de procesamiento de gráficos) están diseñadas específicamente para manejar los exigentes requisitos computacionales del entrenamiento de IA y aquí explicamos por qué estas GPU son tan vitales:

- Potencia de procesamiento en bruto: El H100 es el procesador de IA insignia de Nvidia, diseñado para acelerar el entrenamiento y la inferencia de modelos de IA, en particular los basados en aprendizaje profundo y redes neuronales. En comparación con su predecesor, el H100 puede ejecutar modelos de lenguaje hasta 30 veces más rápido.

- Motor transformador:Una característica clave del H100 es su motor Transformer, un conjunto especializado de circuitos optimizados para ejecutar modelos de IA basados en la arquitectura de red neuronal Transformer. Esta arquitectura es la columna vertebral de algunos de los modelos de lenguaje más avanzados, como GPT-4 y Llama de Meta 3.1 405BEl motor Transformer permite que estas GPU manejen modelos a gran escala de manera más eficiente, lo que las hace ideales para entrenar sistemas de IA sofisticados.

El siguiente nivel: duplicar la apuesta con el H200

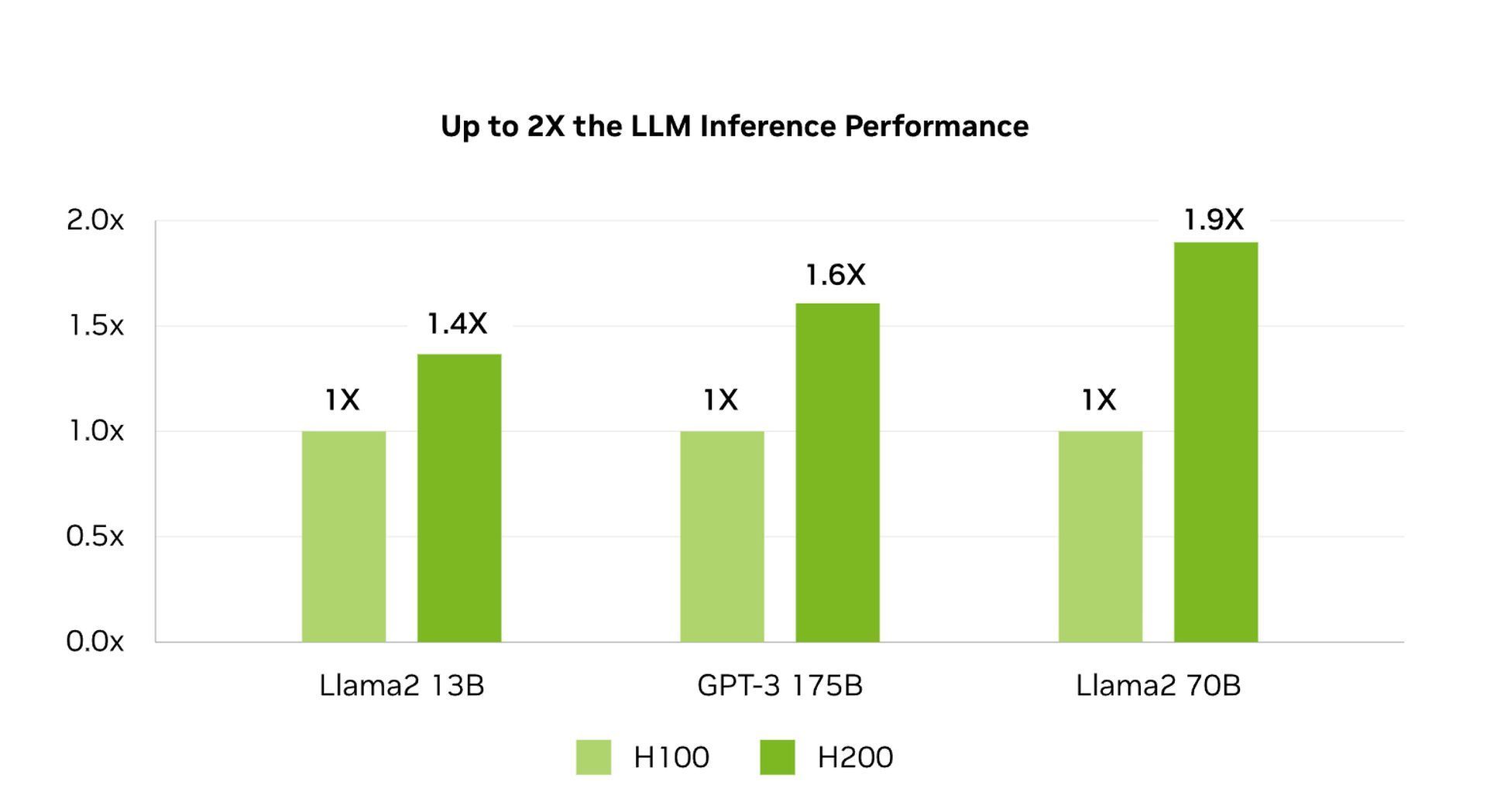

Musk tiene planes ambiciosos para expandir aún más Colossus, con el objetivo de duplicar la cantidad de GPU del sistema. 200.000 En un futuro próximo, esta ampliación incluirá 50.000 unidades de H200 de Nvidiaun sucesor aún más potente del H100. El H200 ofrece varias mejoras importantes:

- Memoria HBM3e:El H200 utiliza memoria de alto ancho de banda 3e (HBM3e), que es más rápida que la HBM3 utilizada en el H100. Este tipo de memoria mejora la velocidad a la que se transfieren los datos entre la memoria y los circuitos lógicos del chip. Para los modelos de IA, que constantemente mezclan grandes cantidades de datos entre el procesamiento y la memoria, esta velocidad es crucial.

- Mayor capacidad de memoria:El H200 casi duplica la capacidad de memoria integrada. 141 gigabytesEsto permite que la GPU almacene más datos de un modelo de IA más cerca de sus circuitos lógicos, lo que reduce la necesidad de obtener datos de fuentes de almacenamiento más lentas. El resultado son tiempos de procesamiento más rápidos y un entrenamiento del modelo más eficiente.

El papel de Colossus en el entrenamiento de la IA

Colossus está diseñado específicamente para entrenar modelos de lenguaje grandes (LLM)que son la base de las aplicaciones avanzadas de IA.

La gran cantidad de GPU en Colossus permite a xAI entrenar modelos de IA a una escala y velocidad que otros sistemas no pueden igualar. Por ejemplo, el sistema insignia actual de xAI, LLM, Grok-2, Se entrenó en 15 000 GPU. Con 100 000 GPU disponibles ahora, xAI puede entrenar modelos mucho más grandes y complejos, lo que potencialmente conduce a mejoras significativas en las capacidades de IA.

La arquitectura avanzada de las GPU H100 y H200 garantiza que los modelos se entrenen no solo más rápido, sino también con mayor precisión. La gran capacidad de memoria y las capacidades de transferencia rápida de datos significan que incluso los modelos de IA más complejos se pueden entrenar de manera más eficiente, lo que da como resultado un mejor rendimiento y precisión.

¿Que sigue?

Colossus no es solo un logro técnico, es un activo estratégico en la misión de xAI de dominar la industria de la IA. Al construir el sistema de entrenamiento de IA más poderoso del mundo, xAI se posiciona como líder en el desarrollo de modelos de IA de vanguardia. Este sistema le da a xAI una ventaja competitiva sobre otras empresas de IA, incluida OpenAI, en la que Musk está actualmente. conflicto legal con.

Además, la construcción de Colossus refleja la visión más amplia de Musk para la IA. Al reasignar recursos de Tesla a xAI, incluida la redirección de 12.000 GPU H100 valoradas en más de 500 millones de dólares, Musk demuestra su compromiso con la IA como eje central de su imperio empresarial.

¿Podrá lograrlo? ¡Tenemos que esperar la respuesta!

Crédito de la imagen destacada: Eray Eliaçik/Adivinanza