Un nuevo modelo de IA llamado VASA-1 promete transformar tus fotos en videos y darles voz. Esta apasionante tecnología de Microsoft utiliza una única fotografía de retrato y un archivo de audio para crear un vídeo de caras parlantes con sincronización de labios, expresiones faciales y movimientos de cabeza realistas.

El poder de VASA-1

Las capacidades de VASA-1 radican en su capacidad para generar animaciones faciales realistas. A diferencia de sus predecesores, VASA-1 minimiza los errores alrededor de la boca, un signo común de los deepfakes. Además, cuenta con un realismo de alta calidad a través de su comprensión matizada de las expresiones faciales y los movimientos naturales de la cabeza.

Vídeos de demostración publicados por Microsoft en un entrada en el blog muestre los impresionantes resultados, desdibujando las líneas entre la realidad y el contenido generado por IA.

¿Dónde podría brillar VASA-1? Bien,

- ga mejoradoExperiencias Ming: Imagina personajes del juego con movimientos de labios perfectamente sincronizados y rostros expresivos, creando una experiencia de juego más inmersiva y atractiva.

- Avatares virtuales personalizados: VASA-1 podría cambiar las redes sociales al permitir a los usuarios crear avatares hiperrealistas que se mueven y hablan como ellos.

- Cine impulsado por IA: Los cineastas podrían utilizar VASA-1 para generar primeros planos realistas, expresiones faciales intrincadas y secuencias de diálogo naturales, superando los límites de los efectos especiales.

¿Cómo funciona VASA-1?

VASA-1 aborda el desafío de generar videos realistas de caras parlantes a partir de una sola imagen y un clip de audio. Profundicemos en los aspectos técnicos de cómo logra esta notable hazaña.

Imagine una foto de alguien y una grabación de audio de otra persona hablando. VASA-1 pretende combinar estos elementos para crear un vídeo donde la persona de la foto parece estar diciendo las palabras del audio. Este vídeo debe ser realista en varios aspectos clave:

- Claridad y autenticidad de la imagen: Los fotogramas de vídeo generados deben parecerse a imágenes reales y no mostrar ningún artefacto de aspecto artificial.

- Precisión de sincronización de labios: Los movimientos de los labios en el vídeo deben sincronizarse perfectamente con el audio.

- Expresiones faciales: La cara generada debe mostrar emociones y expresiones apropiadas para coincidir con el contenido hablado.

- Movimientos naturales de la cabeza: Los movimientos sutiles de la cabeza deberían realzar el realismo de la cara que habla.

VASA-1 también puede aceptar controles adicionales para adaptar la salida, como la dirección de la mirada principal, la distancia entre la cabeza y la cámara y una compensación de emoción general.

Marco general

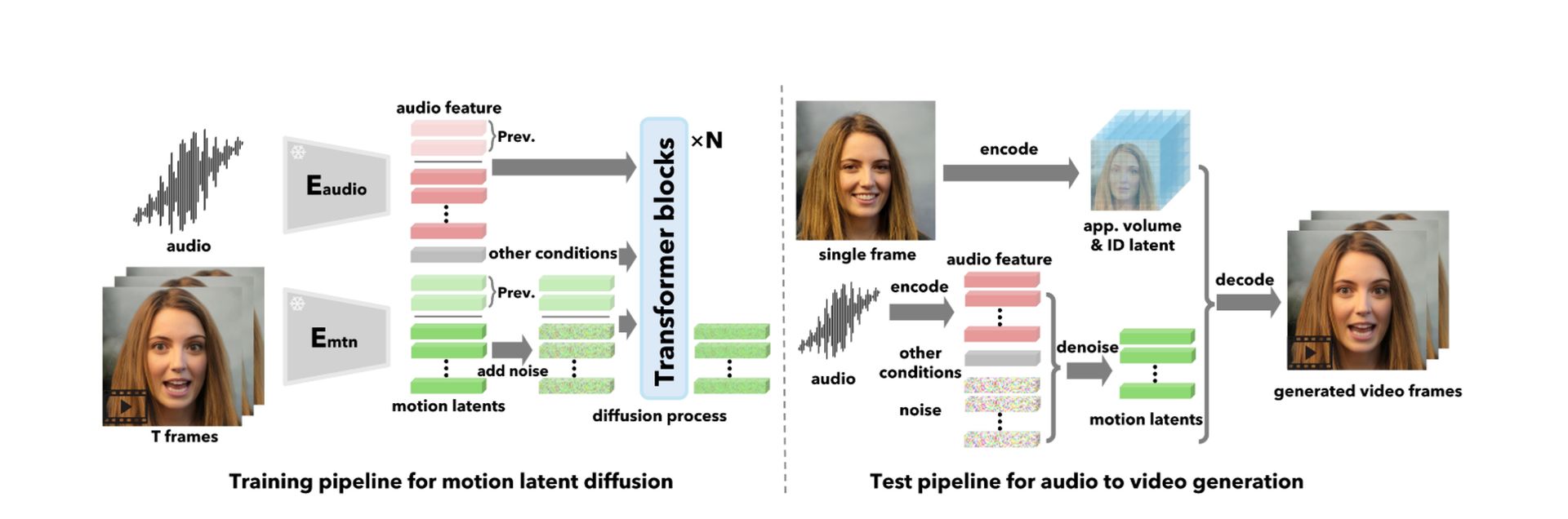

En lugar de generar fotogramas de vídeo directamente, VASA-1 funciona en dos etapas:

Generación de movimiento y pose: Crea una secuencia de códigos que representan la dinámica facial (movimientos de labios, expresiones) y movimientos de la cabeza (pose) condicionados al audio y otras señales de entrada.

Generación de fotogramas de vídeo: estos códigos de movimiento y pose se utilizan para generar los fotogramas de vídeo reales, teniendo en cuenta la apariencia y la información de identidad extraída de la imagen de entrada.

Desglose técnico

Aquí hay un desglose de los componentes principales de VASA-1:

1. Construcción del espacio latente del rostro expresivo y desenredado

VASA-1 comienza construyendo un tipo especial de espacio digital llamado «espacio latente» diseñado específicamente para representar rostros humanos. Este espacio tiene dos propiedades clave:

- expresividad: Puede capturar toda la gama de expresiones y movimientos faciales humanos con gran detalle.

- Desenredo: En este espacio se representan por separado diferentes aspectos del rostro, como la identidad, la postura de la cabeza y la dinámica facial. Esto permite un control independiente sobre estos aspectos durante la generación de vídeo.

VASA-1 logra esto basándose en técnicas de recreación de rostros en 3D existentes. Descompone una imagen de rostro en varios componentes:

- Volumen de apariencia 3D (Vapp): Esto captura la forma y textura detalladas en 3D del rostro.

- Código de identidad (z_id): Esto representa las características únicas de la persona en la imagen.

- Código de postura de la cabeza (z_pose): Codifica la orientación e inclinación de la cabeza.

- Código de dinámica facial (z_dyn): Esto captura las expresiones y movimientos faciales actuales.

Para garantizar un desenredo adecuado, VASA-1 emplea funciones de pérdida especializadas durante el entrenamiento. Estas funciones penalizan al modelo si mezcla diferentes aspectos de la representación del rostro.

2. Generación de dinámica facial holística con transformador de difusión.

Una vez que VASA-1 tiene un espacio latente bien entrenado, necesita una forma de generar el movimiento y los códigos de pose para una secuencia de caras parlantes basada en un clip de audio. Aquí es donde entra en juego el “Transformador de Difusión”.

- Modelo de difusión: VASA-1 aprovecha un modelo de difusión, un tipo de arquitectura de aprendizaje profundo, para lograrlo. Los modelos de difusión funcionan agregando ruido gradualmente a una señal limpia y luego aprendiendo a revertir este proceso. En el caso de VASA-1, la señal limpia es la secuencia de movimiento y pose deseada, y la señal ruidosa es un punto de partida aleatorio. Básicamente, el modelo de difusión aprende a «eliminar el ruido» en su camino de regreso a la secuencia de movimiento limpio en función de las funciones de audio proporcionadas.

- Arquitectura del transformador: VASA-1 utiliza un tipo específico de modelo de difusión llamado «transformador». Los transformadores destacan en tareas de aprendizaje de secuencia a secuencia, lo que los hace muy adecuados para generar una secuencia de movimiento y códigos de pose correspondientes a la secuencia de audio.

VASA-1 acondiciona el transformador de difusión en varias entradas:

- Funciones de audio: Extraídas del clip de audio, estas características representan el contenido de audio e informan al modelo sobre los movimientos y emociones de los labios previstos.

- Señales de control adicionales: Estas señales opcionales permiten un mayor control sobre el vídeo generado. Incluyen:

- Dirección principal de la mirada (g): Esto especifica hacia dónde mira la cara generada.

- Distancia entre la cabeza y la cámara (d): Esto controla el tamaño aparente de la cara en el video.

- Compensación de emociones (e): Esto se puede utilizar para alterar ligeramente la expresión emocional general que muestra el rostro.

3. Generación de videos de caras parlantes

Con los códigos de movimiento y pose generados, VASA-1 finalmente puede crear los fotogramas de vídeo. Lo hace mediante:

- Red decodificadora: Esta red toma el movimiento y plantea códigos junto con la información de apariencia e identidad extraída de la imagen de entrada como entrada. Luego utiliza esta información para sintetizar fotogramas de vídeo realistas que representan a la persona en la imagen realizando los movimientos faciales y las expresiones correspondientes al audio.

- Guía sin clasificador (CFG): VASA-1 incorpora una técnica denominada Classifier-free Guidance (CFG) para mejorar la robustez y controlabilidad del proceso de generación. CFG implica eliminar aleatoriamente algunas de las condiciones de entrada durante el entrenamiento.

Esto obliga al modelo a aprender a generar buenos resultados incluso cuando no toda la información está disponible. Por ejemplo, es posible que el modelo necesite generar el comienzo del vídeo sin ningún audio o información de movimiento anterior.

Ver más explicación en el trabajo de investigación aquí.

La sombra inminente de los deepfakes

falsificaciones profundasLos vídeos altamente realistas generados por IA que manipulan la apariencia y la voz de las personas se han convertido en una fuente de preocupación creciente. Los actores malintencionados pueden utilizarlos para difundir información errónea, dañar reputaciones e incluso influir en las elecciones. La naturaleza hiperrealista de VASA-1 intensifica estas ansiedades.

Aquí radica la El quid del futuro incierto de VASA-1.

La decisión de Microsoft de restringir el acceso, manteniéndolo alejado tanto del público como de algunos investigadores, sugiere un enfoque cauteloso. Los peligros potenciales de los deepfakes requieren una cuidadosa consideración antes de lanzar una tecnología tan poderosa.

Equilibrando la innovación con la responsabilidad

En el futuro, Microsoft enfrenta un desafío crítico: equilibrar la innovación con el desarrollo responsable. Quizás el camino a seguir esté en entornos de investigación controlados con sólidas salvaguardias contra el uso indebido. Además, fomentar la educación pública y la concientización sobre los deepfakes puede permitir a los usuarios distinguir el contenido genuino del manipulado por IA.

Sin lugar a dudas, VASA-1 representa un salto significativo en la capacidad de la IA para manipular medios visuales. Sus aplicaciones potenciales son nada menos que revolucionarias.

Sin embargo, las consideraciones éticas que rodean a los deepfakes requieren un enfoque mesurado. Sólo a través del desarrollo responsable y la educación pública podemos desbloquear el verdadero potencial de VASA-1 y al mismo tiempo mitigar el potencial de daño.

Crédito de imagen destacada: microsoft