Los modelos de lenguajes grandes (LLM) han demostrado habilidades notables: pueden conversar, generar formatos de texto creativos y mucho más. Sin embargo, cuando se les pide que proporcionen respuestas fácticas detalladas a preguntas abiertas, aún pueden quedarse cortos. Los LLM pueden proporcionar información que parezca plausible pero incorrecta, lo que deja a los usuarios con el desafío de separar la realidad de la ficción.

Google DeepMind, la empresa líder en investigación de IA, está abordando este problema de frente. Su artículo reciente, “Factitud de formato largo en modelos de lenguaje grandes” introduce innovaciones tanto en la forma en que medimos la precisión de los hechos como en cómo podemos mejorarla en los LLM.

LongFact: un punto de referencia para la precisión fáctica

DeepMind comenzó abordando la falta de un método sólido para probar la factualidad en formato largo. Crearon LongFact, un conjunto de datos de más de 2000 desafiantes indicaciones de búsqueda de hechos que exigen respuestas detalladas de varios párrafos. Estas indicaciones cubren una amplia gama de temas para probar el LLMLa capacidad de producir textos factuales en diversas áreas temáticas.

SEGURO: Evaluación de factibilidad aumentada por búsqueda

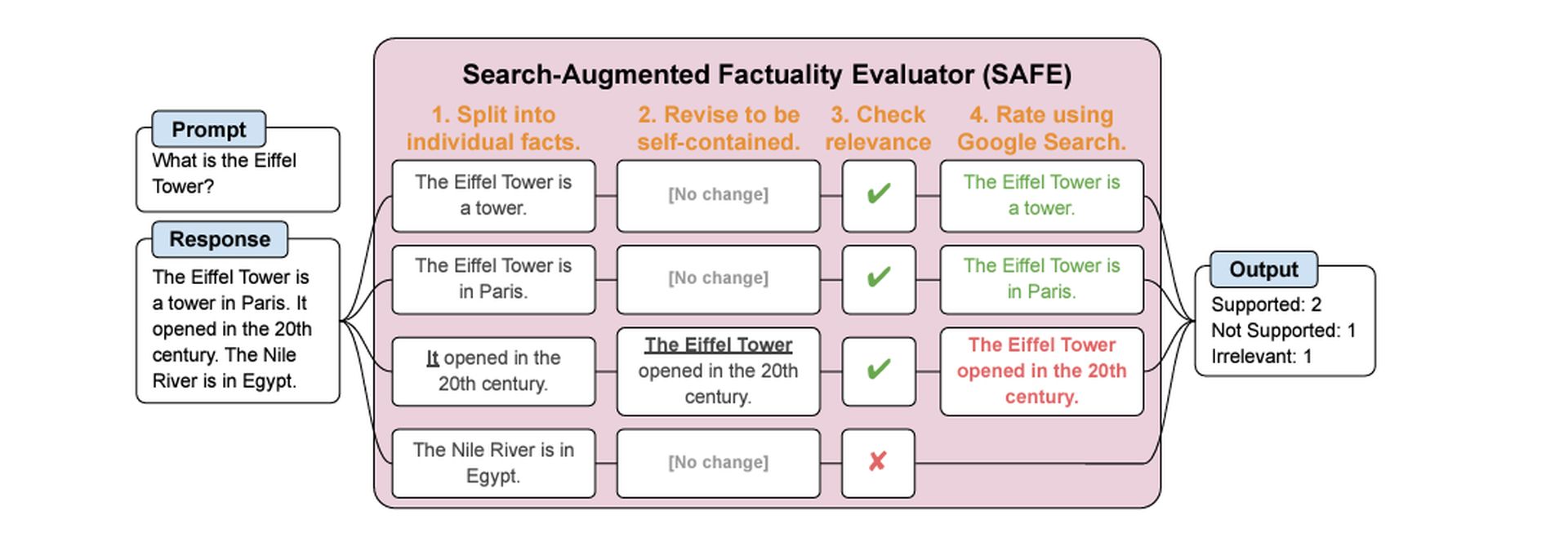

El siguiente desafío fue determinar cómo evaluar con precisión las respuestas del LLM. DeepMind desarrolló el Evaluador de factualidad aumentada por búsqueda (SEGURO). Aquí está lo inteligente: ¡el propio SAFE utiliza un LLM para realizar esta evaluación!

Así es como funciona:

- Descomponerlo: SAFE analiza una respuesta de LLM de formato largo en declaraciones fácticas individuales más pequeñas.

- Busca y verifica: Para cada declaración objetiva, SAFE elabora consultas de búsqueda y las envía a la Búsqueda de Google.

- Haz la llamada: SAFE analiza los resultados de la búsqueda y los compara con la declaración fáctica, determinando si la declaración está respaldada por la evidencia en línea.

F1@K: una nueva métrica para respuestas largas

Mente profunda También propuso una nueva forma de calificar respuestas fácticas extensas. La puntuación F1 tradicional (utilizada para tareas de clasificación) no fue diseñada para manejar textos más largos y complejos. F1@K equilibra la precisión (el porcentaje de datos proporcionados que son correctos) con un concepto llamado recuperación.

La recuperación tiene en cuenta la duración ideal de la respuesta de un usuario; después de todo, un LLM podría obtener una alta precisión al proporcionar un único hecho correcto, mientras que una respuesta detallada obtendría una puntuación más baja.

LLM más grandes, mejores datos

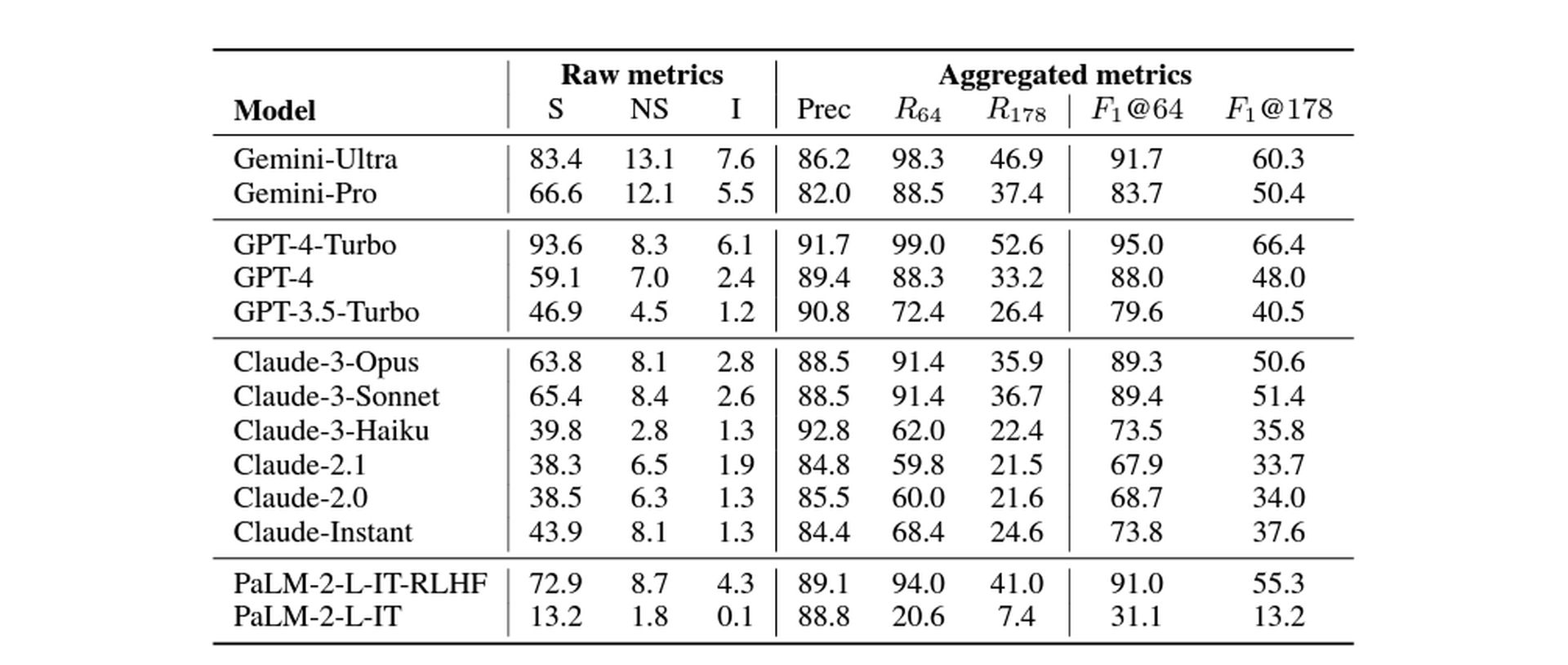

DeepMind comparó una variedad de modelos de idiomas grandes de diferentes tamaños, y sus hallazgos se alinearon con la intuición de que los modelos más grandes tienden a demostrar una mayor precisión fáctica en formato largo. Esto puede explicarse por el hecho de que los modelos más grandes se entrenan con conjuntos de datos masivos de texto y código, lo que les confiere una comprensión más rica y completa del mundo.

Imagine un LLM como un estudiante que ha estudiado una vasta biblioteca de libros. Cuantos más libros haya leído el estudiante, más probabilidades habrá de que haya encontrado y retenido información objetiva sobre una amplia gama de temas. De manera similar, un LLM más grande con su exposición más amplia a la información está mejor equipado para generar texto con fundamento en hechos.

Para realizar esta medición, Google DeepMind probó los siguientes modelos: Geminis, GPT, claudio (versiones 3 y 2), y Palmera. Los resultados son los siguientes:

La conclusión: optimismo cauteloso

El estudio de DeepMind muestra un camino prometedor hacia los LLM que pueden ofrecer información objetiva más confiable. SAFE alcanzó niveles de precisión que superaron a los evaluadores humanos en ciertas pruebas.

Sin embargo, es crucial tener en cuenta las limitaciones:

-

Dependencia del motor de búsqueda: La precisión de SAFE depende de la calidad de los resultados de la búsqueda y de la capacidad del LLM para interpretarlos.

-

Hechos no repetidos: La métrica F1@K supone que una respuesta ideal no contendrá información repetitiva.

A pesar de las posibles limitaciones, es innegable que este trabajo avanza en el desarrollo de sistemas de inteligencia artificial veraces. A medida que los LLM continúan evolucionando, su capacidad para transmitir hechos con precisión podría tener un impacto profundo en la forma en que usamos estos modelos para encontrar información y comprender temas complejos.

Crédito de imagen destacada: Freepik