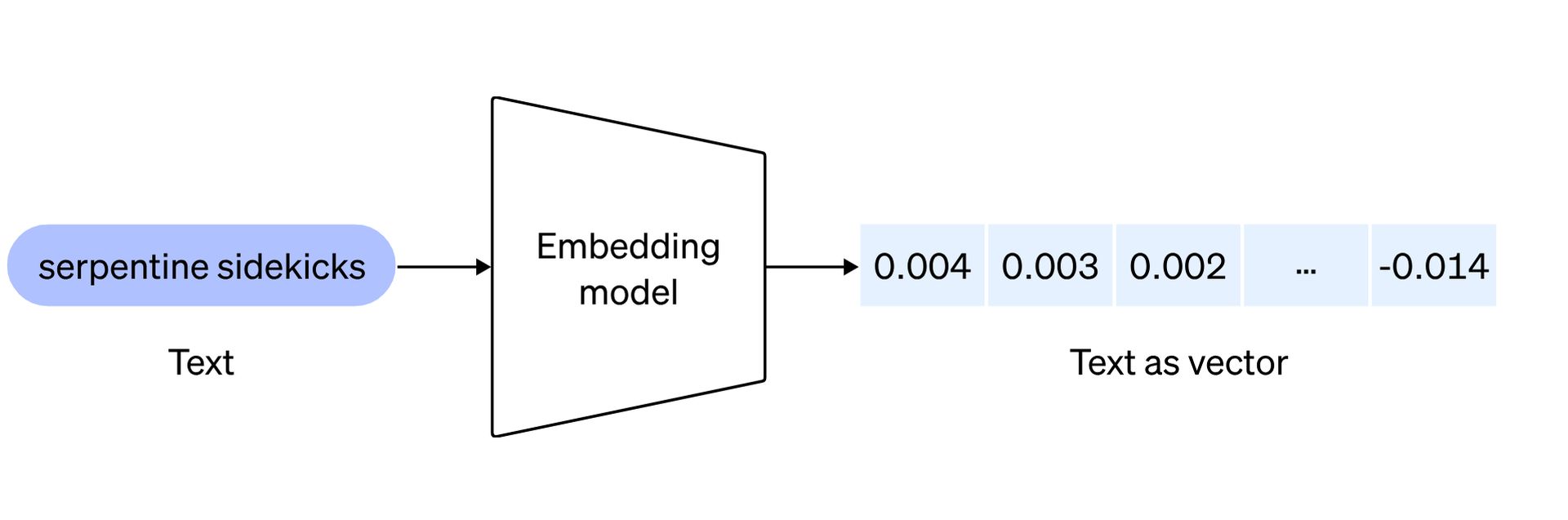

El ámbito de la inteligencia artificial continúa evolucionando con nuevos modelos de integración de OpenAI. Están destinados a redefinir la forma en que los desarrolladores abordan el procesamiento del lenguaje natural. Antes de explorar los dos modelos innovadores, cada uno diseñado para elevar las capacidades de las aplicaciones de IA, esto es lo que incrustaciones significar:

Las incrustaciones de texto de OpenAI sirven como métrica para medir la correlación entre cadenas de texto, encontrando aplicaciones en varios dominios, que incluyen:

- Buscar: Se utiliza para clasificar los resultados según su relevancia para una cadena de consulta determinada, lo que mejora la precisión de los resultados de la búsqueda.

- Agrupación: Empleado para agrupar cadenas de texto según sus similitudes, facilitando la organización de información relacionada.

- Recomendaciones: Se aplica en sistemas de recomendación para sugerir elementos que comparten puntos en común en sus cadenas de texto, mejorando la personalización de las sugerencias.

- Detección de anomalías: Empleado para identificar valores atípicos con una relación mínima, ayudando en la detección de patrones irregulares o puntos de datos.

- Medición de la diversidad: Se utiliza para analizar distribuciones de similitud, lo que permite evaluar la diversidad dentro de conjuntos de datos o corpus de texto.

- Clasificación: Se implementa en tareas de clasificación donde las cadenas de texto se clasifican según su etiqueta más similar, lo que agiliza el proceso de etiquetado en aplicaciones de aprendizaje automático.

¡Ahora está listo para explorar los nuevos modelos de integración de OpenAI!

Han llegado nuevos modelos de incrustación de OpenAI

La introducción de los nuevos modelos de integración de OpenAI marca un salto significativo en el procesamiento del lenguaje natural, lo que permite a los desarrolladores representar y comprender mejor el contenido textual. Profundicemos en los detalles de estos innovadores modelos: incrustación-de-texto-3-pequeño y incrustación-de-texto-3-grande.

incrustación-de-texto-3-pequeño

Este modelo compacto pero potente muestra una notable mejora en el rendimiento con respecto a su predecesor, text-embedded-ada-002. En el punto de referencia de recuperación multilingüe (MIRACL), la puntuación media se ha disparado del 31,4% a un impresionante 44,0%. De manera similar, en el punto de referencia de tareas de inglés (MTEB), la puntuación promedio ha experimentado un aumento encomiable del 61,0% al 62,3%. Sin embargo, lo que distingue a text-embedded-3-small no es sólo su rendimiento mejorado sino también su asequibilidad.

| Punto de referencia de evaluación | ada v2 | incrustación-de-texto-3-pequeño | incrustación-de-texto-3-grande |

| promedio MIRACL | 31.4 | 44.0 | 54,9 |

| Promedio MTBEB | 61.0 | 62.3 | 64,6 |

OpenAI ha reducido significativamente el precio, haciéndolo 5 veces más rentable en comparación con text-embedded-ada-002, con el precio por 1k tokens reducido de $0,0001 a $0,00002. Esto hace que text-embedding-3-small no solo sea una opción más eficiente sino también más accesible para los desarrolladores.

incrustación-de-texto-3-grande

Text-embedding-3-large, que representa la próxima generación de modelos de incrustación, introduce un aumento sustancial en las dimensiones y admite incrustaciones de hasta 3072 dimensiones. Este modelo más grande proporciona una representación más detallada y matizada del contenido textual. En términos de rendimiento, text-embedding-3-large eclipsa a su predecesor en todos los puntos de referencia. En MIRACL, la puntuación promedio aumentó del 31,4% a un impresionante 54,9%, lo que destaca su destreza en la recuperación en varios idiomas.

| ada v2 | incrustación-de-texto-3-pequeño | incrustación-de-texto-3-grande | ||||

| Tamaño de incrustación | 1536 | 512 | 1536 | 256 | 1024 | 3072 |

| Puntuación media MTEB | 61.0 | 61,6 | 62.3 | 62.0 | 64.1 | 64,6 |

De manera similar, en MTEB, la puntuación promedio aumentó del 61,0% al 64,6%, lo que demuestra su superioridad en las tareas de inglés. Con un precio de 0,00013 dólares por 1.000 tokens, text-embedded-3-large logra un equilibrio entre excelencia en el rendimiento y rentabilidad, ofreciendo a los desarrolladores una solución sólida para aplicaciones que exigen incrustaciones de alta dimensión.

Encontrarse Google Lumière AIprimo creador de videos de Bard

Soporte nativo para acortar incrustaciones

Al reconocer las diversas necesidades de los desarrolladores, OpenAI presenta soporte nativo para acortar las incrustaciones. Esta técnica innovadora permite a los desarrolladores personalizar el tamaño de incrustación ajustando el parámetro API de dimensiones. Al hacerlo, los desarrolladores pueden sacrificar algo de rendimiento por un tamaño de vector más pequeño sin comprometer las propiedades fundamentales de la incrustación. Esta flexibilidad es particularmente valiosa en escenarios donde los sistemas solo admiten incorporaciones de hasta un cierto tamaño, lo que proporciona a los desarrolladores una herramienta versátil para diversos escenarios de uso.

En resumen, los nuevos modelos de integración de OpenAI representan un importante paso adelante en eficiencia, asequibilidad y rendimiento. Ya sea que los desarrolladores opten por la representación compacta pero eficiente de text-embedding-3-small o las incrustaciones más extensas y detalladas de text-embedding-3-large, estos modelos brindan a los desarrolladores herramientas versátiles para extraer información más profunda de los datos textuales en su IA. aplicaciones.

Para obtener información más detallada sobre los nuevos modelos de incrustación de OpenAI, haga clic en aquí y obtenga el anuncio oficial.

Crédito de la imagen destacada: Levart_Fotógrafo/Unsplash