Sin embargo, ha surgido un desarrollo interesante con OpenVoice, una creación colaborativa de equipos del Instituto Tecnológico de Massachusetts (MIT), la Universidad Tsinghua en Beijing y la firma canadiense de inteligencia artificial MyShell. OpenVoice es una plataforma de código abierto para clonación de voz, que se distingue por su rápido procesamiento y opciones avanzadas de personalización, lo que la distingue de las tecnologías de clonación de voz existentes.

Hoy, estamos orgullosos de abrir el código fuente de nuestro algoritmo OpenVoice, adoptando nuestro espíritu central: IA para todos.

Experimentalo ahora: https://t.co/zHJpeVpX3t. Clona voces con una precisión incomparable, con control granular del tono, desde la emoción hasta el acento, el ritmo, las pausas y la entonación, usando solo un… pic.twitter.com/RwmYajpxOt

—Mi concha (@myshell_ai) 2 de enero de 2024

Para mejorar la accesibilidad y la transparencia, la empresa ha compartido un enlace a su página revisada minuciosamente. trabajo de investigación detallando el desarrollo de OpenVoice. Además, han proporcionado puntos de acceso para que los usuarios experimenten con esta tecnología. Estos incluyen la interfaz de la aplicación web MyShell, que requiere el registro del usuario, y AbrazosCaraaccesible al público sin ninguna cuenta.

MyShell se compromete a contribuir a la comunidad de investigación en general y considera a OpenVoice solo el comienzo. De cara al futuro, planean ampliar el apoyo a través de subvenciones, conjuntos de datos y recursos informáticos para impulsar la investigación de código abierto. El principio rector de MyShell es «IA para todos», enfatizando la importancia del lenguaje, la visión y la voz como los tres componentes clave de la futura Inteligencia General Artificial (AGI).

En el ámbito de la investigación, si bien las modalidades de lenguaje y visión han experimentado avances sustanciales en los modelos de código abierto, sigue habiendo una brecha en el sector de la voz. Específicamente, existe la necesidad de un modelo de clonación de voz sólido y con capacidad de respuesta instantánea que ofrezca capacidades de generación de voz personalizables. MyShell pretende llenar este vacío, ampliando los límites de la tecnología de voz en AGI.

Encontrarse Murf AI: Voces en off de texto a voz en segundos

¿Cómo utilizar Myshell AI?

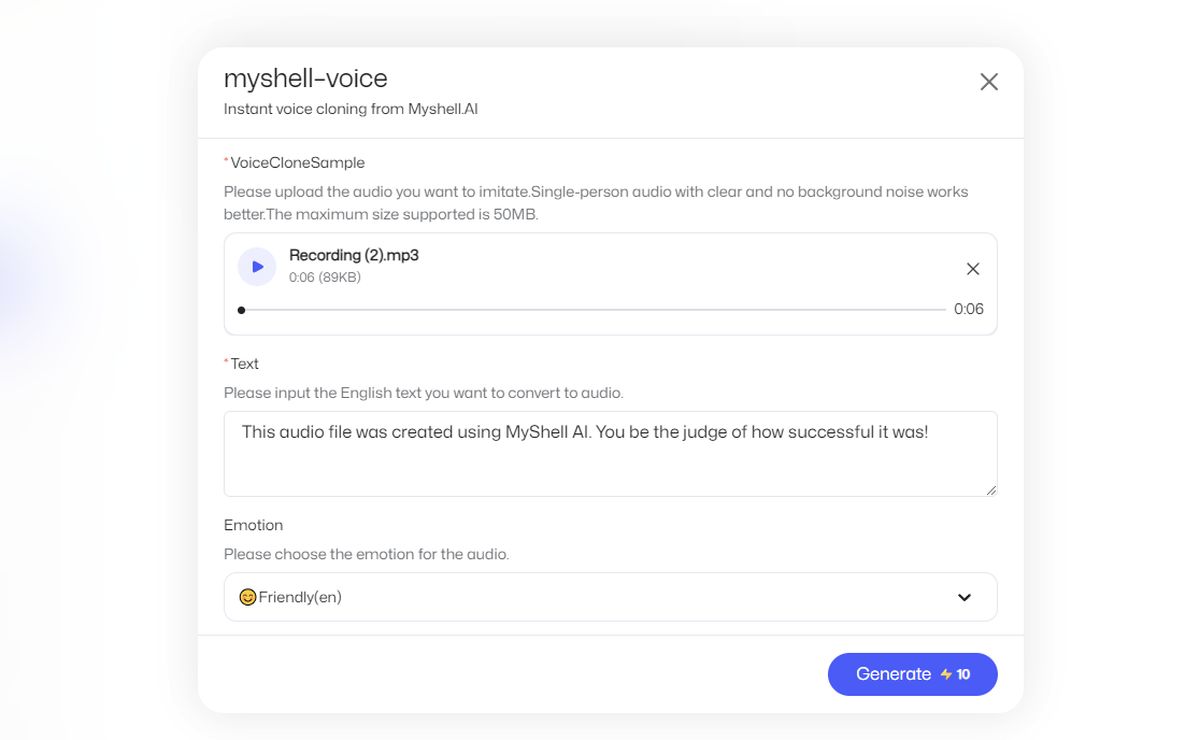

Sigue estos pasos:

- Vaya al sitio web oficial de MyShell AI.

- Haga clic en «Iniciar la aplicación»

- Seleccione «Chat» en el lado izquierdo.

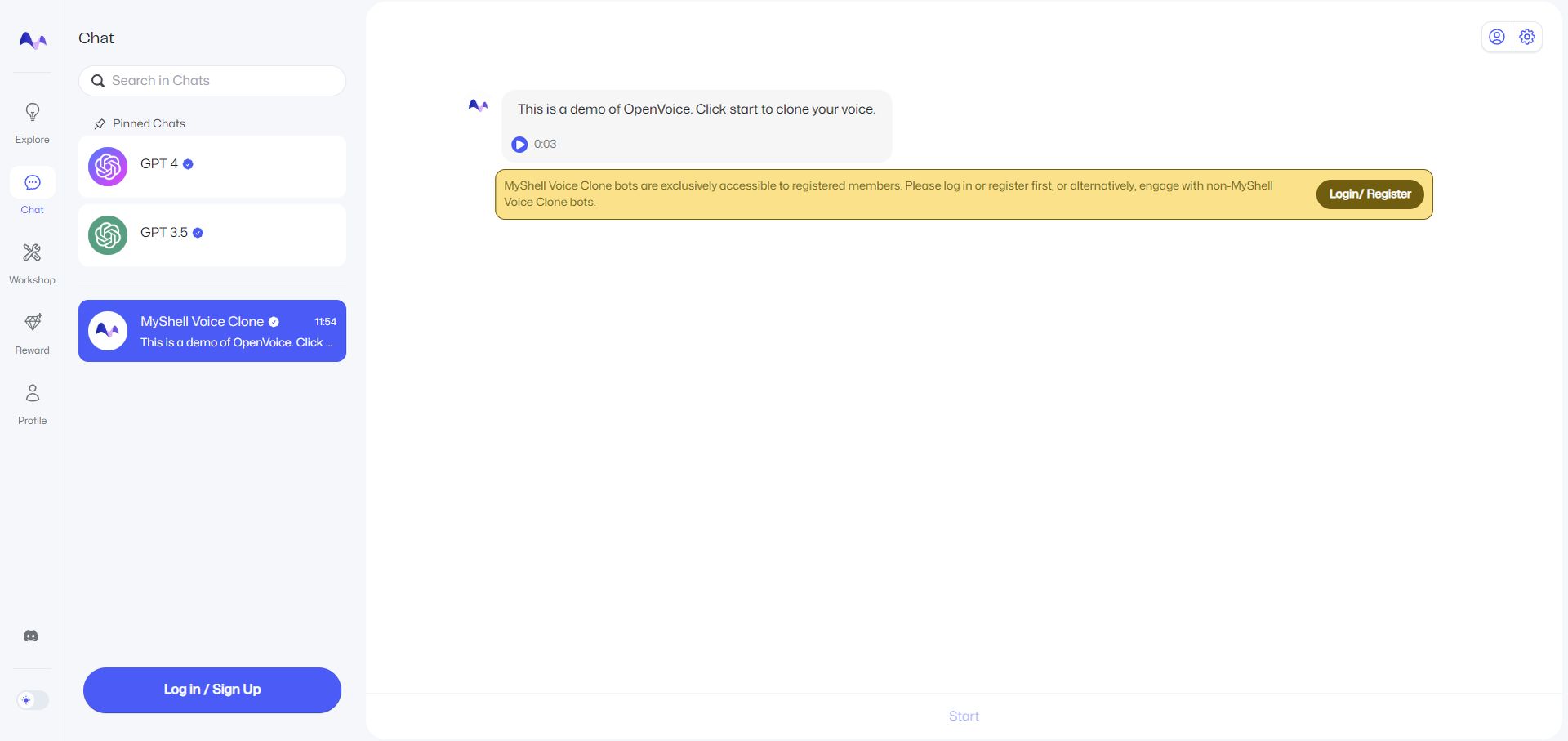

- Para utilizar la función «MyShell Voice Clone», debe registrarse con una cuenta. Siempre puedes usar una cuenta de Google.

- Luego haga clic en «Inicio», que se encuentra en la parte inferior de la página.

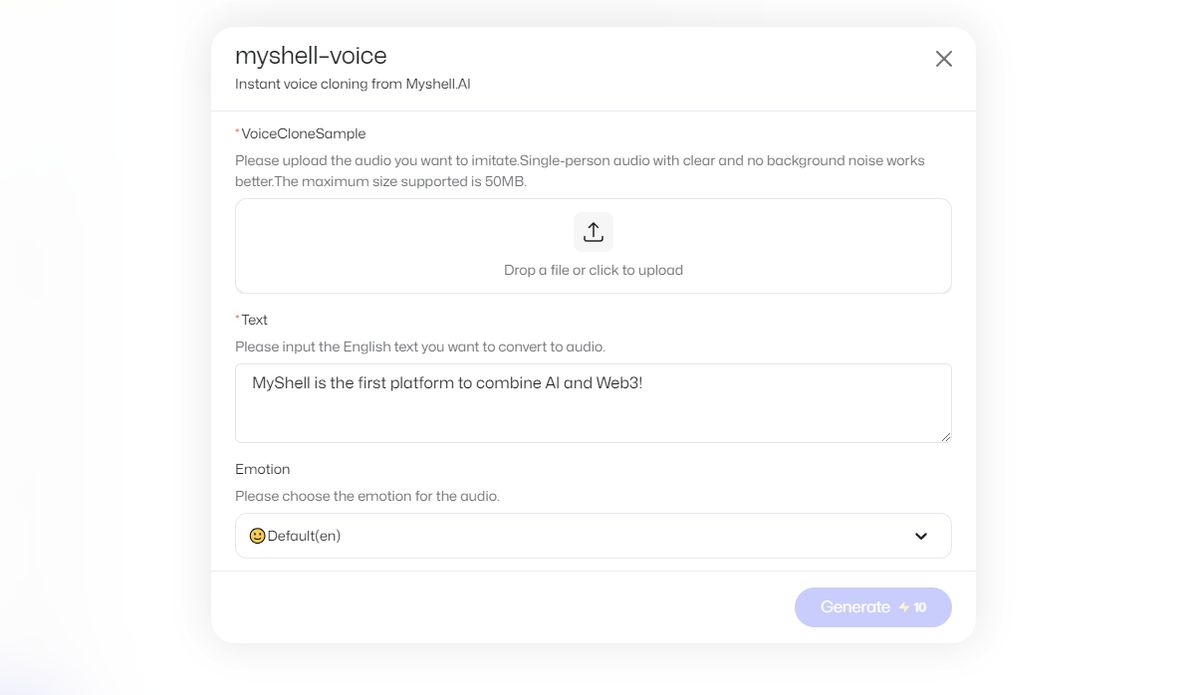

- Cargue una grabación de voz e ingrese el texto en inglés que desea convertir a audio.

- Presiona «Generar», esto costará 10 monedas en la aplicación.

- Su salida se le enviará a través del chat.

Nota del editor: Como referencia, subí una grabación de voz propia que dice: «La tecnología de clonación de voz está avanzando y empresas emergentes como ElevenLabs han logrado avances notables».

Luego, solicitó una salida, que dice: “Este archivo de audio fue creado usando MyShell AI. ¡Sé tú quien juzgue el éxito que tuvo!

Aporte:

Producción:

No diría que el resultado fue muy exitoso, pero es sorprendente ver lo rápido que es. Agregue que no soy un hablante nativo.

¿Cómo funciona la tecnología OpenVoice?

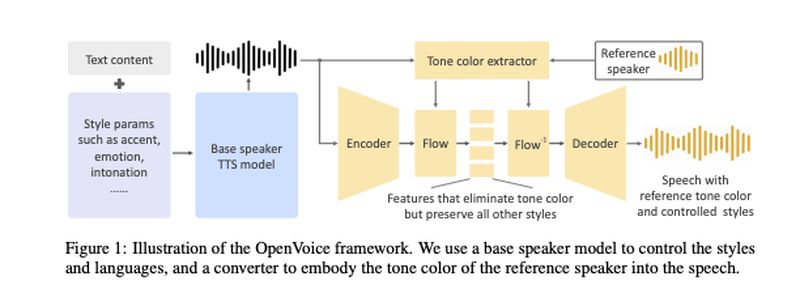

La tecnología OpenVoice, desarrollada por Qin, Wenliang Zhao y Xumin Yu de la Universidad de Tsinghua, junto con Xin Sun de MyShell, se articula en su artículo científico. Esta IA de clonación de voz se basa en una arquitectura de modelo dual: un modelo de texto a voz (TTS) y un «convertidor de tonos».

El modelo TTS es responsable de gestionar los parámetros de estilo y los idiomas. Se sometió a una formación utilizando 30.000 frases de muestras de audio, que incluían voces con acento estadounidense y británico en inglés, así como hablantes de chino y japonés. Estas muestras fueron etiquetadas distintivamente para reflejar las emociones expresadas en ellas. La modelo aprendió matices como la entonación, el ritmo y las pausas de estos clips.

Por otro lado, el modelo de convertidor de tonos se entrenó con un extenso conjunto de datos de más de 300.000 muestras de audio de más de 20.000 hablantes diferentes.

En ambos modelos, el audio del habla humana se transformó en fonemas, las unidades de sonido básicas que diferencian las palabras. Luego, estos se representaron mediante incrustaciones de vectores.

El proceso único implica el uso de un «altavoz base» en el modelo TTS, combinado con un tono derivado del audio grabado del usuario. Esta combinación permite a los modelos no sólo reproducir la voz del usuario sino también modificar el «color de tono», es decir, la expresión emocional del texto hablado.

El equipo incluyó un diagrama en su artículo para ilustrar cómo interactúan estos dos modelos:

Destacan que su método es conceptualmente sencillo pero eficaz. También requiere muchos menos recursos informáticos en comparación con otros métodos de clonación de voz, como Meta’s Voicebox.

“Queríamos desarrollar el modelo de clonación de voz instantánea más flexible hasta la fecha. Flexibilidad aquí significa control flexible sobre estilos/emociones/acento, etc., y puede adaptarse a cualquier idioma. Nadie podía hacer esto antes porque es demasiado difícil. Lidero un grupo de científicos experimentados en IA y dediqué varios meses a encontrar la solución. Descubrimos que existe una manera muy elegante de desacoplar la tarea difícil en algunas subtareas factibles para lograr lo que parece demasiado difícil en su conjunto. El proceso desacoplado resulta muy efectivo pero también muy simple”, afirmó Qin en un correo electrónico informado por VentureBeat.